Σε διαρκή ετοιμότητα. Φωνή, ιδιωτικότητα και ελευθερία επιλογής

Γράφει η Αλεξάνδρα Μελισσηνού*

Μια υπόθεση εργασίας

Ας φανταστούμε το εξής: βρισκόμαστε στον καναπέ, έτοιμοι να ξεκινήσουμε την αγαπημένη μας σειρά. Τα φώτα είναι λίγο πιο έντονα απ’ όσο θα θέλαμε, αλλά κανείς δεν σηκώνεται. Αντί γι’ αυτό, απευθυνόμαστε σε μια συσκευή στο σαλόνι και μέσα σε λίγα δευτερόλεπτα ο φωτισμός προσαρμόζεται. Η τεχνολογία λειτουργεί αθόρυβα, αποτελεσματικά, σχεδόν μαγικά. Για την Αλεξάνδρα που μιλά, η εμπειρία μοιάζει απλή. Για τη «Alexa» που ακούει, ξεκινά μια πιο σύνθετη διαδικασία στο παρασκήνιο.

Αυτή είναι η γοητεία των φωνητικών ψηφιακών βοηθών: υπόσχονται ευκολία, ταχύτητα και λιγότερη προσπάθεια. Μαζί με την άνεση, όμως, αναδύεται ένα ερώτημα που σπάνια τίθεται με την ίδια ευκολία. Τι σημαίνει αυτή η διευκόλυνση για την ιδιωτικότητα και τον έλεγχο των προσωπικών μας δεδομένων;

Σε αντίθεση με άλλες ψηφιακές υπηρεσίες, οι φωνητικοί βοηθοί δεν περιορίζονται σε μια οθόνη που ανοίγουμε και κλείνουμε. Βρίσκονται μόνιμα μέσα στο σπίτι, στον πιο προσωπικό μας χώρο και βασίζονται στη φωνή μας για να λειτουργήσουν. Δεν αλληλοεπιδρούμε απλώς μαζί τους, τους επιτρέπουμε να βρίσκονται διαρκώς «σε ετοιμότητα», σε ένα περιβάλλον όπου μιλάμε πιο χαλαρά και αυθόρμητα, συχνά χωρίς να συνειδητοποιούμε ότι η ομιλία μας μπορεί να μετατραπεί σε δεδομένο.

Η συζήτηση για την ιδιωτικότητα συχνά απλοποιείται υπερβολικά και καταλήγει στο επιχείρημα ότι «όποιος δεν έχει κάτι να κρύψει, δεν έχει λόγο να ανησυχεί». Στην πραγματικότητα, όμως, η ιδιωτικότητα δεν αφορά μόνο το αν μας βλέπουν ή μας ακούν. Αφορά τον χώρο μέσα στον οποίο μπορούμε να υπάρχουμε χωρίς αδικαιολόγητη παρέμβαση, να επικοινωνούμε, να κάνουμε επιλογές και, εξίσου σημαντικό, να αλλάζουμε γνώμη.

Γι’ αυτό και η ιδιωτικότητα συνδέεται στενά με την αυτονομία και την ελευθερία επιλογής. Σε ακρόαση στο Κογκρέσο, ο Mark Zuckerberg απέφυγε να απαντήσει στο ερώτημα σε ποιο ξενοδοχείο είχε διανυκτερεύσει το προηγούμενο βράδυ. Η αμηχανία αυτή δεν υποδηλώνει κάτι ύποπτο, αλλά την αναγνώριση ότι ορισμένες πληροφορίες ανήκουν στη σφαίρα του ιδιωτικού.

Το παρόν άρθρο εστιάζει στους φωνητικούς βοηθούς, όπου η συλλογή και επεξεργασία δεδομένων πραγματοποιείται με τη συγκατάθεση του χρήστη, αναδεικνύοντας ωστόσο ότι ο τρόπος σχεδιασμού των συστημάτων και η περαιτέρω αξιοποίηση των δεδομένων μπορούν να επηρεάσουν την ιδιωτικότητα, ακόμη, και χωρίς ευθεία παραβίαση του νόμου. Στο πλαίσιο αυτό, οι φωνητικοί βοηθοί αποτελούν χαρακτηριστικό παράδειγμα της σύγχρονης «ανταλλαγής» μεταξύ ευκολίας και ελέγχου, καθώς η χρήση τους εγείρει συναφή ζητήματα στην Ευρωπαϊκή Ένωση, όχι ως έκφραση τεχνοφοβίας ή αντίθεσης στην καινοτομία, αλλά ως αφορμή για κριτική σκέψη γύρω από τον τρόπο με τον οποίο η τεχνολογία σχεδιάζεται, ενσωματώνεται και ρυθμίζεται.

Τι είναι οι φωνητικοί βοηθοί και γιατί μας αφορούν

Οι φωνητικοί βοηθοί είναι ψηφιακές υπηρεσίες που μας επιτρέπουν να αλληλεπιδρούμε με την τεχνολογία χρησιμοποιώντας μόνο τη φωνή μας. Με μια απλή εντολή μπορούμε να χαμηλώσουμε τα φώτα, να ακούσουμε ειδήσεις ή να ρυθμίσουμε τη θερμοκρασία, χωρίς να αγγίξουμε καμία συσκευή. Στην καθημερινότητα συχνά ταυτίζονται με το αντικείμενο στο οποίο «ζουν», όπως ένα έξυπνο ηχείο ή ένα κινητό τηλέφωνο. Στην πραγματικότητα, όμως, πρόκειται για λογισμικό που λειτουργεί στο παρασκήνιο και συνδέει τη φωνή του χρήστη με ένα ευρύτερο ψηφιακό οικοσύστημα υπηρεσιών. Στην Ευρώπη, οι πιο διαδεδομένοι είναι η Alexa της Amazon, το Google Assistant και η Siri της Apple.

Παρότι ενσωματώνονται σε προσωπικές συσκευές, οι φωνητικοί βοηθοί δεν λειτουργούν ως απομονωμένα συστήματα. Στην πράξη, δεν υπάρχει «η Alexa του σπιτιού μου». Πίσω από κάθε συσκευή βρίσκεται ένα ενιαίο σύστημα στο cloud, ένα κοινό «μυαλό», που τροφοδοτείται από τις αλληλεπιδράσεις εκατομμυρίων χρηστών. Κάθε φωνητική εντολή δεν εξυπηρετεί μόνο τη συγκεκριμένη στιγμή, αλλά συμβάλλει στη συνολική εκμάθηση και εξέλιξη του βοηθού.

Για να ανταποκριθεί σε μια εντολή, ο φωνητικός βοηθός βρίσκεται σε διαρκή ετοιμότητα για τον εντοπισμό της λέξης ενεργοποίησης (wake word). Κατ’ αρχήν, η αποστολή και επεξεργασία φωνητικών δεδομένων ξεκινά μετά την ενεργοποίηση αυτή. Ωστόσο, δεν αποκλείονται ακούσιες ενεργοποιήσεις, ιδίως σε περιβάλλοντα με θόρυβο ή πολλούς ομιλητές, με αποτέλεσμα την καταγραφή ομιλιών που δεν προορίζονταν για τη συσκευή.

Για να προσφέρουν φυσική και εξατομικευμένη εμπειρία, οι φωνητικοί βοηθοί δεν επεξεργάζονται μόνο μεμονωμένες εντολές. Διατηρούν και αναλύουν προηγούμενες αλληλεπιδράσεις, ώστε να προσαρμόζουν τη συμπεριφορά τους στον χρήστη. Εδώ αναδεικνύεται μια κρίσιμη διάκριση. Άλλο η απολύτως αναγκαία επεξεργασία για την εκτέλεση μιας εντολής και άλλο η περαιτέρω αξιοποίηση των δεδομένων για σκοπούς όπως η εκπαίδευση αλγορίθμων, η ανάλυση χρήσης ή η κατάρτιση προφίλ.

Το ζήτημα γίνεται ακόμη πιο σύνθετο επειδή οι φωνητικοί βοηθοί τοποθετούνται σε χώρους της οικίας που χρησιμοποιούνται από περισσότερα άτομα. Εκεί ενδέχεται να βρίσκονται σύντροφοι, παιδιά ή επισκέπτες, οι οποίοι δεν απευθύνονται στη συσκευή, αλλά, απλώς μιλούν μεταξύ τους ή κινούνται στον χώρο, χωρίς να έχουν επιλέξει οι ίδιοι τη χρήση της, ούτε να είναι ενημερωμένοι για τον τρόπο λειτουργίας της. Έτσι, η τεχνολογία δεν αφορά μόνο τον κύριο χρήστη, αλλά, εκτείνεται σε ένα ευρύτερο κοινωνικό περιβάλλον γύρω από τη συσκευή.

Οι διακρίσεις αυτές δεν είναι θεωρητικές. Το 2019 αποκαλύφθηκε ότι αποσπάσματα ηχογραφήσεων από φωνητικούς βοηθούς μεγάλων τεχνολογικών εταιρειών, όπως η Amazon και η Google, αξιολογούνταν από ανθρώπους για την εκπαίδευση των συστημάτων αναγνώρισης ομιλίας. Οι ηχογραφήσεις δεν περιορίζονταν σε συνειδητές φωνητικές εντολές, αλλά περιλάμβαναν και ακούσιες ενεργοποιήσεις, καταγράφοντας στιγμές της καθημερινής ζωής στο σπίτι, όπως μια συζήτηση, ένα γέλιο ή έναν διαπληκτισμό. Πολλοί χρήστες αγνοούσαν ότι τα δεδομένα αυτά δεν υφίσταντο αποκλειστικά αυτοματοποιημένη επεξεργασία.

Το ευρωπαϊκό νομικό πλαίσιο

Στο ευρωπαϊκό δίκαιο, η λειτουργία των φωνητικών βοηθών διέπεται από τον Γενικό Κανονισμό Προστασίας Δεδομένων (ΓΚΠΔ), ο οποίος επιτρέπει υπό προϋποθέσεις τη συλλογή και επεξεργασία προσωπικών δεδομένων, όπως η φωνή. Παράλληλα, εφαρμόζεται η Οδηγία e-Privacy, η οποία ρυθμίζει την πρόσβαση στον τερματικό εξοπλισμό του χρήστη, δηλαδή, στο μικρόφωνο της συσκευής.

Σύμφωνα με την Οδηγία e-Privacy, η πρόσβαση στο μικρόφωνο επιτρέπεται, κατά κανόνα, μόνο εφόσον ο χρήστης έχει δώσει εκ των προτέρων τη συγκατάθεσή του. Εξαίρεση προβλέπεται μόνο όταν η πρόσβαση είναι απολύτως αναγκαία για την παροχή μιας υπηρεσίας που ο ίδιος ζήτησε ρητά. Έτσι, η καταγραφή φωνής που απαιτείται για την εκτέλεση μιας συγκεκριμένης εντολής μπορεί να θεωρηθεί θεμιτή. Δεν ισχύει όμως το ίδιο για ακούσιες ενεργοποιήσεις ή για την καταγραφή φωνών τρίτων που δεν έχουν συναινέσει.

Ακόμη κι όταν υπάρχει συγκατάθεση ή άλλη νόμιμη βάση, η επεξεργασία δεν είναι άνευ όρων. Ο ΓΚΠΔ θέτει ποιοτικά όρια στη συλλογή και επεξεργασία προσωπικών δεδομένων μέσω των θεμελιωδών αρχών του άρθρου 5, ιδίως του περιορισμού του σκοπού συλλογής των προσωπικών δεδομένων, της απαγόρευσης περαιτέρω επεξεργασίας αυτών και της ελαχιστοποίησης των δεδομένων. Συγκεκριμένα, τα δεδομένα πρέπει να συλλέγονται για σαφείς σκοπούς, γνωστούς στον χρήστη εκ των προτέρων και να περιορίζονται σε όσα είναι πράγματι κατάλληλα, συναφή και αναγκαία για τους σκοπούς αυτούς. Η συλλογή πληροφοριών για μελλοντική χρήση ή επειδή η τεχνολογία το επιτρέπει δεν συμβαδίζει με το πνεύμα του ΓΚΠΔ.

Στην περίπτωση των φωνητικών βοηθών, η εφαρμογή των αρχών αυτών είναι ιδιαίτερα απαιτητική. Η συνεχής εκμάθηση των συστημάτων μπορεί να οδηγήσει στη δημιουργία νέων χρήσεων των δεδομένων, όπως η εξαγωγή συμπερασμάτων για συνήθειες ή συναισθηματικές καταστάσεις. Έτσι, το όριο ανάμεσα στην παροχή της υπηρεσίας και τη διευρυμένη αξιοποίηση των δεδομένων γίνεται ολοένα και πιο δυσδιάκριτο.

Στο ίδιο πλαίσιο εντάσσεται και το άρθρο 22 του ΓΚΠΔ, το οποίο ρυθμίζει την αυτοματοποιημένη λήψη αποφάσεων και την κατάρτιση προφίλ. Αν και η διάταξη επιτρέπει τέτοιες πρακτικές, μεταξύ άλλων όταν στηρίζονται σε ρητή συγκατάθεση, η συγκατάθεση αυτή δεν αναιρεί την υποχρέωση τήρησης των θεμελιωδών αρχών, ούτε απαλλάσσει τον υπεύθυνο επεξεργασίας από την ανάγκη ουσιαστικών εγγυήσεων και διαφάνειας.

Τέλος, αξίζει να σημειώσουμε ότι η προστασία της ιδιωτικότητας δεν αρχίζει τη στιγμή που ο χρήστης μιλά στη συσκευή, αλλά πολύ νωρίτερα, στον τρόπο με τον οποίο η τεχνολογία έχει σχεδιαστεί. Ο ΓΚΠΔ απαιτεί η προστασία των δεδομένων να ενσωματώνεται εξαρχής στη λειτουργία της υπηρεσίας και όχι να ενεργοποιείται εκ των υστέρων μέσω ρυθμίσεων. Στην πράξη, αυτό σημαίνει ότι δεν αρκεί ο χρήστης να μπορεί κάποτε να διαγράψει ηχογραφήσεις. Σημασία έχει αν η ίδια η συσκευή έχει σχεδιαστεί ώστε να συλλέγει όσο το δυνατόν λιγότερα δεδομένα, για όσο το δυνατόν μικρότερο χρονικό διάστημα και μόνο για πολύ συγκεκριμένους σκοπούς. Όταν η συνεχής συλλογή αποτελεί τον κανόνα, η ιδιωτικότητα παύει να είναι προεπιλογή και γίνεται εξαίρεση.

Λίγες σκέψεις ακόμα

Το ερώτημα, τελικά, δεν είναι αν οι φωνητικοί βοηθοί είναι «καλοί» ή «κακοί». Είναι τεχνολογίες που εγκαθίστανται στον πιο προσωπικό μας χώρο και, ακριβώς γι’ αυτό, επηρεάζουν τον τρόπο με τον οποίο κινούμαστε, μιλάμε και επιλέγουμε, συχνά χωρίς να το αντιλαμβανόμαστε.

Συχνά ακούγεται το επιχείρημα: και τι πειράζει; Αν η συσκευή καταλαβαίνει καλύτερα πώς νιώθουμε, αν μας μιλά πιο «ανθρώπινα» ή μας προτείνει πράγματα που μας ταιριάζουν, δεν πρόκειται απλώς για μια πιο άνετη εμπειρία;

Το ζήτημα δεν είναι η άνεση αυτή καθαυτή. Το ζήτημα είναι πότε η προσαρμογή μετατρέπεται σε καθοδήγηση. Πότε η τεχνολογία παύει να απαντά σε ό,τι ζητάμε και αρχίζει, διακριτικά, να διαμορφώνει τι θα ζητήσουμε στη συνέχεια. Όχι με επιβολή, αλλά με μικρές, συνεχείς παρεμβάσεις που δύσκολα γίνονται αντιληπτές.

Σε αυτό το σημείο, η ιδιωτικότητα δεν αφορά απλώς το αν καταγράφεται η φωνή μας. Αφορά το αν διατηρούμε τον έλεγχο των επιλογών μας. Το αν μπορούμε να σκεφτούμε, να μιλήσουμε και να αλλάξουμε γνώμη χωρίς να εντασσόμαστε σιωπηλά σε προφίλ που λειτουργούν στο παρασκήνιο.

Το ευρωπαϊκό νομικό πλαίσιο προσφέρει σημαντικές εγγυήσεις. Η ουσιαστική του αξία, όμως, δεν εξαντλείται στη συγκατάθεση. Κρίνεται στο αν η προστασία της ιδιωτικότητας έχει προβλεφθεί εξαρχής στον σχεδιασμό της τεχνολογίας ή αν μεταφέρεται, εκ των υστέρων, στον χρήστη ως βάρος διαχείρισης.

Σε μια εποχή όπου η τεχνολογία υπόσχεται να μας κάνει τη ζωή πιο εύκολη, το πραγματικό διακύβευμα δεν είναι αν μας ακούει μια συσκευή. Είναι αν παραμένουμε ελεύθεροι να επιλέγουμε τον τρόπο με τον οποίο ζούμε, μιλάμε και υπάρχουμε ακόμη και όταν απλώς καθόμαστε στον καναπέ και ζητάμε να χαμηλώσουν τα φώτα.

*Η Αλεξάνδρα Μελισσηνού είναι νομικός με ειδίκευση στο Δίκαιο Διανοητικής Ιδιοκτησίας. Είναι κάτοχος μεταπτυχιακού τίτλου (LLM in Intellectual Property) από το Queen Mary University of London και τα επαγγελματικά της ενδιαφέροντα εστιάζουν στα άυλα αγαθά και τα ψηφιακά δικαιώματα.

Αόρατες προκαταλήψεις: Η περίπτωση της τεχνητής νοημοσύνης και της έμφυλης διάστασης

Γράφει η Θεοδώρα Τσούτσα*

Η χρήση της τεχνητής νοημοσύνης όπως γίνεται καθημερινά ολοένα και πιο αντιληπτό γίνεται αναπόσπαστο κομμάτι σε πάρα πολλούς τομείς, όπως οι επιχειρήσεις, η εκπαίδευση, η υγεία κτλ. Παρόλα αυτά δεν πρέπει να ξεχνάει κανείς ότι και η τεχνητή νοημοσύνη (ΤΝ) είναι κατασκευασμένη και εκπαιδευμένη από ανθρώπους, που μπορεί και οι ίδιοι να κουβαλάνε προκαταλήψεις, οι οποίες πολλές φορές με ακούσιο τρόπο και αφιλτράριστα περνάνε στους αλγόριθμους.

Αυτή η συνειδητοποίηση ανοίγει χώρο για περισσότερες σκέψεις από ποτέ, σχετικά με το τι αντίκτυπο μπορεί να έχει η ανθρώπινη αντίληψη πάνω στον αλγόριθμο και υπογραμμίζει την σημασία μιας ολιστικής και με διαφάνεια προσέγγισης όταν εκπαιδεύουμε εργαλεία. Πιο συγκεκριμένα εάν δεν υπάρχει μια ολοκληρωμένη εποπτεία μπορεί να επηρεάσει μεροληπτικά και να διαιωνίσει προκαταλήψεις σε βάρος κάποιων συγκεκριμένων, συνήθως πιο ευάλωτων ή/και περιθωριοποιημένων κοινοτήτων. Το συγκεκριμένο άρθρο θα εστιάσει στην διάσταση του φύλου, η οποία πολλές φορές δεν λαμβάνεται υπόψιν σε βάθος, όταν πρόκειται για την δημιουργία ενός αλγόριθμου.

Μελέτες περίπτωσης

1.Ένα χαρακτηριστικό πρώτο παράδειγμα αποτελεί η προσπάθεια της Amazon να αναπτύξει έναν αυτοματοποιημένο αλγόριθμο πρόσληψης. Αυτή ήταν μια αποτυχημένη απόπειρα η οποία δεν διήρκησε αρκετό καιρό καθώς τα δεδομένα εκπαίδευσης αποδείχθηκαν άκρως προκατειλημμένα και σεξιστικά. Πιο συγκεκριμένα ο αλγόριθμος επειδή είχε εκπαιδευτεί με βάση προηγούμενα βιογραφικά υψηλής αξιολόγησης, τα οποία προέρχονταν κυρίως από άντρες, «έμαθε» να ευνοεί άντρες υποψηφίους, αναπαράγοντας ήδη υπάρχουσες ανισορροπίες στον χώρο της εργασίας, κάτι που οδήγησε στην εγκατάλειψη του έργου. Εδώ παρατηρούμε πως η προκατάληψη απέναντι στο φύλο μέσω συστημάτων ΤΝ μπορεί να είναι δύσκολο να γίνει ευδιάκριτη με αποτέλεσμα τα άτομα να αδικούνται, και να επηρεάζονται οι ευκαιρίες και οι δυνατότητες που έχουν, μέσω αυτής της αναπαραγωγής των στερεοτύπων.

Ακόμα μια τέτοια περίπτωση όπως αυτή της Amazon αντικατοπτρίζει μια διαχρονική προβληματική, αυτή της ιστορικής ανδροκρατίας στη βιομηχανία και τις επιχειρήσεις και αναδεικνύει πόσο εύκολα κάτι τέτοιο μπορεί να ενσωματωθεί στους αλγόριθμους. Αποτελεί χαρακτηριστικό παράδειγμα της διαιώνισης του κοινωνικού φαινομένου της «γυάλινης οροφής» , των αόρατων δηλαδή εμποδίων που περιορίζουν τις επαγγελματικές προοπτικές των γυναικών.

2.Μία ακόμα περίπτωση στον τομέα του ελέγχου της μετανάστευσης είναι το πιλοτικό σύστημα, αποκλειστικά ερευνητικού χαρακτήρα, iBorderCtrl , ένα εργαλείο ανίχνευσης ψεύδους και αναγνώρισης προσώπου για την είσοδο ταξιδιωτών στην ΕΕ. Ένα ακόμα σύστημα που διακόπηκε, προκαλώντας έντονη ανησυχία σχετικά με την προστασία των ανθρωπίνων δικαιωμάτων. Ιδιαίτερα, έγειρε ανησυχίες σχετικά με προκαταλήψεις απέναντι στο φύλο αλλά και στην φυλή μέσω της ΤΝ , οι οποίες θα μπορούσαν να οδηγήσουν σε διακριτική μεταχείριση των ταξιδιωτών. Συγκεκριμένα, οι αλγόριθμοι θα μπορούσαν να παρερμηνεύσουν τις εκφράσεις του προσώπου των γυναικών, αντανακλώντας κοινωνικές προκαταλήψεις που αντιλαμβάνονται τις γυναίκες ως πιο συναισθηματικές ή λιγότερο αξιόπιστες, αυξάνοντας έτσι την πιθανότητα ψευδώς θετικών ανιχνεύσεων μεταξύ των γυναικών ταξιδιωτών. Ουσιαστικά εδώ η έλλειψη ποικιλομορφίας στα δεδομένα εκπαίδευσης έκανε το iΒorderctrl να ενσωματώνει έμφυλες και φυλετικές προκαταλήψεις, οδηγώντας σε ανακριβείς ή μεροληπτικές αξιολογήσεις απέναντι σε μη Ευρωπαίους, γυναίκες και μη δυαδικά άτομα. Η αδιαφάνεια του συστήματος και οι λανθασμένες υποθέσεις περί καθολικών εκφράσεων συμπεριφοράς ενίσχυσαν τον κίνδυνο διακρίσεων στα σύνορα της ΕΕ. Αυτό αναδεικνύει την ανάγκη της λογοδοσίας και της διαφάνειας στην ανάπτυξη συστημάτων ΤΝ, έτσι ώστε να μην απειλείτε η ισότητα και η προστασία των ανθρωπίνων δικαιωμάτων τόσο στα σύνορα, όσο και γενικότερα.

3.Ένα τελευταίο και μόνιμα πλέον επίκαιρο εργαλείο που αντανακλά το φαινόμενο των προκαταλήψεών, είναι η κατασκευή των chatbots (πχ ChatGpt).Παρότι κατασκευάστηκαν για να είναι άμεσα, αντικειμενικά και αμερόληπτα , δεν πρέπει να ξεχνάμε πως και αυτά χτίζονται πάνω σε ανθρώπινες μεροληψίες με αποτέλεσμα όχι μόνο να αντικατοπτρίζουν υπάρχουσες προκαταλήψεις, αλλά και να τις ενισχύουν.Πιο συγκεκριμένα όσο ένα σύστημα τροφοδοτείτε με προκατειλημμένα στοιχεία από τον εκπαιδευτή, τα δίνει στον χρήστη και ο χρήστης συνεχίζοντας μια συνομιλία πάνω στα δεδομένα αυτά δημιουργεί ένα φαύλο κύκλο όπου η μεροληψία συνεχίζεται και αναπαράγεται. (bias in – bias out). Έτσι το εργαλείο αυτό, όχι απλά γίνεται εργαλείο μη προόδου, αλλά και μηχανισμός συντήρησης στερεοτύπων σε μεγαλύτερη και ταχύτερη εμβέλεια.

Φυσικά το πρόβλημά αυτό επιτείνεται και από την άνιση εκπροσώπηση των φύλων στον τεχνολογικό τομέα. Το 2019 μόλις το 26% των θέσεων εργασίας στους τομείς των δεδομένων και της τεχνητής νοημοσύνης καταλαμβάνονται από γυναίκες (World Economic Forum 2019), ενώ το 2025 το ποσοστό αυτό καταφέρνει να φτάσει περίπου στο 35% (World Economic Forum 2025). Η αύξηση αυτή θα μπορούσε να χαρακτηριστεί αργή αλλά και μη αντιπροσωπευτική. Μια τέτοια ανισορροπία στην διαδικασία εκπαίδευσης αλγορίθμων σημαίνει ότι απουσιάζει η απαραίτητη ποικιλομορφία που θα εξασφάλιζε πιο ισορροπημένα και συμπεριληπτικά συστήματα.

Περνώντας στην νομική διάσταση

Τώρα περνώντας στην νομική διάσταση επισημαίνεται και η ανάγκη για μια πιο διαθεματική προσέγγιση, καθώς δεν πρέπει να ξεχνάμε πως οι γυναίκες δεν υφίστανται προκατάληψη μόνο λόγω φύλου, αλλά συχνά επιβαρύνονται με επιπλέον εμπόδια αν ανήκουν σε φυλετικές, εθνοτικές ή άλλες μειονεκτούσες ομάδες, αυξάνοντας τον κίνδυνο αποκλεισμού.

Τον Ιούλιο του 2024, περνάει σε ισχύ ο πρώτος ολοκληρωμένος Κανονισμός (2024/1689) στην Ευρωπαϊκή Ένωση σχετικά με την Τεχνητή νοημοσύνη, με σκοπό να ρυθμίσει την λειτουργία των συστημάτων ΤΝ μέσα σε διάφορα πλαίσια. Μέσα στην προσπάθεια αυτή ορίζει κάποια συστήματα και πρακτικές ως απαγορευμένες, και κάποιες ως υψηλού, μετρίου και χαμηλού κινδύνου. Παρατηρώντας κανείς τον κανονισμό αυτό σε βάθος θα εντοπίσει κάποιες ελλείψεις μη συμπερίληψης σχετικά με το φύλο , οι οποίες σχετίζονται κυρίως με την διάσταση της διαθεματικότητας, η οποία αναφέρθηκε και νωρίτερα.

Τα 3 βασικά σημεία που εντοπίζεται αυτό είναι τα άρθρα 5, 6 και 27. Αρχίζοντας με το άρθρο 5 του Νόμου, το οποίο ορίζει τις απαγορευμένες πρακτικές που μπορεί να θέσουν σε κίνδυνο τα θεμελιώδη ανθρώπινα δικαιώματα αλλά και την ασφάλεια των ατόμων παρατηρούμε ότι απαγορεύονται πρακτικές όπως η κοινωνική βαθμολόγηση και η χειραγώγηση ευάλωτων ατόμων. Παρότι κάνει σημαντικά βήματα και ρυθμίζει τη χρήση βιομετρικών συστημάτων που βασίζονται σε ευαίσθητα χαρακτηριστικά (π.χ. φυλή, σεξουαλικός προσανατολισμός), παραλείπει την ρητή αναφορά στο φύλο ως τέτοιο χαρακτηριστικό παρά τις σχετικές συστάσεις του Ευρωπαϊκού Συμβουλίου Προστασίας Δεδομένων. Αυτή η παράλειψη υπογραμμίζει ένα σημαντικό κενό στην προστασία της ισότητας των φύλων, αναδεικνύοντας έντονα την ανάγκη για διατομεακή προσέγγιση που να αντιμετωπίζει τις πολλαπλές μορφές διάκρισης στα συστήματα Τεχνητής Νοημοσύνης.

Το άρθρο 6 τώρα, καθώς ταξινομεί τα συστήματα τεχνητής νοημοσύνης υψηλού κινδύνου, εντοπίζεται να μην απαιτεί κανένα έλεγχο για διακρίσεις λόγω φύλου ή διαθεματικές διακρίσεις. Αντιθέτως, αναφέρεται πολύ γενικά στις αρχές μη διακριτικής μεταχείρισης που δεν εξασφαλίζουν την ουσιαστική ανίχνευση και τον μετριασμό των διακρίσεων λόγω φύλου και των διαρθρωτικών διακρίσεων στην τεχνητή νοημοσύνη υψηλού κινδύνου. Έτσι, η «ουδέτερη ως προς το φύλο» προσέγγιση δεν μπορεί να αποτυπώσει τις πραγματικές ανισότητες που βιώνουν οι περιθωριοποιημένες ομάδες φύλου.

Ολοκληρώνοντας στο άρθρο 27, ο νόμος τονίζει την ανάγκη για εκτίμηση επιπτώσεων των συστημάτων ΤΝ υψηλού κινδύνου, βασισμένη στο ήδη υπάρχων εργαλείο εκτίμησης επιπτώσεων για τα θεμελιώδη δικαιώματα (FRIA) προκειμένου να αξιολογηθούν και να μετριαστούν οι κίνδυνοι διακρίσεων. Ωστόσο, αυτές οι εκτιμήσεις δεν είναι ρητά προσαρμοσμένες για την αντιμετώπιση των διαθεματικών ευπαθειών ή των συστημικών προκαταλήψεων λόγω φύλου που ενσωματώνονται στα δεδομένα και στα συστήματα τεχνητής νοημοσύνης.

Επομένως, αν κάτι γίνεται αντιληπτό από την ανάλυση αυτή είναι, ότι ο Κανονισμός (2024/1689) σχετικά με τη Τεχνητή Νοημοσύνη οφείλει να ενσωματώσει ρητές διατάξεις που να ανταποκρίνονται στις ανάγκες των δύο φύλων. Χωρίς την ενσωμάτωση αυτή αλλά και της διαθεματικότητας, ο νόμος κινδυνεύει να μην προστατεύσει επαρκώς περιθωριοποιημένες ομάδες φύλου, οι οποίες επηρεάζονται δυσανάλογα από τις προκατειλημμένες εφαρμογές της ΤΝ. Ενώ ο νόμος διαθέτει μηχανισμούς για την αναγνώριση και τον μετριασμό ορισμένων ευπαθειών που σχετίζονται με το φύλο, δεν καταφέρνει να προστατέψει επαρκώς την δημιουργία συστημάτων σαν αυτά που αναφέρθηκαν νωρίτερα, πράγμα απαραίτητο για την ολοκληρωμένη αντιμετώπιση των συστημικών και δομικών προκαταλήψεων λόγω φύλου στην ΤΝ.

*Ονομάζομαι Θεοδώρα Τσούτσα, και έχω κάνει το μεταπτυχιακό μου πάνω στα ανθρώπινα δικαιώματα, στο οποίο μεταξύ των άλλων έγραψα την διπλωματική μου σχετικά με τα σύνορα και την τεχνητή νοημοσύνη. Πιο συγκεκριμένα το θέμα ήταν: «Convince the algorithm: How the digitalisation of European Union Borders could be a harmful tool for people on the move and their human rights.» Η έρευνα αυτή με έκανε να ανακαλύψω το ενδιαφέρον που έχω γενικότερα για την συσχέτιση των ανθρωπίνων δικαιωμάτων με την τεχνητή νοημοσύνη και τι κινδύνους μπορεί να εγκυμονεί στο μέλλον.

Διαχείριση Κινδύνου στον Ψηφιακό Κόσμο - Αγγαρεία ή Αναγκαιότητα;

Γράφει o Ιωάννης Ντόκος*

“Τίποτα στη ζωή δεν είναι βέβαιο παρά μόνο ο θάνατος και οι φόροι”, είπε κάποτε ο Benjamin Franklin (ή κάποιος προκάτοχός του). Η φράση όμως θα μπορούσε κάλλιστα να περιλαμβάνει ακόμα μία συνιστώσα, τον κίνδυνο. “Death, taxes and risk”. Στον ψηφιακό κόσμο, οι εκάστοτε κίνδυνοι είναι μία σταθερά που πρέπει μονίμως να λαμβάνουμε υπόψιν, είτε ως πολίτες, χρήστες προϊόντων ή υπηρεσιών, ή ως ειδήμονες στον κλάδο της διαχείρισης κινδύνων. Ας δούμε πώς η σωστή διαχείριση κινδύνου μπορεί να προσφέρει βεβαιότητα και ασφάλεια στον ψηφιακό χώρο.

Τί σημαίνει κίνδυνος, και γιατί χρήζει προσοχής;

Ο ψηφιακός κόσμος αλλάζει γρήγορα, καθημερινά. Η έννοια του κινδύνου, ωστόσο, είναι σχετικά στατική: κάθε σύστημα, κάθε πρόγραμμα, κάθε άνθρωπος που χρησιμοποιεί τεχνολογία δημιουργεί ένα “άνοιγμα”, ένα τρωτό σημείο. Αυτά τα ανοίγματα δεν είναι από μόνα τους επικίνδυνα, αλλά είναι ευάλωτα σε απειλές που μπορούν να τα εκμεταλλευτούν. Σκέψου, για παράδειγμα, ένα ελάττωμα σε ένα υπολογιστικό σύστημα μιας μονάδας επεξεργασίας πυρηνικής ενέργειας, μία ελλιπή διαδικασία πρόσβασης σε ευαίσθητα δεδομένα, ένα κακό “σετάρισμα” ενός διακόπτη δικτύου. Το καμπανάκι κινδύνου ηχεί.

Ο κίνδυνος υπάρχει πριν κάνεις οτιδήποτε, είναι “εγγενής”. Είναι εκεί by default, χωρίς να λαμβάνει υπόψη τυχόν μέτρα προστασίας. Όταν οδηγείς ένα ποδήλατο, η οδήγηση και μόνο ενέχει κίνδυνο. Στον ψηφιακό κόσμο, ο εγγενής κίνδυνος προκύπτει από πράγματα όπως η ανθρώπινη απροσεξία, η πολυπλοκότητα των συστημάτων ή η αξία των δεδομένων που μοιράζεσαι με άλλους. Από μόνος του ο κίνδυνος είναι μια βεβαιότητα, μια σταθερά της ζωής. Αυτό δε σημαίνει ότι τον αγνοούμε.

Ωραία ως εδώ. Το γεγονός ότι περνάω το κατώφλι της πόρτας κάθε πρωί είναι μια επικίνδυνη κατάσταση, θεωρητικά. Τί νόημα έχει οποιαδήποτε δράση αν ο κίνδυνος είναι ούτως ή άλλως εκεί; Η επόμενη φάση είναι να αναγνωρίσεις ποιοι κίνδυνοι χρήζουν προσοχής και δράσης. Εδώ χρειάζεται ψυχρή παρατήρηση και λογική σκέψη. Κάποιοι κίνδυνοι είναι πιο σημαντικοί από άλλους, επομένως πρέπει να περάσουν από το “κόσκινο” της διαχείρισης.

Υπολογισμός του κινδύνου

Στην πιο απλή του μορφή, ο κίνδυνος (ψηφιακός και μη) είναι απλά μια συνάρτηση πιθανότητας και αντίκτυπου. Ο εκάστοτε κίνδυνος επιφέρει (αρνητικές) συνέπειες (αντίκτυπος) με κάποια συχνότητα (πιθανότητα). Έχοντας τη δυνατότητα, με τρόπο ποσοτικό (με τη χρήση ακριβών και εμπεριστατωμένων αριθμών, συνήθως νομισματικών για τον αντίκτυπο και μονάδων ετήσιου ποσοστού εμφάνισης για την πιθανότητα) ή ποιοτικό (με πιο αυθαίρετους υπολογισμούς, συνήθως με χρήση κλίμακας από το 1 ως το 5) να υπολογίσουμε τις μεταβλητές της πιθανότητας και του αντικτύπου, μας φέρνει πιο κοντά στον υπολογισμό του κινδύνου.

Στο παράδειγμα της οδήγησης ποδηλάτου, ένας κίνδυνος είναι η αιφνίδια συνάντησή μου με μία καφέ αρκούδα (και οι δυσάρεστες συνέπειες που θα ακολουθήσουν). Η πιθανότητα να συμβεί αυτό αλλάζει ανάλογα με την περίσταση - εάν οδηγώ το ποδήλατό μου σε κάποια περιοχή του Κορυδαλλού, οι πιθανότητες να συναντήσω την αρκούδα αγγίζουν το μηδέν. Εάν πάλι έχω πάει για ποδηλασία στα βουνά της Πίνδου, η κατάσταση αλλάζει άρδην. Ο αντίκτυπος της συνάντησης με την αρκούδα αλλάζει επίσης. Εάν κουβαλάω σπρέι για αρκούδες ή έχω παρακολουθήσει πολλά βίντεο σχετικά με το πώς να αντιμετωπίσεις μια καφέ αρκούδα (ο υποφαινόμενος έχει παρακολουθήσει ουκ ολίγα τέτοια βίντεο), μπορεί να τη γλιτώσω με μώλωπες και γρατζουνιές (ή ένα σπασμένο ποδήλατο). Εάν πάλι στερούμαι γνώσης και εργαλείων, τα πράγματα δυσκολεύουν.

Εδώ διαφαίνεται και η σημασία των μέτρων προστασίας και η μετάβαση από τον εγγενή στον υπολειμματικό κίνδυνο. Μέσω των μέτρων προστασίας στη διάθεσή μου (σπρέι), μπορώ να χαμηλώσω τον αντίκτυπο της συνάντησης από τον βέβαιο θάνατο, στην εισαγωγή στο νοσοκομείο για ράμματα. Ο υπολειμματικός κίνδυνος είναι ο κίνδυνος που απομένει αφού πάρουμε μέτρα προστασίας κατά αυτού! Τα μέτρα προστασίας είναι αναπόσπαστο κομμάτι της διαχείρισης του κινδύνου.

Τρόποι διαχείρισης κινδύνου

Υπάρχουν τέσσερις ενδεδειγμένοι τρόποι αντιμετώπισης ενός κινδύνου, αφού γίνει αυτός αντιληπτός (και αφού υπολογιστεί ποσοτικά ή ποιοτικά). Οι επιλογές αυτές είναι: αποδοχή, μεταβίβαση, μείωση ή εξάλειψη.

Αποδοχή σημαίνει ότι καταλαβαίνεις τον κίνδυνο και τον κρατάς, όχι παθητικά ή με άγνοια, αλλά με λογική. Κάποιοι κίνδυνοι είναι τόσο μικροί που κοστίζει περισσότερο να τους αντιμετωπίσεις παρά να τους αποδεχτείς. Εάν οδηγώ το ποδήλατό μου στο κέντρο της πόλης, αποδέχομαι την απειροελάχιστη πιθανότητα (0.00001%) να μου επιτεθεί αρκούδα, και απολαμβάνω τη βόλτα μου.

Μεταβίβαση είναι η μετάθεση του κινδύνου σε άλλον (συνήθως μέσω ασφάλειας). Ο κίνδυνος δεν εξαφανίζεται, απλά αλλάζει χέρια. Η ευθύνη παραμένει σε αυτόν που υπόκειται στον κίνδυνο, απλά υπάρχει κάλυψη σε περίπτωση ζημίας λόγω του κινδύνου. Στο σενάριο με την αρκούδα ελπίζω η ασφάλειά μου να καλύπτει τέτοιες επιθέσεις, ή τουλάχιστον η οικογένειά μου να λάβει ένα χρηματικό ποσό (μέσω της ασφάλειας ζωής μου) σε περίπτωση που το σπρέι δε με βοηθήσει.

Μιας και μιλάμε για το σπρέι, αυτό είναι μέθοδος μείωσης του κινδύνου! Μείωση σημαίνει ότι περιορίζεις την πιθανότητα ή τον αντίκτυπο, και πρόκειται για την πιο συνηθισμένη μέθοδο αντιμετώπισης κινδύνων. Εδώ περιλαμβάνεται κάθε μορφή προληπτικής προστασίας. Κάθε μέτρο προστασίας που λαμβάνω στοχεύει στη μείωση του κινδύνου. Εάν έχω πάει για ποδηλασία στα βουνά της Πίνδου με 10 άλλους φίλους, οι πιθανότητες να επιτεθεί η αρκούδα σε εμένα αντί σε έναν από αυτούς μειώνονται ριζικά!.

Εξάλειψη είναι η πιο απόλυτη επιλογή, καθώς απομακρύνεσαι από τον κίνδυνο και την πηγή του. Η εξάλειψη είναι το τελικό ξεκαθάρισμα: η αναγνώριση ότι κάτι δεν επιδέχεται “μπαλώματα”. Υπάρχουν πολλές πεινασμένες αρκούδες στο βουνό που σκοπεύω να επισκεφτώ; Επιλέγω θάλασσα αντί για βουνό και έχω το κεφάλι μου ήσυχο!

Ενώ οι παραπάνω τρόποι αντιμετώπισης κινδύνου είναι όλοι δόκιμοι, υπάρχει μια αντίδραση που δεν είναι θεμιτή - η άγνοια κινδύνου. Το να γνωρίζουμε τον κίνδυνο και να επιλέγουμε συνειδητά να τον αγνοήσουμε θα οδηγήσει αναπόφευκτα σε αρνητικά αποτελέσματα!

Η αντιμετώπιση κινδύνου στον ψηφιακό κόσμο

Κίνδυνοι παρόμοιοι με την τυχαία συνάντηση με την αρκούδα υπάρχουν στον ψηφιακό και διαδικτυακό χώρο, μόνο που αντί για πεινασμένα τετράποδα, συναντούμε χάκερς, κακοστημένες πλατφόρμες, χρήση τεχνητής νοημοσύνης που προσβάλλει τα ανθρώπινα δικαιώματα και ελαττωματικούς εξοπλισμούς. Και με την ίδια λογική όπως την εκδρομή μας στο δάσος, οι κίνδυνοι αυτοί χρήζουν ειδικής μεταχείρισης, λαμβάνοντας υπόψη τις παρακάτω βασικές αρχές:

- Η διαχείριση κινδύνου δεν είναι μεμονωμένο συμβάν, αλλά κύκλος. Εντοπίζεις, αξιολογείς, ενεργείς, επανεξετάζεις τακτικά. Ο ψηφιακός κόσμος μεταβάλλεται συνεχώς, πράγμα που σημαίνει ότι η εικόνα του κινδύνου μεταβάλλεται εξίσου. Ό,τι ήταν ασφαλές το πρωί μπορεί να είναι τρωτό το βράδυ. Η τεχνολογία δεν περιμένει κανέναν - και οι σχετικοί κίνδυνοι πρέπει συνεχώς να καταγράφονται και να αντιμετωπίζονται.

- Η ολιστική αντιμετώπιση κινδύνων είναι κρίσιμη. Ένα κενό είναι αρκετό να προκαλέσει ριζικές βλάβες σε πολίτες, χρήστες, επιχειρήσεις. Η μερική προστασία δημιουργεί μια ψευδή αίσθηση ασφάλειας. Στον ψηφιακό χώρο, το αδύναμο σημείο συχνά δεν είναι το πιο εμφανές. Μπορεί να είναι το ξεχασμένο αρχείο, ο ανεπαρκής κωδικός, ο εξωτερικός συνεργάτης που χρησιμοποιεί μια εύθραυστη εφαρμογή. Απαιτείται επομένως συνολική θεώρηση.

- Χρειάζεται επίσης κατανόηση ότι ο κίνδυνος δεν είναι μόνο τεχνικός, αλλά και οργανωτικός, ανθρώπινος, ή διαδικαστικός. Στην πράξη, οι περισσότερες ζημιές προκύπτουν από λάθη, παραλείψεις, ή ασυνεννοησία. Η τεχνολογία απλώς οξύνει τις συνέπειες. Επομένως είναι απαραίτητο να τον αντιμετωπίζουμε από πολλές διαφορετικές πλευρές.

- Η επίγνωση και εκπαίδευση σε θέματα προστασίας πληροφοριών και δεδομένων είναι κλειδί στη μείωση κινδύνων. Όσο κι αν οργανωθείς, πάντα θα υπάρχει κάποιος να γράψει τους κωδικούς του σε κοινή θέα, να ανοίξει το λάθος αρχείο, να πατήσει κατά λάθος «διαγραφή». Το ανθρώπινο στοιχείο δεν εξαλείφεται.

- Πάντα η πρόληψη είναι φθηνότερη από την αποκατάσταση. Για τον απλό χρήστη, η διαχείριση κινδύνων ίσως μοιάζει με αγγαρεία, η πραγματικότητα όμως είναι ότι ο κόσμος της τεχνολογίας έχει μεγαλώσει τόσο, που η άγνοια κινδύνου κοστίζει. Όπως κανείς δεν περιμένει να βάλει συναγερμό αφού γίνει διάρρηξη, έτσι και η διαχείριση κινδύνου λειτουργεί καλύτερα πριν συμβεί το κακό.

Η ουσία της διαχείρισης κινδύνου είναι η στοχευμένη καθαρότητα: παρόλο που η απόλυτη ασφάλεια δεν είναι εφικτή, επιδιώκουμε την σταθερότητα προσπαθώντας να αποφύγουμε τα σημαντικά λάθη. Όταν καταλάβεις αυτό, η διαχείριση κινδύνου παύει να είναι βάρος. Γίνεται οργανωμένη και συντονισμένη προσπάθεια, και μετά συνήθεια. Ένα είδος νοητικού τεστ όπου ρωτάς: “Τι μπορεί να πάει στραβά; Πόσο με νοιάζει; Τι κάνω για αυτό;”. Όχι ως άσκηση φόβου, αλλά ως άσκηση καθαρού συλλογισμού και προστασίας. Ο κίνδυνος πάντα θα υπάρχει. Η διαχείρισή του είναι συνειδητή επιλογή, και η επίγνωσή του εργαλείο.

* Ο Ιωάννης Ντόκος είναι ειδικός διαχείρισης κινδύνου τεχνολογιών πληροφορίας (IT), προστασίας πληροφοριών και διαχείρισης κινδύνου τρίτων μερών, ενώ έχει γνώσεις στην προστασία προσωπικών δεδομένων. Ειδικεύεται στον ISO27001, NIST, NIS2 και τον Γενικό Κανονισμό Προστασίας Δεδομένων (ΓΚΠΔ). Στον ελεύθερό του χρόνο προσφέρει συμβουλές σταδιοδρομίας σε θέματα διακυβέρνησης πληροφορικής, κινδύνου και συμμόρφωσης μέσω του καναλιού του στο YouTube.

Με επιτυχία ολοκληρώθηκε η εκδήλωσή μας για το GAIN με τις εποπτικές αρχές του Άρθρου 77 ΑΙ Act

Με επιτυχία ολοκληρώθηκε η χθεσινή εκδήλωση που διοργανώνσαμε με το δίκτυο ΟΚοιΠ Greek AI Network – GAIN στα γραφεία του μέλους του δικτύου WHEN Hub!

Η εκδήλωση ξεκίνησε με εισαγωγική ομιλία του Συνιδρυτή και Ταμία του ΔΣ μας Κωνσταντίνου Κακαβούλη. Στη συνέχεια, εκπρόσωποι από δύο αρχές θεμελιωδών δικαιωμάτων του άρθρου 77 της AI Act, και συγκεκριμένα οι Δρ. Ευφροσύνη Σιουγλέ από την Αρχή Προστασίας Δεδομένων Προσωπικού Χαρακτήρα και ΔΝ Χρήστος Τσεβάς από την Εθνική Επιτροπή για τα Δικαιώματα του Ανθρώπου, παραχώρησαν εκπαιδευτικές ομιλίες!

Τέλος, στο Members in the Spotlight Session, το μέλος μας & DPO Executive / GDPR Expert, Δήμος Κωστούλας παραχώρησε εκπαιδευτική παρουσίαση σχετικά με την επεξεργασία προσωπικών δεδομένων στον χώρο της υγείας και τη χρήση συστημάτων Τεχνητής Νοημοσύνης σε αυτό το πεδίο!

Ευχαριστούμε θερμά τους ομιλητές, τα μέλη του δικτύου GAIN και τα μέλη της Homo Digitalis που έδωσαν το παρόν διαδικτυακά και δια ζώσης, καθώς και τους άλλους φορείς που μας τίμησαν με την παρουσία τους!

Η εκδήλωση πραγματοποιήθηκε στο πλαίσιο το προγράμματος GAIN με την υποστήριξη του European AI & Society Fund!

Λίγες θέσεις έμειναν για τη νέα εκδήλωση του GAIN! Γνώρισε από κοντά τις εποπτικές αρχές του Άρθρου 77 ΑΙ Act

Είσαι Οργάνωση της Κοινωνίας των Πολιτών (ΟΚοιΠ) και ενδιαφέρεσαι για την Προστασία των Δικαιωμάτων του Ανθρώπου στην εποχή της τεχνητής νοημοσύνης;

Έχουν μείνει λίγες δωρεάν θέσεις δια ζώσης συμμετοχής, στην εκδήλωση που διοργανώνουμε αύριο με το δίκτυο ΟΚοιΠ Greek AI Network – GAIN στο WHEN Hub!

Στην εκδήλωση, εκπρόσωποι από δύο αρχές θεμελιωδών δικαιωμάτων του άρθρου 77 της AI Act, και συγκεκριμένα οι Efrosini Siougle από την Αρχή Προστασίας Δεδομένων Προσωπικού Χαρακτήρα (Hellenic Data Protection Authority) και Christos Tsevas από την Εθνική Επιτροπή για τα Δικαιώματα του Ανθρώπου (Greek National Commission for Human Rights), θα πραγματοποιήσουν 2 ενημερωτικές παρουσιάσεις για την Τεχνητή Νοημοσύνη και θα είναι στη διάθεσή μας, για να απαντήσουν σε ερωτήσεις σχετικά με την αποστολή του φορέα τους.

Ακόμά, στο Members in the Spotlight Session, θα έχουμε τη τιμή το μέλος μας & DPO Executive / GDPR Expert, Dimos Kostoulas, να παραχωρήσει εκπαιδευτική παρουσίαση σχετικά με την επεξεργασία προσωπικών δεδομένων στον χώρο της υγείας και τη χρήση συστημάτων Τεχνητής Νοημοσύνης σε αυτό το πεδίο!

Ο σύνδεσμος για τις εγγραφές για τις περιορισμένες δωρεάν θέσεις συμμετοχής για οργανώσεις της κοινωνίας των πολιτών βρίσκεται εδω.

Η εκδήλωση πραγματοποιείται στο πλαίσιο το προγράμματος GAIN με την υποστήριξη του European AI & Society Fund!

Παρουσιάσαμε στο Privacy & Data Protection Conference τη Μελέτη μας για το πακέτο Digital Omnibus

Last Friday, Homo Digitalis was invited to the Privacy & Data Protection Conference, organized by BOUSSIAS.

There, our Executive Director, Eleftherios Chelioudakis, presented our Study on the Digital Omnibus reform packages, highlighting the challenges that the proposed changes pose to our rights in the contemporary digital era.

You can read our Study here.

We would like to warmly thank the conference organizers, and especially Alexandra Varla, for the very honorable invitation. Congratulations as well to all the speakers for their insightful contributions.

.

Η Homo Digitalis δημοσιεύει τη Μελέτη της για τους προτεινόμενους κανονισμούς Digital Omnibus

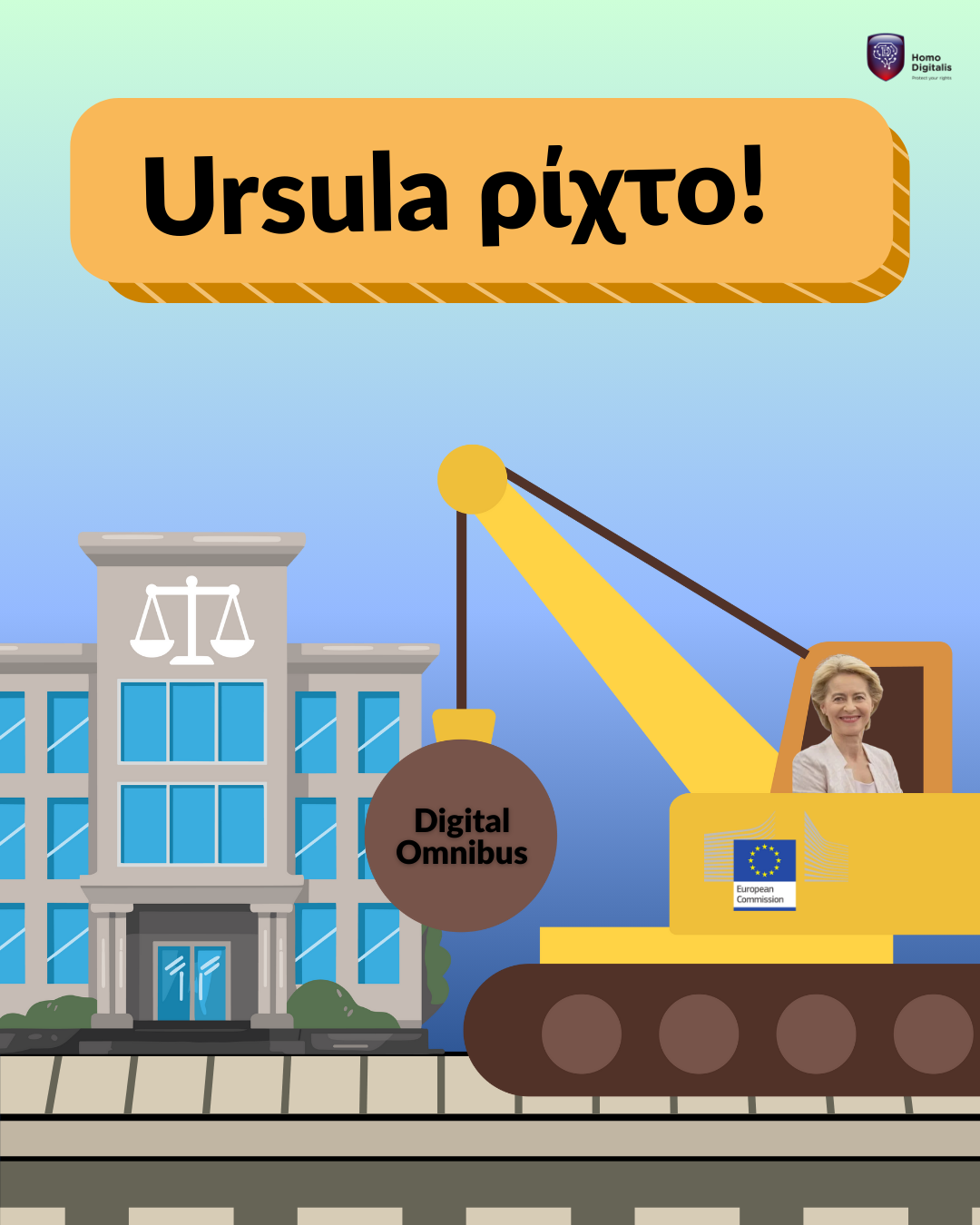

Στις 19 Νοεμβρίου, η Ευρωπαϊκή Επιτροπή δημοσίευσε δύο (2) προτεινόμενους Κανονισμούς Digital Omnibus.

Ο πρώτος (Digital Omnibus Regulation Proposal) προτείνει σημαντικές αλλαγές στις διατάξεις γνωστών νομοθετημάτων που ήδη είναι σε ισχύ, όπως ο Γενικός Κανονισμός Προστασίας Δεδομένων (ΓΚΠΔ -GDPR – Κανονισμός 2016/679), ο Κανονισμός Προστασίας Δεδομένων για τα θεσμικά και λοιπά όργανα και τους οργανισμούς της Ένωσης (EUDPR – Κανονισμός 2018/1725), η Οδηγία ePrivacy (Οδηγία 2002/58/EC), ο Κανονισμός για τα Δεδομένα (Data Act – Κανονισμός 2023/2854), ο Κανονισμός για την Ενιαία Ψηφιακή Θύρα (Κανονισμός 2018/1724), η Οδηγία NIS2 (Οδηγία 2022/2555) και η Οδηγία για την ανθεκτικότητα των κρίσιμων οντοτήτων (Οδηγία 2022/2557). Επίσης προτείνει την κατάργηση άλλων νομοθετημάτων που βρίσκονται ήδη σε ισχύ, και συγκεκριμένα του Κανονισμού για την ελεύθερη ροή δεδομένων μη προσωπικού χαρακτήρα (Κανονισμός 2018/1807), του Κανονισμού για την Διακυβέρνηση Δεδομένων (Data Governance Act – Κανονισμός 2022/868), του Κανονισμού επιγραμμικών πλατφορμών και επιχειρηματικών χρηστών (P2B – Κανονισμός 2019/1150) και της Οδηγίας για τα Ανοικτά Δεδομένα (Οδηγία 2019/1024).

Ο δεύτερος (Digital Omnibus on AI Regulation Proposal) προτείνει σημαντικές αλλαγές σε νομοθετήματα που βρίσκονται στην παρούσα φασή εν μέρει σε ισχύ και συγκεκριμένα στον Κανονισμό για την Τεχνητή Νοημοσύνη (ΑΙ Αct – Κανονισμός 2024/1689), ενώ κάνει προσθήκες και σε νομοθετήματα που είναι σε πλήρη ισχύ, και ειδικότερα στον Κανονισμό για την θέσπιση κοινών κανόνων στον τομέα της πολιτικής αεροπορίας (Κανονισμός 2018/1139).

Η Homo Digitalis, από κοινού με το ευρωπαϊκό δίκτυο στο οποίο συμμετέχει, το European Digital Rights (EDRi), καθώς και με άλλες οργανώσεις της κοινωνίας των πολιτών, ακαδημαϊκούς και ειδικούς, επιδίωξαμε καθ’ όλη τη διάρκεια του 2025 να έχουμε ουσιαστική και τεκμηριωμένη παρουσία στη σχετική νομοπαρασκευαστική διαδικασία. Στο πλαίσιο αυτό, υποβάλαμε σειρά ανοικτών επιστολών προς τα αρμόδια όργανα της Ευρωπαϊκής Επιτροπής, τον Μάιο, [1] τον Σεπτέμβριο[2] και τον Νοέμβριο,[3] ενώ παράλληλα διατυπώσαμε αναλυτικά τις θέσεις και τα επιχειρήματά μας συμμετέχοντας ενεργά στη διαδικασία δημόσιας διαβούλευσης τον Οκτώβριο του 2025.[4]

Είχαμε ήδη προειδοποιήσει ότι το πακέτο Digital Omnibus εντάσσεται σε ένα ευρύτερο κύμα απορρύθμισης, το οποίο απειλεί να αποδυναμώσει κρίσιμους ευρωπαϊκούς κανόνες, παρουσιάζοντας τα θεμελιώδη δικαιώματα ως δήθεν εμπόδιο στην καινοτομία και εξυπηρετώντας, στην πράξη, τα συμφέροντα των μεγάλων τεχνολογικών εταιρειών. Από την αρχή, δεν είχαμε καμία πεποίθηση ότι η Ευρωπαϊκή Επιτροπή θα ήταν σε θέση να αφομοιώσει ουσιαστικά και να επεξεργαστεί τις θέσεις μας στο πλαίσιο της διαδικασίας δημόσιας διαβούλευσης, επειδή αυτή η διαδικασία έληγε στα μέσα Οκτωβρίου και μόλις έναν μήνα αργότερα αναμενόταν η δημοσίευση του τελικού κειμένου με τις προτεινόμενες διατάξεις. Θα ήταν ουσιαστικά αδύνατο, να επεξεργαστεί και να εντάξει επιχειρήματα και προτάσεις στο κείμενό της σε τόσο σύντομο χρονικό διάστημα.

Τον Νοέμβριο του 2025, ήταν πλέον ξεκάθαρο ότι ότι η Ευρωπαϊκή Επιτροπή δεν ενδιαφερόταν ποτέ για ουσιαστικό διάλογο και ανταλλαγή απόψεων σχετικά με την εν λόγω νομοπαρασκευαστική πρωτοβουλία. Τότε μία διαρροή κάποιων σχεδίων των προτεινόμενων διατάξεων αποκάλυψαν πως η Επιτροπή είχε ήδη διαμορφώσει ένα σχέδιο προτεινόμενου κανονισμού με πολύ προβληματικές διατάξεις, το οποίο αποτελούσε τη μεγαλύτερη οπισθοχώρηση στην προστασία των ανθρωπίνων δικαιωμάτων στον ψηφιακό χώρο. Και τότε με κοινό Δελτίο Τύπου μας υπογραμμίσαμε τις σημαντικές προκλήσεις που ανακύπτουν από τις προτεινόμενες αλλαγές στον GDPR και την οδηγία ePrivacy, ενώ λίγες ημέρες αργότερα δημοσιεύθηκε και το επίσημο κείμενο, το οποίο έκρυβε νέες εκπλήξεις και περισσότερες προκλήσεις για τα δικαιώματα και τις ελευθερίες μας στο ψηφιακό περιβάλλον.

Σήμερα, δημοσιεύουμε την αναλυτική μελέτη μας για το πακέτο προτεινόμενων μεταρρυθμίσεων Digital Omnibus, επεξηγώντας τις προκλήσεις που ανακύπτουν για τα δικαιώματα και τις ελευθερίες μας.

Το κείμενο της μελέτης μας βρίσκεται διαθέσιμο εδώ.

Το πακέτο μεταρρυθμίσεων Digital Omnibus δεν αποτελεί μια τεχνική άσκηση κωδικοποίησης, αλλά μια αποφασιστική μετατόπιση του ευρωπαϊκού ψηφιακού κεκτημένου προς ένα καθεστώς μειωμένων εγγυήσεων και υποβαθμισμένης λογοδοσίας. Αν υιοθετηθεί ως έχει, η Ένωση κινδυνεύει να απολέσει το ισχυρότερο εργαλείο που διέθετε διεθνώς: το παράδειγμα ότι η τεχνολογική πρόοδος μπορεί να συνυπάρξει με υψηλές προδιαγραφές θεμελιωδών δικαιωμάτων.

Η αποδυνάμωση αυτή δεν θα γίνει αισθητή με θεαματικές ρήξεις, αλλά με μια αργή και επίμονη διάβρωση, κατά την οποία δικαιώματα που θεωρούσαμε αδιαπραγμάτευτα θα μετατρέπονται σε εξαιρέσεις, ενώ η επόπτευση θα καθίσταται σκιά του εαυτού της. Η επιλογή που καλούνται να κάνουν οι ενωσιακοί νομοθέτες δεν αφορά την «απλοποίηση» της νομοθεσίας, αλλά το ίδιο το μέλλον του ευρωπαϊκού μοντέλου προστασίας του ανθρώπου: εάν θα παραμείνει πυλώνας του κράτους δικαίου ή αν θα επιτρέψει να υποκατασταθεί από μια λογική όπου η καινοτομία επιβάλλεται χωρίς αντίβαρα, και η ιδιωτικότητα καθίσταται διαπραγματεύσιμη

[1] European Digital Rights, The EU must uphold hard-won protections for digital human rights, 2025, Διαθέσιμο εδώ.

[1] European Digital Rights et al, Reopening the GDPR is a threat to rights, accountability, and the future of EU digital policy, 2025, Διαθέσιμο εδώ.

[2] European Digital Rights et al, Open Letter: The EU weakens the rules that safeguard people and the environment, 2025, Διαθέσιμο εδώ.

[3] European Digital Rights et al, Forthcoming Digital Omnibus would mark point of no return, 2025, Διαθέσιμο εδώ.

[4] Homo Digitalis, Simplification – Digital Package and omnibus, 2025, Διαθέσιμο εδώ και European Digital Rights, Consultation response to the European Commission’s call for evidence on the Digital Omnibus, 2025, Διαθέσιμο εδώ.

Με επιτυχία ολοκληρώθηκε το workshop μας για το NGI TALER στο Journals n’ Spirits 2025

Στις 13/11 εκπροσωπήσαμε το NGI TALER στο Journals n’ Spirits 2025, το οποίο διοργανώθηκε από το omniatv από κοινού με τα εγχειρήματα Βλάβη (περιοδικό), Copwatch GR, FactReview, Femicide.gr, Homo Digitalis, INFOWAR, inside story., Jacobin Greece, KΡαΧ Radio, The Manifold, Reporters United, Solomon, The Untold, Vouliwatch, YUSRA (περιοδικό/εκδόσεις) στη Δημοτική Αγορά Κυψέλης!

Συγκεκριμένα, ο Λευτέρης Χελιουδάκης από την ομάδα μας παρουσίασε το εργαλείο ψηφιακών πληρωμών GNU TALER, το οποίο λειτουργεί σαν ψηφιακά μετρητά και αλλάζει ριζικά το οικοσύστημα των ηλεκτρονικών μικροπληρωμών. Βασίζεται στις αρχές του ελεύθερου λογισμικού και στον απόλυτο σεβασμό της ιδιωτικότητας, προσφέροντας έναν νέο τρόπο για οικονομικές συναλλαγές στο διαδίκτυο, επιτρέποντας ταυτόχρονα απόλυτη λογοδοσία.

Επίσης, μιλήσαμε για τις χρηματοδοτήσεις που παρέχει το NGI TALER σε όλους όσους μπορούν να βοηθήσουν με την σημαντική αποστολή μας! Έχεις σχετικές ιδέες; Κάνε την αίτησή σου έως την 1η Φεβρουαρίου 2026 εδώ.

Η Homo Digitalis & η ΕDRi μιλούν στο inside story για τους προτεινόμενους κανονισμούς Digital Omnibus

Απομακρύνεται η Ευρώπη από την προστασία των ψηφιακών μας δικαιωμάτων;

Το inside story. και η δημοσιογράφος Ελίζα Τριανταφύλλου δημοσίευσαν την Δευτέρα 1/12 ένα αναλυτικό άρθρο για τις προτάσεις Digital Omnibus της Ευρωπαϊκής Επιτροπής! Η European Digital Rights και η Homo Digitalis είχαν την τιμή να παραχωρήσουν σχετικά σχόλια και επιχειρήματα με εκπροσώπηση από τα μέλη τους: Blue Duangdjai Tiyavorabun, Ella Jakubowska (she/her), Itxaso Domínguez de Olazábal, PhD. και Λευτέρης Χελιουδάκης.

Yποκύπτει η ΕΕ στις πιέσεις του Τραμπ και των μεγάλων τεχνολογικών εταιρειών για απορρύθμιση των κανόνων προστασίας των προσωπικών δεδομένων και της ιδιωτικότητας των Ευρωπαίων πολιτών, βαφτίζοντάς το «απλοποίηση»; Tι ακριβώς περιλαμβάνουν οι δύο πρόσφατες προτάσεις της; Διάβασε το άρθρο εδώ.

Ευχαριστούμε θερμά τη δημοσιογράφο για τον ενδιαφέρον της στα επιχειρήματά μας.