Παραχωρούμε αιγίδα και ομιλία στο 15o InfoCom Security 2025!

Με χαρά ανακοινώνουμε ότι η Homo Digitalis παραχωρεί για ακόμη μια χρόνια την αιγίδα της στο 15o InfoCom Security 2025!! Η επετειακή εκδοχή του θα λάβει χώρα στις 2 & 3 Απριλίου στο Ωδείο Αθηνών!

O Κωνσταντίνος Κακαβούλης θα εκπροσωπήσει το ΔΣ μας εκεί, παραχωρώντας και την εναρκτήρια τοποθέτηση του συνεδρίου κατά τη δεύτερη ημέρα διεξαγωγής του!

Οι εγγραφές είναι ανοιχτές και δωρεάν!! Μπορείτε να κάνετε τη δίκη σας, καθώς και να δείτε το πλήρες πρόγραμμα για τις 2 ημέρες του συνεδρίου εδώ.

Ευχαριστούμε θερμά την ομάδα των διοργανωτών για την εξαιρετική συνεργασία (SmartPress S.A., IT Security Pro ) στο πλαίσιο της εκδήλωσης.

Οι εγγραφές του 2ου AI Summit της Cleon Conferences υπό την αιγίδα της Homo Digitalis άνοιξαν

Η CLEON Conferences & Communications διοργανώνει, το 2nd AI SUMMIT, υπό την αιγίδα των: Υπουργείο Ψηφιακής Διακυβέρνησης, ΣΕΚΕΕ, ISACA, Homo Digitalis και Rythmisis, To συνέδριο θα συντονίσει ο δικηγόρος και δημοσιογράφος, Αντώνης Παπαγιαννίδης, ενώ ομιλία θα παραχωρήσει και ο συνιδρυτής της Homo Digitalis και δικηγόρος Στέφανος Βιτωράτος.

Το συνέδριο θα πραγματοποιηθεί την Τρίτη, 29 Απριλίου στο Divani Caravel Hotel στην Αθήνα.

Μην χάσετε την ευκαιρία να ενημερωθείτε για τις τελευταίες εξελίξεις και τις τάσεις στο ΑΙ!

Μπορείτε να κάνετε την εγγραφή σας εδώ.

Εκδήλωση της Homo Digitalis για την AI Act και τις οργανώσεις της κοινωνίας των πολιτών

Την Πέμπτη 27 Φεβρουαρίου, η Homo Digitalis διοργάνωσε στα γραφεία της στο ViOS Coworking – Greece την πρώτη ημερίδα για την AI Act για οργανώσεις της Κοινωνίας των Πολιτών!

Περισσότεροι από 20 φορείς έδωσαν το παρόν, προερχόμενοι από ένα ευρύ και ποικιλόμορφο φάσμα υπόβαθρων, με κοινό ενδιαφέρον τη συνεργασία για τις προκλήσεις και τις ευκαιρίες που απορρέουν από την AI Act.

Στην εκδήλωση παρουσιάσαμε τις 3 Θεματικές Μελέτες που έχουμε εκδώσει για την ΑΙ Act για FRIAs, τις Αρχές Εποπτείας και το Οικοσύστημα Διακυβέρνησης ΤΝ & τις Απαγορευμένες Πρακτικές, ενώ διοργανώσαμε θεματικούς κύκλους συζητήσεων σε 4 τομείς, “Περιβάλλον και Τεχνητή Νοημοσύνη”, “Επιχειρηματικές Πρακτικές & Αλγοριθμική Διαφάνεια”, “Τεχνητή Νοημοσύνη στην Αστυνόμευση και τη Μετανάστευση” και “Συστήματα ΤΝ, Δημοκρατία και Κοινωνία της Πληροφορίας”.

Θα θέλαμε να ευχαριστήσουμε θερμά όλες τις οργανώσεις που κατάφεραν να δώσουν το παρόν, για την ενέργεια, την εμπιστοσύνη και το πολύ θετικό κλίμα συνεργασίας! Επίσης ένα μεγάλο ευχαριστώ στην ομάδα της Homo Digitalis που διοργάνωσε την εκδήλωση και παρουσίασε τις μελέτες μας, Σοφία Αντωνοπούλου, Νίκη Γεωργακοπούλου, Λαμπρινή Γυφτοκώστα, Τάνια Σκραπαλιώρη, Λευτέρη Χελιουδάκη και Σταυρούλα Χούσου.

Η εκδήλωση πραγματοποιήθηκε με κεφάλαια από χρηματοδοτήσεις των European AI & Society Fund και European Digital Rights! Είμαστε πολύ υπερήφανοι για την υποστήριξή τους!

Θέλετε να αποτελέσετε μέρος αυτής της προσπάθειας συνεργασίας; Συμπληρώστε τη φόρμα επικοινωνίας στην ιστοσελίδα μας.

ActionAid Hellas, KEAN- Cell of Altrenative Youth Activities, Greenpeace Greece, WWF Greece, inside story., Reporters United, Solomon, Eteron Institute, KnowledgeRights21, EKPIZO, Greek Council for Refugees, Open Lab Athens , Vouliwatch, Amnesty International – Greece, Transparency International Greece, I Have Rights., HIAS Greece, Οργανισμός Ανοιχτών Τεχνολογιών, CopWatchGR, Hellenic League for Human Rights, omniatv, Diversity Charter Greece, Generation 2.0 for Rights, Equality and Diversity.

Συνδιοργανώνουμε εκδήλωση για τη Κυβερνοασφάλεια και την προστασία προσωπικών δεδομένων στο Πάρκο Καινοτομίας JOIST στη Λάρισα!

Στις 20 Μαρτίου 2025 και ώρα 18:00 – 20:30 η Homo Digitalis έχει τη μεγάλη χαρά να συνδιοργανώνει και να συμμετέχει στην εκδήλωση “Κυβερνοασφάλεια και προστασία προσωπικών δεδομένων: Ανθεκτικότητα, Συμμόρφωση, Καινοτομία” στο Πάρκο Καινοτομίας JOIST στη Λάρισα!

Στόχος της εκδήλωσης είναι η ευαισθητοποίηση και ενδυνάμωση των επιχειρήσεων όλων των κλάδων και μεγεθών ώστε να μπορούν να γίνουν ανθεκτικές και να καινοτομούν με ασφάλεια και σεβασμό στα δικαιώματα των πολιτών.

Στην εκδήλωση θα συμμετέχουν ως ομιλητές/ομιλήτριες :

ο Διοικητής της Εθνικής Αρχής Κυβερνοασφάλειας Μιχαήλ Μπλέτσας.

ο Παναγιώτης Σούλος Μέλος του ISC2 Hellenic Chapter, Information Security GRC Senior Manager στην STEELMET Corporate Services,

η Λαμπρινή Γυφτοκώστα, Διευθύντρια Δικαιωμάτων του Ανθρώπου & Τεχνητής Νοημοσύνης της Homo Digitalis,

o Γιάννης Κούκουρας Μέλος του ISC2 Hellenic Chapter, Managing Director στην TwelveSec TwelveSec, και

η Karina Iskandarova, Ιδρύτια της CharismaWorks

⌛ Συντονίζει ο Αναστάσιος Αραμπατζής από Bora – Cybersecurity Marketing και Homo Digitalis.

Δηλώστε συμμετοχή δωρεάν εδώ.

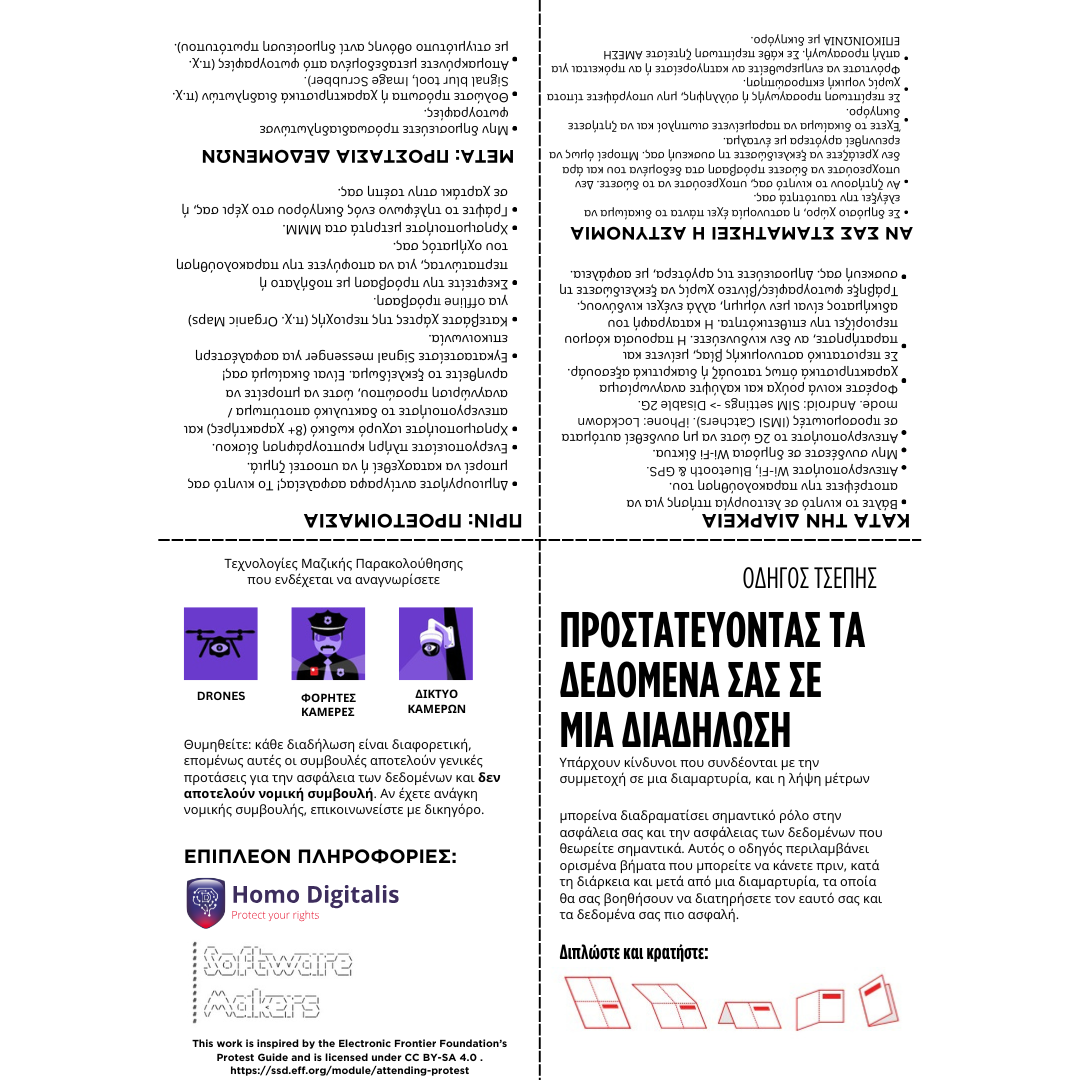

Διάβασε τον Οδηγό Τσέπης για προστασία της ιδιωτικότητάς σου σε πορείες

Δύο χρόνια συμπληρώνονται σήμερα, Παρασκευή 28 Φεβρουαρίου, από την τραγωδία των Τεμπών, με απεργίες και στάσεις εργασίας να έχουν προγραμματιστεί σε όλη την χώρα και στο εξωτερικό τόσο για να τιμηθεί η μνήμη των 57 θυμάτων του σιδηροδρομικού δυστυχήματος όσο και για να αποδοθεί δικαιοσύνη και να τιμωρηθούν οι υπεύθυνοι.

Τι συμβαίνει όμως με τις συσκευές σου και τα προσωπικά δεδομένα σου και πως μπορείς να πάρεις μέτρα για να διασφαλίσεις την προστασία τους σε μία πορεία διαμαρτυρίας;

Η Homo Digitalis από κοινού με τη Software Makers, ΑΜΚΕ με έδρα το Ηράκλειο της Κρήτης, μετέφρασαν και προσάρμοσαν το σύντομο οδηγό τσέπης του Electronic Frontier Foundation (EFF) στα ελληνικά δεδομένα παρέχοντας ορισμένα βήματα που μπορείτε να κάνετε πριν, κατά τη διάρκεια και μετά από μια διαμαρτυρία, τα οποία θα σας βοηθήσουν να διατηρήσετε τον εαυτό σας και τα δεδομένα σας πιο ασφαλή.

Δείχνουμε την αλληλεγγύη μας και τη αμέριστη συμπαράστασή μας!

Το κείμενο του οδηγού βρίσκεται διαθέσιμο προς εκτύπωση εδώ.

H Homo Digitalis συμμετέχει στη διαδικτυακή εκδήλωση ενημέρωσης του Project Parenting

Είναι κακές οι οθόνες ή δεν τις χρησιμοποιούμε σωστά;

Η Homo Digitalis έχει τη μεγάλη τιμή να συμμετέχει για ακόμη μια χρονιά στην ψηφιακή ημερίδα που διοργανώνει το Project Parenting για γονείς που λαμβάνει χώρα σήμερα, Τετάρτη 26 Φεβρουαρίου από τις 17:30 έως τις 22:30!!

Στις 21:40 η Λαμπρινή Γυφτοκώστα θα εκπροσωπήσει την ομάδα μας μιλώντας για τη θεματική “Cookies και Γονικός Έλεγχος: Φίλτραρε τι πληροφορίες δίνεις εσύ και το παιδί σου για να μην πέσουν σε χέρια που δε θες”!

Οι εγγραφές είναι δωρεάν και μπορείτε να δηλώσετε ακόμη συμμετοχή για να παρακολουθήσετε μια σειρά από πολύ ενδιαφέρουσες τοποθετήσεις από ειδικούς σε μια σειρά από σημαντικά ζητήματα εδώ.

Πώς να διασφαλίσεις τον ψηφιακό σου εαυτό σε δημόσιους και κοινόχρηστους χώρους

Γράφει o Γιάννης Ντόκος*

Έχεις ποτέ αναρωτηθεί: “Πού σταματάει ο “φυσικός” μου εαυτός, και πού ξεκινάει ο ψηφιακός;”; Μην εκπλήσσεσαι, αν δυσκολεύεσαι να απαντήσεις. Με καθημερινά τεχνολογικά άλματα να φέρνουν παντού κινητά τηλέφωνα, έξυπνα ρολόγια και φριτέζες με wifi, τα όρια μεταξύ του ψηφιακού και απτού μας κόσμου ολοένα θολώνουν. Και, σαν να μην έφτανε η παραπάνω σύγχυση, προσβολές στον φυσικό κόσμο επιφέρουν μεταβολές στον ψηφιακό, και τούμπαλιν. Πόσω δε μάλλον, όταν βρισκόμαστε σε χώρους και περιβάλλοντα που χρησιμοποιούνται από περισσότερα, καλόβουλα αλλά και κακόβουλα, άτομα. Πώς όμως μπορούμε να φροντίσουμε, ούτως ώστε η παρουσία μας σε φυσικά και ψηφιακά δημόσιους χώρους να γίνεται με τρόπο ασφαλή; Παρακάτω θα σου δείξω πόσο εύκολα μπορούν να πληγούν τα ψηφιακά σου όρια στον φυσικό κόσμο, και πώς να μείνεις ασφαλής σε αυτόν.

Το δωρεάν wifi έχει ένα κόστος

Παραδέξου το, το έχεις κάνει ουκ ολίγες φορές - είσαι έξω, και δε θες να χαλάσεις δεδομένα για να συνδεθείς στο ίντερνετ. Ευτυχώς, είσαι σε καφετέρια με ανοιχτό ή δημόσια διαθέσιμο wifi! Είναι η τυχερή σου μέρα, αλλά μπορεί να μετατραπεί στην χειρότερή σου μέρα εξίσου εύκολα. Γιατί ομώς; Όπως εσύ έχεις δωρεάν πρόσβαση στο δίκτυο της καφετέριας προκειμένου να χαζέψεις στο ίντερνετ, την ίδια πρόσβαση θα μπορούσε να έχει κάποιος ο οποίος ενδιαφέρεται για τα δεδομένα σου. Το ΑΦΜ σου, τους κωδικούς στους λογαριασμούς σου (τραπεζικούς και μη), τις επικοινωνίες σου. Και με την πρόσβαση που έχουν στο κοινόχρηστο δίκτυο, οι τρόποι να σε βλάψουν είναι ατέλειωτοι - ανακατεύθυνση των στοιχείων σου, κλοπή ταυτότητας, ψεύτικα σάιτ της τράπεζας της επιλογής σου. Μετά θα τρέχεις, και δεν θα αξίζει τα λίγα mb που σώζεις με το δωρεάν ίντερνετ.

Τι να κάνω;

Όσο απλά μπορείς να πάθεις κακό, τόσο απλό είναι να προστατευτείς από αυτό. Ενδεικτικά, πράξε ώς εξής:

● Μη χρησιμοποιείς το δημόσια διαθέσιμο δίκτυο: Είναι ελκυστικό, αλλά αν μπορείς και δεν επείγει, μη το χρησιμοποιήσεις. Χρησιμοποίησε τον πάροχο της επιλογής σου για να συνδεθείς μέσω κινητής τηλεφωνίας, ή περίμενε να γυρίσεις σπίτι και να μπεις μέσω του δικού σου (ελπίζω ασφαλούς) wifi.

● Αν πρέπει οπωσδήποτε να συνδεθείς στο δημόσιο δίκτυο, συνδέσου μέσω VPN: Με αυτό τον τρόπο, τα δεδομένα σου ταξιδεύουν μέσα σε ένα κρυπτογραφημένο τούνελ που δύσκολα προσβάλλεται από κακόβουλα άτομα.

● Πρόσεχε σε ποιές υπηρεσίες συνδέεσαι και τί δεδομένα μοιράζεσαι: Αν θες να ολοκληρώσεις τραπεζικές συναλλαγές διαδικτυακά, καλύτερα να μην το κάνεις από το wifi της καφετέριας ή του αεροδρομίου.

Μήπως σε παρακολουθούν;

Χρησιμοποιώ τη δημόσια συγκοινωνία συχνά. Όταν δεν έχω κάτι να κάνω, μου αρέσει να παρακολουθώ τους γύρω μου (όχι δόλια, το ορκίζομαι!). Μου έχει τύχει ουκ ολίγες φορές να παρατηρήσω κάποιον επιβάτη, ο οποίος όντας απορροφημένος στο κινητό ή τον υπολογιστή του, προσελκύει πολλά βλέμματα στην οθόνη του. Τα βλέμματα κάποιες φορές δεν αποστρέφονται, είναι επίμονα, και ενίοτε οδηγούν σε μηχανορραφίες, σκέψεις και σημειώσεις από τον δράστη. Με τον ίδιο τρόπο, μπορεί και από σένα να αποσπάσουν το pin της συσκευής ή τον κωδικό της εφαρμογής της τράπεζάς σου, ή ίσως το pin της κάρτας σου όταν κάνεις ανάληψη, και να τα απομνημονεύσουν ή να τα σημειώσουν κάπου. Την πάτησες…

Το φαινόμενο shoulder surfing (ελληνιστί “οπτική υποκλοπή”) δεν είναι κάτι καινούργιο, αλλά είναι εξαιρετικά αποτελεσματικό, διότι εκμεταλλεύεται την αφηρημάδα ή την αφέλειά μας. Και, κακά τα ψέματα, σε μία χώρα όπου το κοινωνικό ενδιαφέρον (ήτοι κουτσομπολιό) “πάει σύννεφο”, και να κοιτάζει ο άλλος, δε δίνουμε σημασία.

Τι να κάνω;

Αν βρίσκεσαι σε δημόσιο χώρο περιτριγυρισμένος από περίεργα βλέμματα, οι παρακάτω ενέργειες μπορεί να βοηθήσουν:

● Γίνε λίγο καχύποπτος/η:Μην εμπιστεύεσαι άτομα γύρω σου τα οποία δεν ξέρεις (καλά). Σε δημόσια σημεία, καθένας μπορεί να έχει αγαθά ή μοχθηρά κίνητρα. Κάλυψε το pin σου στην τράπεζα, ή εγκατάστησε μια οθόνη προστασίας ιδιωτικότητας στο κινητό ή τον υπολογιστή σου (είναι καλή επένδυση!). Όπως λένε στο χωριό μου, zero trust!

● Κοίτα τους κι εσύ: Τώρα παίζεις με την ψυχολογία τους. Αν κάποιος φαίνεται να σε κοιτάει ύποπτα με σκοπό να σου αποσπάσει δεδομένα και στοιχεία, ανταπόδωσε το βλέμμα. Όχι με μανία (μη βρεις το μπελά σου), αλλά με τρόπο που να δείχνει ό,τι έχεις επίγνωση της κατάστασης. Συνήθως αυτό αρκεί να τους κάνει να σταματήσουν.

● Play it safe: Όπως και στη παραπάνω περίπτωση, αν θεωρείς οτι τραβάς τα βλέμματα πάνω σου (με σκοπό να σου υποκλέψουν τα στοιχεία, προφανώς!), καλύτερα να αποφύγεις να ανοίξεις εκείνο το αρχείο που αναγράφει το ΑΦΜ, την ημερομηνία γέννησής σου και τον αριθμό τηλεφώνου σου.

Τα πράγματά σου και τα μάτια σου!

Φαντάσου το εξής σενάριο: βρίσκεσαι στο σινεμά και θες επειγόντως να χρησιμοποιήσεις την τουαλέτα. Αφήνεις το κινητό σου πάνω στο κάθισμα. Τί μπορεί να πάει στραβά; Πολλά μπορούν να συμβούν.. Κάποιος κακόβουλος μπορεί να έχει βάλει στο μάτι το τηλέφωνό σου, και με την πρώτη ευκαιρία να το αρπάξει. Ίσως δουλεύεις remote από μια καφετέρια και θες να κάνεις ένα διάλειμμα. Θα άφηνες τον υπολογιστή σου ξεκλείδωτο πάνω στο τραπέζι; Ελπίζω πως όχι.

Οι προσωπικές μας συσκευές είναι σαν την κεντρική πόρτα του σπιτιού μας - αν είναι ανοιχτές ή ξεκλείδωτες, προσκαλούν πιθανούς εγκληματίες να εισβάλλουν και να υφαρπάξουν χρήσιμα για αυτούς στοιχεία. Μη τους δώσεις αυτή τη δυνατότητα.

Τι να κάνω;

Αν βρίσκεσαι σε δημόσιο χώρο, όπου η συσκευή σου κινδυνεύει να κλαπεί ή να διαρραγεί, κάνε τα ακόλουθα:

● Πάρε τη συσκευή μαζί σου: Μην αφήνεις ανεπίβλεπτες τις συσκευές σου, εάν υπάρχει ο παραμικρός κίνδυνος απώλειας ή κλοπής. Και προφανώς, μην την αφήνεις σε ανοιχτή θέα, ούτε καν μέσα στο κλειδωμένο σου αυτοκίνητο. Δες ένα παράδειγμα εδώ

● Κλείδωσέ την: Πάντα κλείδωνε τη συσκευή σου όταν δε βρίσκεσαι κάπου κοντά. Αυτό δε θα σε σώσει από την απώλεια δεδομένων, αλλά τουλάχιστον θα κερδίσεις λίγο χρόνο.

● Ενεργοποίησε τη δυνατότητα απομακρυσμένης διαγραφή: Ως ύστατο μέτρο, εάν είναι τεχνικά εφικτό, ενεργοποίησε τη δυνατότητα να διαγράψεις τα περιεχόμενα της συσκευής σου εξ αποστάσεως.

*Ο Γιάννης Ντόκος είναι IT GRC Expert.

Δώσαμε την πιο ενδιαφέρουσα συνέντευξη στους μαθητές του Δημοτικού Νίκαιας στην Λάρισα για την Ημέρα Προστασίας Προσωπικών Δεδομένων

Ένας από τους πιο ευχάριστους, υπέροχους τρόπους που γιορτάσαμε την Παγκόσμια Ημέρα Προστασίας Προσωπικών Δεδομένων, ήταν η διαδικτυακή συνέντευξη που παραχώρησε η Λαμπρινή Γυφτοκώστα από την ομάδα μας στην Πέμπτη τάξη του Δημοτικού της Νίκαιας στην Λάρισα στις 28 Ιανουαρίου! Οι ερωτήσεις ήταν ΠΟΛΛΕΣ!!!…από το τι σημαίνει προσωπικό δεδομένο, τι γιορτάζουμε σήμερα μέχρι το αν έχει μυαλό η τεχνητή νοημοσύνη, αν τα ξέρει όλα ή αν κάνει λάθη.

Η συνέντευξη έγινε στα πλαίσια ενός σχολικού διαγωνισμού στον οποίο οι μικροί δημοσιογράφοι συμμετέχουν. Περιμένουμε εναγωνίως το άρθρο που θα εκδώσουν και τους ευχόμαστε καλή επιτυχία!!!

Ευχαριστούμε θερμά την εκπαιδευτικό Βίλη Καραγιώργου και το Δημοτικό της Νίκαιας στη Λάρισα για την άψογησυνεργασία στο πλαίσιο της δράσης αυτής.

Nέες εθελοντικές δράσεις Ευαισθητοποίησης - 11 Ενιαίο Λύκειο Λάρισας

Την περασμένη εβδομάδα, δώσαμε το παρόν σε ακόμη μία εθελοντικού χαρακτήρα δράση ευαισθητοποίησης, αυτή τη φορά στο 11 Ενιαίο Λύκειο Λάρισας!

Εκεί, το μέλος μας και ειδικός σε ζητήματα κυβερνοασφάλειας, Τάσος Αραμπατζής μίλησε σε περισσότερους από 80 μαθητές και καθηγητές από όλες τις τάξεις του Λυκείου για τα δικαιώματα που έχουμε στον ψηφιακό χώρο, στο πλαίσιο της εκπαιδευτικής μας παρουσίασης “Ψηφιακό Αποτύπωμα”.

Θα θέλαμε να ευχαριστούμε θερμά τη Διευθύντρια του Σχολείου, κα. Ευαγγελία Κρεμεζη για την ευγενική πρόσκληση και την εξαιρετική συνεργασία. Επίσης, ευχαριστούμε και την εταιρία του Τάσου Bora – Cybersecurity Marketing, που πάντα δίνει την ευελιξία στον Τάσο να μας εκπροσωπεί μπροστά σε σχολεία και άλλους φορείς εθελοντικά σε εργάσιμες ώρες.

Εάν σας ενδιαφέρει να μάθετε περισσότερα για τις αφιλοκερδείς δράσεις ευαισθητοποίησης μας στα σχολεία, αποκλειστικά με ίδιους πόρους, ή ενδιαφέρεστε για σχετικές δράσεις στο σχολείο σας για τη νέα σχολική χρονιά, μπορείτε να μας στείλετε τα μηνύματά σας στο info@homodigitalis.gr