H Ηοmo Digitalis συνεργάζεται για ακόμη μία χρονιά με το Digital World Summit Greece

Με μεγάλη μας χαρά ανακοινώνουμε ότι για ακόμη μία χρονιά το Digital World Summit Greece (DWS Greece) και η Ηοmo Digitalis προχωρούν σε στρατηγική συνεργασία!

Το Digital World Summit Greece (DWS Greece) έχει ως στόχο τη δημοκρατική διακυβέρνηση των νέων τεχνολογιών. Ως πλατφόρμα διαλόγου συγκεντρώνει διαφορετικούς φορείς και ομάδες, διαμορφώνοντας από τη βάση προς την κορυφή πολιτικές που αφορούν την τεχνητή νοημοσύνη, τις πλατφόρμες, το Διαδίκτυο των Πραγμάτων, και ευρύτερα ό,τι σχετίζεται με τον τομέα της τεχνολογίας.

Η Homo Digitalis στηρίζει έμπρακτα το DWS Greece από τα πρώτα του βήματα και είναι μεγάλη μας τιμή να συνεχίζουμε να το κάνουμε δυναμικά, προκειμένου μαζί να βοηθήσουμε στην ωρίμανση του δημόσιου διαλόγου στην Ελλάδα σχετικά με ζητήματα που άπτονται ψηφιακών δικαιωμάτων.

Μπορείτε να μάθετε περισσότερα για τις δράσεις του Digital World Summit Greece στην ιστοσελίδα τους, εδώ.

Δημοσιεύουμε την Τρίτη Μελέτη μας για την AI Act εστιάζοντας στο Άρθρο 5 & τις Απαγορευμένες Πρακτικές

Σήμερα η Homo Digitalis δημοσιεύει την τρίτη μελέτη της για τον Κανονισμό 2024/1689, τη πασίγνωστη πλέον AI Act με τίτλο «Πράξη για την Τεχνητή Νοημοσύνη: Ανάλυση διατάξεων για τις απαγορευμένες πρακτικές του άρθρου 5 του Κανονισμού 2024/1689».

Η συγγραφική ομάδα της μελέτης αποτελείται από τη Σοφία Αντωνοπούλου, τη Λαμπρινή Γυφκτοκώστα, την Τάνια Σκραπαλιώρη, τον Λευτέρη Χελιουδάκη και τη Σταυρούλα Χούσου.

Σκοπός της παρούσας ανάλυσης της Homo Digitalis είναι η συστηματική προσέγγιση κάθε διάταξης του άρθρου 5 του Κανονισμού για την ΤΝ, που σχετίζονται με τις Χειριστικές ή παραπλανητικές τεχνικές, την Εκμετάλλευση τρωτών στοιχείων, την Αξιολόγηση κοινωνικής συμπεριφοράς, τις Βάσεις δεδομένων αναγνώρισης προσώπου, την Πρόβλεψη τέλεσης αξιόποινης πράξης, τη Συναγωγή συναισθημάτων, τα Συστήματα βιομετρικής κατηγοριοποίησης και την Εξ αποστάσεως βιομετρική ταυτοποίηση.

Με τη μελέτη μας παρέχουμε στοχευμένα ερωτήματα που αναδεικνύουν τις κρίσιμες πτυχές των επί μέρους διατάξεων, εντοπίζοντας τις λεγόμενες “γκρι ζώνες” – εκείνων των σημείων δηλαδή που παρουσιάζουν ασάφειες, επικαλύψεις ή δυνητικές ερμηνευτικές δυσκολίες, ενώ τεκμηριώνουμε τους προβληματισμούς μας μέσω συγκεκριμένων παραδειγμάτων. Τέλος, διατυπώνουμε συγκεκριμένα ερωτήματα προς επεξήγηση από τις επικείμενες κατευθυντήριες γραμμές της Υπηρεσίας για την ΤΝ της Ευρωπαϊκής Επιτροπής (ΑΙ Office) αλλά και τον εθνικό νομοθέτη, με στόχο την πληρέστερη αποσαφήνιση των υφιστάμενων ζητημάτων.

Όπως οι δύο πρώτες μας μελέτες (οι οποίες δημοσιεύθηκαν τον Οκτώβριο και τον Νοέμβριο του 2024, αντίστοιχα) και η τρίτη μας Μελέτη έχει ως σκοπό να σταθεί αρωγός στο Υπουργείο Ψηφιακής Διακυβέρνησης που έχει ως αποστολή να μεταφέρει την AI Act στην Ελλάδα, αλλά και με τις λεπτομερείς αναλύσεις και τα επιχειρήματά μας να βοηθήσουμε στην ωρίμανση του δημόσιου διαλόγου και να δώσουμε τη δυνατότητα σε περισσότερες οργανώσεις της Κοινωνίας των Πολιτών να συμμετέχουν ενεργά σε αυτόν.

Μπορείτε να διαβάσετε τη Μελέτη μας «Πράξη για την Τεχνητή Νοημοσύνη: Ανάλυση διατάξεων για τις απαγορευμένες πρακτικές του άρθρου 5 του Κανονισμού 2024/1689» εδώ.

Η Homo Digitalis συμμετείχε στη διαβούλευση του Γραφείου Τεχνητής Νοημοσύνης για τις Απαγορευμένες Πρακτικές στο πλαίσιο της AI Act.

Τον Νοέμβριο του 2024, το Γραφείο Τεχνητής Νοημοσύνης της Ευρωπαϊκής Επιτροπής ξεκίνησε διαβούλευση σχετικά με τις απαγορευμένες πρακτικές συστημάτων ΤΝ και τον ορισμό των συστημάτων Τεχνητής Νοημοσύνης που προβλέπουν οι διατάξεις του Κανονισμού για την Τεχνητή Νοημοσύνη.

Οι κατευθυντήριες γραμμές που βρίσκονται υπό επεξεργασία θα βοηθήσουν τις εθνικές αρμόδιες αρχές, καθώς και τους παρόχους, να συμμορφωθούν με τους κανόνες του Κανονισμού για την Τεχνητή Νοημοσύνη όσον αφορά αυτές τις πρακτικές, πριν από την εφαρμογή των σχετικών διατάξεων στις 2 Φεβρουαρίου 2025.

Η Homo Digitalis συμμετείχε σε αυτή τη δημόσια διαβούλευση υποβάλλοντας τις προτάσεις μας, με στόχο να αναδείξουμε προκλήσεις και να παρέχουμε περαιτέρω σαφήνεια σχετικά με πρακτικά ζητήματα και επιμέρους περιπτώσεις χρήσης.

Η ομάδα συγγραφής της δημόσιας διαβούλευσης αποτελείται από τη Διευθύντρια Ανθρωπίνων Δικαιωμάτων και Τεχνητής Νοημοσύνης μας, Λαμπρινή Γυφτοκώστα, και τα μέλη μας Σοφία Αντωνοπούλου και Σταυρίνα Χούσου.

Μπορείτε να διαβάσετε την παρέμβασή μας εδώ.

Μείνετε συντονισμένοι, καθώς σύντομα θα δημοσιεύσουμε την ειδική μας αναφορά σχετικά με τον Κανονισμό για την Τεχνητή Νοημοσύνη και τις διατάξεις του για τις Απαγορευμένες Πρακτικές!

Δημοσιεύουμε τη Δεύτερη Μελέτη μας για το AI Act για τις αρμόδιες αρχές εποπτείας και το οικοσύστημα διακυβέρνησης της ΤΝ

Σήμερα η Homo Digitalis δημοσιεύει τη δεύτερη μελέτη της για τον Κανονισμό 2024/1689, τη πασίγνωστη πλέον AI Act με τίτλο «Πράξη για την Τεχνητή Νοημοσύνη: Ανάλυση Διατάξεων για τη Διακυβέρνηση της ΤΝ και τις Αρμόδιες Αρχές Εποπτείας».

Η συγγραφική ομάδα της μελέτης αποτελείται από τη Διευθύντρια Δικαιωμάτων του Ανθρώπου και Τεχνητής Νοημοσύνης της Homo Digitalis, Λαμπρινή Γυφτοκώστα, και το μέλος μας Νίκη Γεωργακοπούλου.

Σκοπός της παρούσας ανάλυσης της Homo Digitalis είναι η ανάδειξη ορισμένων κρίσιμων ζητημάτων που εγείρει η εφαρμογή των διατάξεων περί συστήματος διακυβέρνησης της ΤΝ, λαμβάνοντας υπόψη τις εθνικές δομές αλλά και την οπτική της κοινωνίας των πολιτών.

Πιο συγκεκριμένα στην ανάλυση αυτή απαντάμε στα εξής ερωτήματα:

- Ποια δομή διακυβέρνησης προτείνει ο Κανονισμός για την ΤΝ;

- Τι σημαίνει για τον Κανονισμό για την ΤΝ η έννοια “αρχή εποπτείας της αγοράς”;

- Τι ισχύει στον Κανονισμό 2019/1020 και γιατί πρέπει να εξετάσουμε τις διατάξεις του μαζί με την AI Act;

- Ποιες ελληνικές αρχές πληρούν τις προϋποθέσεις που θέτουν οι δύο Κανονισμοί και γιατί;

- Ποια μοντέλα διακυβέρνησης έχουν υιοθετηθεί ή είναι υπό συζήτηση σε άλλες χώρες στην παρούσα χρονική στιγμή;

- Ποιοι είναι οι κύριοι προβληματισμοί μας;

- Ποιες οι βασικές μας βελτιωτικές προτάσεις;

Μπορείτε να διαβάσετε τη Μελέτη μας εδώ.

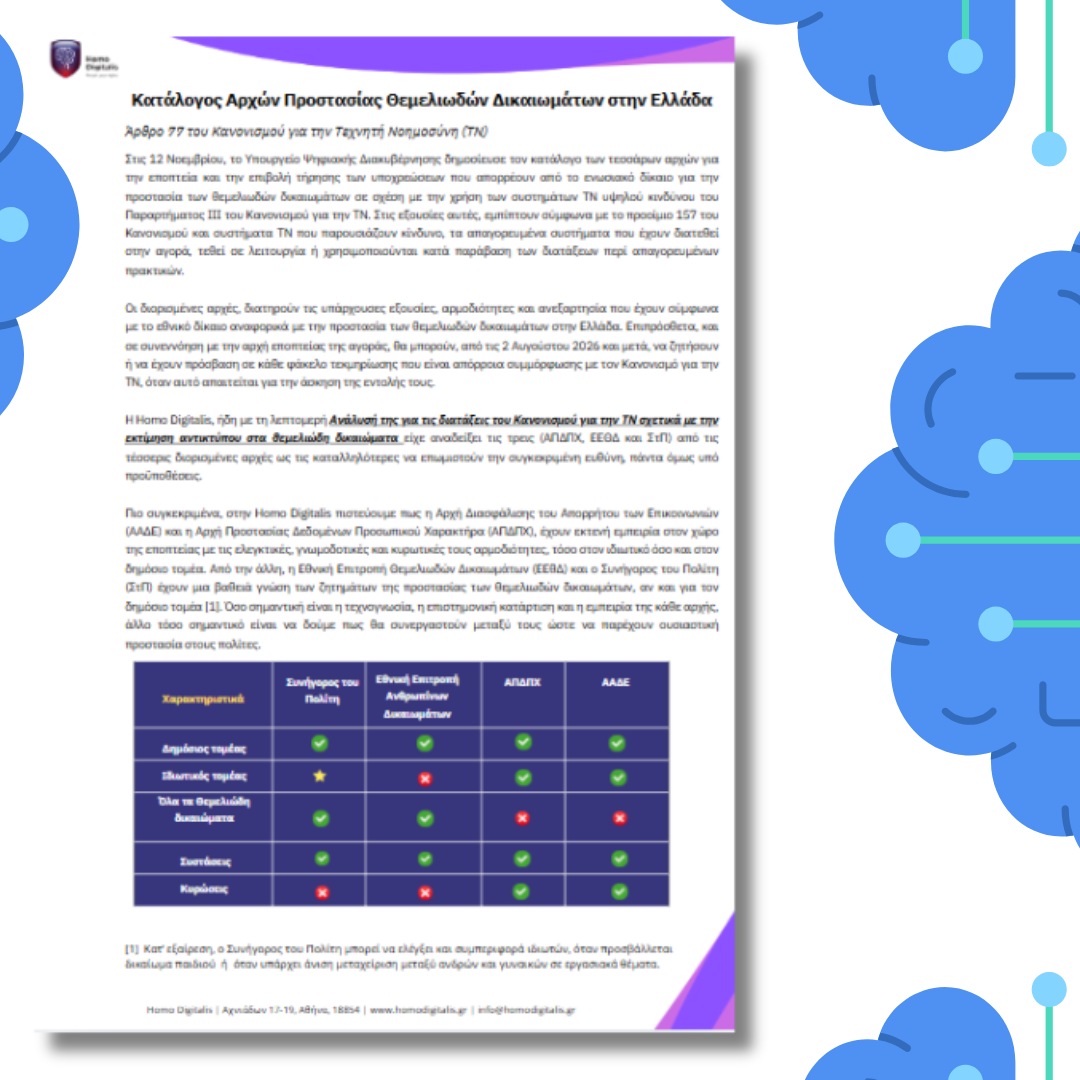

Θυμίζουμε ότι στις 12 Νοεμβρίου, το Υπουργείο Ψηφιακής Διακυβέρνησης έκανε το πρώτο επίσημο βήμα για την εφαρμογή της AI Act, δημοσιεύοντας τον κατάλογο των εθνικών αρχών για την προστασία των Θεμελιωδών Δικαιωμάτων. Οι αρχές αυτές περιλαμβάνουν: Την Αρχή Προστασίας Δεδομένων Προσωπικού Χαρακτήρα, Τον Συνήγορο του Πολίτη, Την Αρχή Διασφάλισης του Απορρήτου των Επικοινωνιών και Την Εθνική Επιτροπή Δικαιωμάτων του Ανθρώπου.

Σχετικά με αυτό, ήδη από τις 25 Οκτωβρίου, με την πρώτη Μελέτη μας «Ανάλυση και προτάσεις ενσωμάτωσης των διατάξεων για την εκτίμηση αντικτύπου στα θεμελιώδη δικαιώματα στην Ελλάδα», είχαμε παρουσιάσει λεπτομερείς προτάσεις γι’ αυτό το ζήτημα. Αν δεν προλάβατε να διαβάσετε τη μελέτη μας, σας προσκαλούμε να δείτε την περίληψη μίας σελίδας που ετοιμάσαμε, ειδικά για τις Εθνικές Αρχές Θεμελιωδών Δικαιωμάτων.

Η δημοσίευση του Υπουργείου ήταν μόνο το πρώτο βήμα. Επόμενη κρίσιμη υποχρέωση είναι ο θεσμικός σχεδιασμός των αρχών εποπτείας της αγοράς, ο οποίος πρέπει να ολοκληρωθεί έως τις 2 Αυγούστου 2025, σύμφωνα με το άρθρο 113 του Κανονισμού.

Η δεύτερη Μελέτη που δημοσιεύουμε σήμερα έχει ακριβώς ως σκοπό να σταθεί αρωγός στο Υπουργείο Ψηφιακής Διακυβέρνησης που έχει ως αποστολή να εκπονήσει το δύσκολο έργο της σύνθεσης του εν λόγω οικοσυστήματος στην Ελλάδα, αλλά και με τις λεπτομερείς αναλύσεις και τα επιχειρήματά μας να βοηθήσουμε στην ωρίμανση του δημόσιου διαλόγου και να δώσουμε τη δυνατότητα σε περισσότερες οργανώσεις της Κοινωνίας των Πολιτών να συμμετέχουν ενεργά σε αυτόν.

Συμμετέχουμε ενεργά στην μεταφορά του AI Act στην Ελλάδα

Την Τρίτη 12 Νοεμβρίου, το Υπουργείο Ψηφιακής Διακυβέρνησης δημοσίευσε τον κατάλογο των εθνικών αρχών και φορέων που επιβάλλουν ή εποπτεύουν την τήρηση των ενωσιακών υποχρεώσεων για την προστασία των Θεμελιωδών Δικαιωμάτων σύμφωνα με το άρθρο 77 του Κανονισμού για την Τεχνητή Νοημοσύνη, διορίζοντας την Αρχή Προστασίας Δεδομένων Προσωπικού Χαρακτήρα, τον Συνήγορο του Πολίτη, την Αρχή Διασφάλισης του Απορρήτου των Επικοινωνιών και την Εθνική Επιτροπή Δικαιωμάτων του Ανθρώπου.

Ήδη από τις 25 Οκτωβρίου, η Homo Digitalis με τη μελέτη της «Ανάλυση και προτάσεις ενσωμάτωσης των διατάξεων για την εκτίμηση αντικτύπου στα θεμελιώδη δικαιώματα στην Ελλάδα» είχε αναπτύξει λεπτομερώς την τοποθέτησή της πάνω σε αυτό το ζήτημα αλλά και των συναφών διατάξεων.

Εάν δεν προλάβατε να διαβάσετε ολόκληρο το κείμενο της μελέτης μας, έχουμε ετοιμάσει μία μονοσέλιδη σχετική περίληψη για τις Εθνικές Αρχές Θεμελιωδών Δικαιωμάτων εδώ.

Υπογραμμίζουμε ότι αυτή η δημοσίευση του Υπουργείου Ψηφιακής Διακυβέρνησης ήταν και η πρώτη υποχρέωση για την εφαρμογή του AI Act σε εθνικό επίπεδο, αλλά και το πρώτο βήμα στην δημιουργία ενός αποτελεσματικού εθνικού συστήματος διακυβέρνησης και εποπτείας της ΤΝ. Μια δεύτερη και σημαντικότατη υποχρέωση είναι αυτή του θεσμικού σχεδιασμού των αρχών εποπτείας της αγοράς που σύμφωνα με το άρθρο 113 περίπτωση β) του Κανονισμού για την ΤΝ θα πρέπει να έχει ολοκληρωθεί μέχρι και τις 2 Αυγούστου 2025. Μέχρι τότε θα πρέπει να γίνει και ο διορισμός των κοινοποιουσών αρχών.

Η Ηοmo Digitalis ερευνά μήνες τώρα το σχετικό ζήτημα και σύντομα θα δημοσιεύσουμε την λεπτομερή ανάλυσή μας!

Σκοπός μας; Να σταθούμε αρωγοί στους φορείς λήψεως αποφάσεων με την εξειδίκευσή μας στα σχετικά ζητήματα, καθώς και να εξοπλίσουμε άλλες οργανώσεις της Κοινωνίας των Πολιτών στην Ελλάδα με επιχειρήματα και γνώση!

O Λευτέρης Χελιουδάκης της Homo Digitalis Εκπαιδευτής σε 2η Εκπαίδευση του OSCE ODIHR για προσωπικά δεδομένα & προστασία συνόρων

Από τις 29 έως τις 31 Οκτωβρίου, ο Λευτέρης Χελιουδάκης, συνιδρυτής και Εκτελεστικός μας Διευθυντής συμμετείχε ως εκπαιδευτής στην Εκπαίδευση που διοργάνωσε ο διεθνής οργανισμός OSCE και συγκεκριμένα το Γραφείο του για τους Δημοκρατικούς Θεσμούς και τα Ανθρώπινα Δικαιώματα (OSCE Office for Democratic Institutions and Human Rights (ODIHR)) διερευνώντας τη χρήση νέων τεχνολογιών στα διεθνή σύνορα, καθώς και τους κινδύνους αλλά και τις ευκαιρίες που απορρέουν σχετικά με τα Δικαιώματα του Ανθρώπου.

Στις 5 παρουσιάσεις μας, εστιάσαμε στις τεχνολογίες που χρησιμοποιούνται στα σύνορα, τα Δικαιώματα του Ανθρώπου που επηρεάζονται από τις εν λόγω χρήσεις, τις διατάξεις του GDPR αλλά και της Οδηγίας 2016/680 LED, τη σημαντική απόφαση της ΑΠΔΠΧ για τα συστήματα “ΚΕΝΤΑΥΡΟΣ” και “ΥΠΕΡΙΩΝ”, καθώς και τεχνικά εργαλεία τα οποία μπορούν να χρησιμοποιήσουν υπερασπιστές των ανθρωπίνων δικαιωμάτων κατά τη δράση τους!

Ευχαριστούμε θερμά τα άτομα που συμμετείχαν στην εκπαίδευση για τη δυναμική τους παρουσία, την ομάδα των εξαιρετικών υπολοίπων εκπαιδευτών Nikola Kovačević, Djordje Alempijevic και Arancha Garcia del Soto για τις γνώσεις και την εμπειρία τους και την ομάδα των διοργανωτών για την άψογη διοργάνωση και τη συμβολή τους, Lola Girard, Veronica Grazzi! Eίναι μεγάλη μας τιμή να συμμετέχουμε!

Μπορείτε να μάθετε περισσότερα εδώ.

Δημοσιεύουμε την πρώτη αναλυτική μελέτη μας για το AI Act και τις διατάξεις των FRIAs

Η Homo Digitalis δημοσιεύει σήμερα την πρώτη Μελέτη της για τον Ευρωπαϊκό Κανονισμό για την Τεχνητή Νοημοσύνη με τίτλο «Πράξη για την Τεχνητή Νοημοσύνη: Ανάλυση και προτάσεις ενσωμάτωσης των διατάξεων για την εκτίμηση αντικτύπου στα θεμελιώδη δικαιώματα στην Ελλάδα».

Συγγραφείς της πρώτης αυτής Μελέτης αποτελούν το μέλος μας Σοφία Αντωνοπούλου και η Διευθύντρια Δικαιωμάτων του Ανθρώπου & Τεχνητής Νοημοσύνης της Homo Digitalis, Λαμπρινή Γυφτοκώστα.

Η Μελέτη αποτελεί την πρώτη από μία σειρά αναλύσεων που θα δημοσιεύσουμε στο προσεχές διάστημα σχετικά με διάφορες σημαντικές διατάξεις του Κανονισμού για την Τεχνητή Νοημοσύνη, οι οποίες έχουν ως σκοπό τόσο να ενημερώσουν τους φορείς λήψεων αποφάσεων στην Ελλάδα για σημαντικές διατάξεις του AI Act προκειμένου να βοηθήσουν στην επιτυχημένη εφαρμογή του, όσο και να πλαισιώσουν τον δημόσιο διάλογο για την Τεχνητή Νοημοσύνη στη χώρα μας παραθέτοντας συγκεκριμένα επιχειρήματα και προτάσεις.

Επίκεντρο της πρώτης Μελέτης της Homo Digitalis είναι η ανάδειξη ορισμένων κρίσιμων ζητημάτων που εγείρει η εφαρμογή των διατάξεων περί Εκτίμησης Αντικτύπου στα Θεμελιώδη Δικαιώματα (ΕΑΘΔ), από την οπτική της κοινωνίας των πολιτών. Εκτός αυτού, στόχος είναι να συμβάλει εποικοδομητικά στον δημόσιο διάλογο, προτείνοντας συγκεκριμένες λύσεις για μια αποτελεσματική διαδικασία εκτίμησης αντικτύπου αναφορικά με τα συστήματα ΤΝ υψηλού ρίσκου.

Συνοπτικά, στα κύρια συμπεράσματα της Μελέτης περιλαμβάνονται οι εξής προβληματισμοί:

- Ο αποκλεισμός από την υποχρέωση διενέργειας ΕΑΘΔ των συστημάτων ΤΝ που χρησιμοποιούνται αποκλειστικά από ιδιωτικές υπηρεσίες.

- Η παντελής έλλειψη κυρώσεων για όσους παραβιάζουν τις διατάξεις για τις ΕΑΘΔ.

- Οι ασάφειες και τα ερμηνευτικά κενά σχετικά με τον τρόπο διενέργειας ΕΑΘΔ, την επικαιροποίηση των στοιχείων και την εκ νέου διενέργεια ΕΑΘΔ, την αξιολόγηση κινδύνων και τα προτεινόμενα μέτρα, την ενημέρωση της αρχής εποπτείας αγοράς και τις εξαιρέσεις από την εν λόγω ενημέρωση της αρχής εποπτείας αγοράς, και

- Η αδιαφάνεια στην χρήση συστημάτων ΤΝ και εκπόνηση ΕΑΘΔ σε τομείς επιβολής του νόμου, διαχείρισης μετανάστευσης και ασύλου και συνοριακών ελέγχων.

Επίσης, συνοψίζονται οι βελτιωτικές προτάσεις σε πέντε βασικά σημεία που είναι κομβικά για την αποτελεσματική προστασία των θεμελιωδών δικαιωμάτων από τυχόν παραβιάσεις συστημάτων ΤΝ:

- Προτείνεται η άσκηση της διακριτικής ευχέρειας με βάση το άρθρο 99 παράγραφος 2 και η θέσπιση κυρώσεων σε περίπτωση μη συμμόρφωσης με τις διατάξεις για τα ΕΑΘΔ. Προτείνεται, περαιτέρω, οι σχετικές κυρώσεις να είναι στην ίδια κλίμακα με αυτές που αφορούν τη μη συμμόρφωση με την απαγόρευση των πρακτικών ΤΝ, σύμφωνα με το άρθρο 99 παράγραφος 3 του Κανονισμού.

- Προτείνεται η θέσπιση αναλυτικών ρυθμίσεων διακυβέρνησης με ξεκάθαρες διαδικασίες διαχείρισης καταγγελιών και προσφυγών καθώς και η εξασφάλιση συμμετοχής συμφεροντούχων στον ελληνικό νόμο που θα ενσωματώσει τον Κανονισμό.

- Τροποποίηση νόμου 4780/2021, οι διατάξεις του οποίου διέπουν τη λειτουργία της Εθνικής Επιτροπής Ανθρωπίνων Δικαιωμάτων για την ανάληψη του ρόλου σύμφωνα με το άρθρο 77 του Κανονισμού υπό προϋποθέσεις.

- Εκτός από το υπόδειγμα για την διενέργεια ΕΑΘΔ, είναι απαραίτητη η εκπόνηση κατευθυντήριων γραμμών, που θα περιλαμβάνουν μια εκτενή ανάλυση της αιτιολογικής σκέψης 96,των άρθρων 6 παράγραφος 2, 27, 43, 46, 49 και 77 του Κανονισμού για την ΤΝ.

Μπορείτε να διαβάσετε αναλυτικά τη Μελέτη της Homo Digitalis εδώ.

Η τοποθέτηση της Ελπίδας Βαμβακάς στο 52 Φεστιβάλ Βιβλίου είναι πλέον διαθέσιμη και σε βίντεο!

Η Homo Digitalis έχει τη μεγάλη τιμή να δώσει το παρόν στο 52 Φεστιβάλ Βιβλίου που έλαβε χώρα στο Πεδίον του Άρεως.

Συγκεκριμένα, την Πέμπτη 19 Σεπτεμβρίου, η συνιδρύτρια και Πρόεδρός μας Ελπίδα Βαμβακά συμμετείχε ως ομιλήτρια σε στρογγυλό τραπέζι που διοργανώθηκε στη κεντρική σκηνή του φεστιβάλ από τον Συνδέσμου Εκδοτών Βιβλίου (Σ.ΕΚ.Β) & την Ελληνική Ακαδημία Κόμικς με θέμα «Γράφεται η τέχνη με ΑΙ;».

Τον συντονισμό της συζήτησης ανέλαβε ο Παναγιώτης Παπαγεωργίου (Νομικός, Μέλος της Ελληνικής Ακαδημίας Κόμικς) και ο Δημήτρης Δούκογλου (εικονογράφος, παρουσιαστής, stand-up κωμικός). Στους άλλους ομιλητές του στρογγυλού τραπεζιού συμπεριλαμβάνονται οι Βασίλης Βλαχοκυρικάκος (Αναπληρωτής Καθηγητής Αλληλεπίδρασης Ανθρώπου-Υπολογιστή) , ο Αβραάμ Κάουα (Συγγραφέας, Μεταφραστής & θεωρητικός του Πολιτισμού) και ο Γιώργος Ναθαναήλ (Σύμβουλος Πληροφορικής και Management).

Ο βιντεογράφος της εκδήλωσης είναι ο Δημήτριος Μπουρνούς και θα θέλαμε να τον ευχαριστήσουμε για το υλικό που μοιράστηκε μαζί μας σχετικά.

Δείτε ολόκληρη την τοποθέτηση της Ελπίδας εδώ.

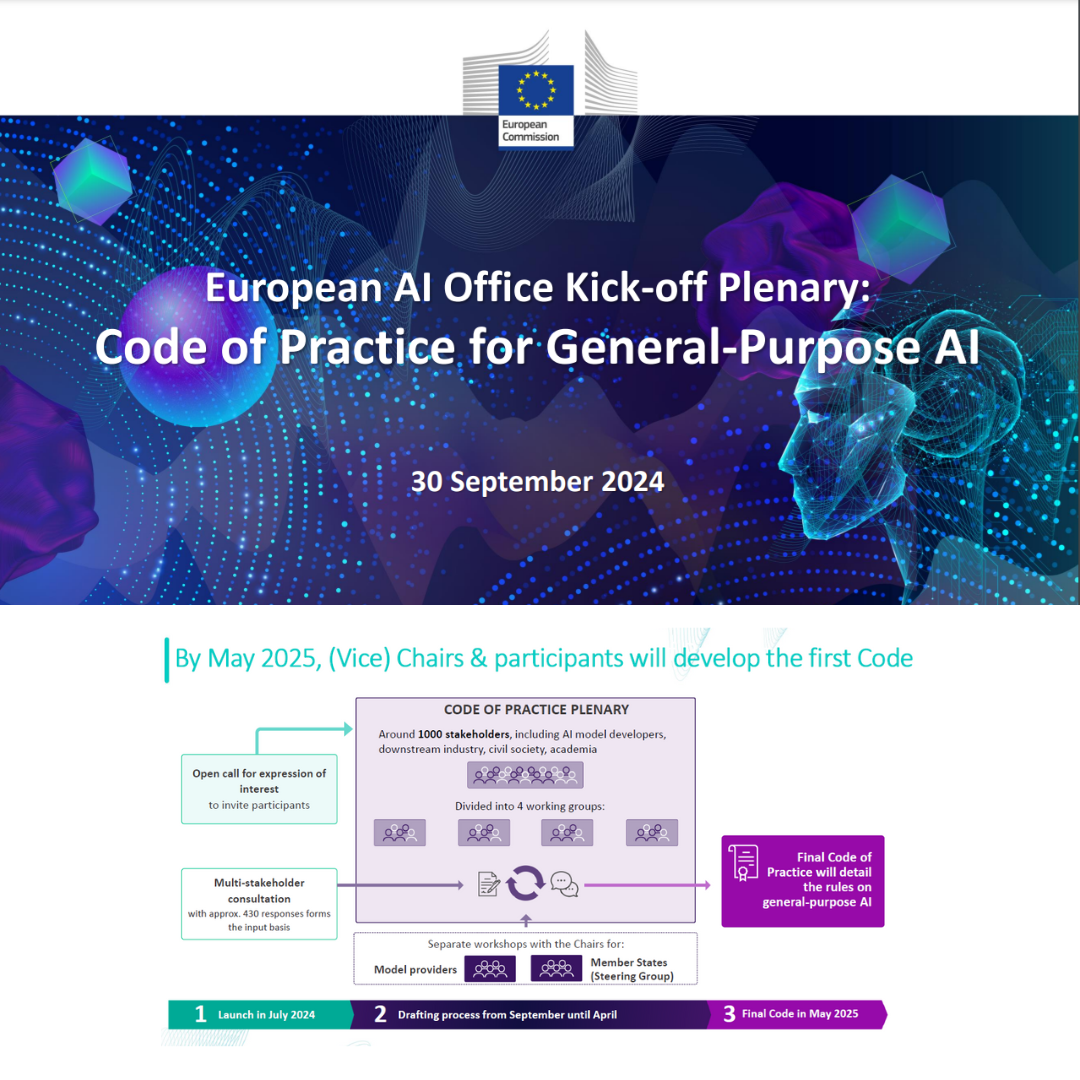

Συμμετοχή της Homo Digitalis σε συνάντηση Ολομέλειας της Ευρωπαϊκής Επιτροπής για το AI Act

Ο Σεπτέμβριος έκλεισε με σημαντικές συναντήσεις για τη Homo Digitalis στο πλαίσιο του Ευρωπαϊκού Κανονισμού για την Τεχνητή Νοημοσύνη (ΑΙ Αct) σε ευρωπαϊκό επίπεδο!

Συγκεκριμένα, στις 30 Σεπτεμβρίου συμμετείχαμε διαδικτυακά στη πρώτη συνάντηση που διοργάνωσε το ΑΙ Office της Ευρωπαϊκής Επιτροπής αναφορικά με την εκπόνηση ενός Κώδικα Ορθής Πρακτικής για τα Συστήματα Τεχνητής Νοημοσύνης Γενικής Χρήσης “Kick-off Plenary: Code of Practice for General-Purpose AI”.

H Homo Digitalis επιλέχθηκε να συμμετάσχει στις σχετικές ομάδες εργασίας που θα σχηματιστούν προκειμένου τους επόμενους μήνες να συνεργαστούμε μαζί με οργανώσεις της Κοινωνίας των Πολιτών και άλλους φορείς σε αυτή την αποστολή για την εκπόνηση του εν λόγω Κώδικα.

Στη διαδικτυακή συνάντηση μας εκπροσώπησαν η Διευθύντρια για ζητήματα Τεχνητής Νοημοσύνης και Δικαιωμάτων του Ανθρώπου Λαμπρινή Γυφτοκώστα και ο συνιδρυτής μας Λευτέρης Χελιουδάκης.