Συμμόρφωση στην Εποχή της Τεχνητής Νοημοσύνης και της Κυβερνοασφάλειας: Πρόκληση ή Ευκαιρία;

Γράφει o Τάσος Αραμπατζής

Για χρόνια, η κυβερνοασφάλεια αγωνιζόταν να εξασφαλίσει μια θέση στην ατζέντα της διοίκησης των επιχειρήσεων. Χρειάστηκαν πρόστιμα εκατομμυρίων, νομικές διαμάχες και υψηλού προφίλ παραβιάσεις δεδομένων για να συνειδητοποιήσουν οι επιχειρήσεις ότι η ασφάλεια δεν είναι απλώς ένα ζήτημα πληροφορικής—είναι επιχειρηματικός κίνδυνος. Κανονισμοί όπως το GDPR, η NIS2 και το EU AI Act λειτουργούν ως καταλύτες, αναγκάζοντας τους οργανισμούς να επενδύσουν στη συμμόρφωση.

Αλλά εδώ είναι το βασικό ερώτημα: Είναι η συμμόρφωση ένα αναγκαίο κακό ή αποτελεί το θεμέλιο μιας ανθεκτικής στρατηγικής κυβερνοασφάλειας;

Συμμόρφωση: Το Ελάχιστο Απαραίτητο Επίπεδο Ασφάλειας

Οι κανονιστικές απαιτήσεις λειτουργούν ως βασική γραμμή άμυνας. Μπορεί να μην προσφέρουν την πιο εξελιγμένη προστασία, αλλά καθορίζουν μια δομημένη προσέγγιση στη διαχείριση κινδύνων. Σύμφωνα με την τελευταία έκθεση Thales Data Threat Report 2024, οι οργανισμοί που απέτυχαν σε ελέγχους συμμόρφωσης υπέστησαν περισσότερες παραβιάσεις δεδομένων από εκείνους που πέτυχαν. Το συμπέρασμα είναι σαφές—η συμμόρφωση δεν αφορά μόνο την αποφυγή προστίμων, αλλά και την αποτροπή κυβερνοεπιθέσεων.

Για παράδειγμα, οι επιχειρήσεις που επένδυσαν σε πρακτικές προστασίας δεδομένων λόγω του GDPR βρίσκονται τώρα σε πλεονεκτική θέση για να αντιμετωπίσουν τις νέες προκλήσεις των κανονισμών για την τεχνητή νοημοσύνη. Αντίστοιχα, η NIS2 επιβάλλει μέτρα ασφαλείας βάσει κινδύνου, τα οποία ευθυγραμμίζονται με τις βέλτιστες πρακτικές κυβερνοασφάλειας.

Κανονιστική Υπερφόρτωση; Όχι Ακριβώς.

Ένα συχνό παράπονο των επαγγελματιών ασφάλειας είναι ότι βυθίζονται σε κανονιστικές απαιτήσεις. Όμως, αν εξετάσουμε προσεκτικά τους κανονισμούς, παρατηρούμε σημαντικές επικαλύψεις.

- EU AI Act vs. GDPR: Ο Νόμος για την ΤΝ (AI Act) επεκτείνει τις αρχές του GDPR, επιβάλλοντας διαφάνεια στις αποφάσεις που λαμβάνονται από συστήματα ΤΝ.

- NIS2 vs. DORA: Το DORA και η NIS2 επιβάλλουν παρόμοιες απαιτήσεις κυβερνοασφάλειας σε χρηματοπιστωτικά ιδρύματα, εξασφαλίζοντας ανθεκτικότητα έναντι κυβερνοαπειλών.

Η κατανόηση αυτών των αλληλεπικαλύψεων επιτρέπει στους οργανισμούς να αναπτύξουν μια ενοποιημένη στρατηγική συμμόρφωσης αντί να αντιμετωπίζουν κάθε κανονισμό ξεχωριστά. Παρότι το κανονιστικό τοπίο φαίνεται ομιχλώδες, εντούτοις ακολουθώντας μία ολιστική προσέγγιση επιτρέπει στις επιχειρήσεις να συμμορφωθούν με περισσότερη εμπιστοσύνη.

Η Παγίδα της Πολυπλοκότητας: Όταν η Συμμόρφωση Γίνεται Γρίφος

Δεν είναι όμως όλα τόσο απλά. Πολλοί κανονισμοί είναι σκόπιμα γενικοί ώστε να μπορούν να εφαρμόζονται σε μία πλειάδα περιπτώσεων. Αυτή όμως η γενικότητα προσθέτει περισσότερη πολυπλοκότητα, αναγκάζοντας τις επιχειρήσεις να τους προσαρμόσουν στις δικές τους ανάγκες. Αυτό δημιουργεί ένα δίλημμα: Πώς μπορεί μια εταιρεία να διασφαλίσει τη συμμόρφωση αν δεν είναι σαφές τι ακριβώς απαιτείται;

Ένα χαρακτηριστικό παράδειγμα είναι το Άρθρο 86 του EU AI Act, το οποίο δίνει στους πολίτες το δικαίωμα να λαμβάνουν “σαφείς και ουσιαστικές εξηγήσεις” για το πώς ένα σύστημα ΤΝ επηρεάζει μια απόφαση. Σύμφωνα με την Luiza Jarovsky, αυτή η απαίτηση εγείρει κρίσιμα ερωτήματα:

- Αν ακόμη και οι ίδιοι οι δημιουργοί των συστημάτων ΤΝ δεν μπορούν να εξηγήσουν πλήρως πώς λειτουργούν (το πρόβλημα του “μαύρου κουτιού”), πώς μπορούν οι οργανισμοί να δώσουν ξεκάθαρες απαντήσεις;

- Είναι τεχνολογικά εφικτό να συμμορφωθούν οι εταιρείες με αυτή την απαίτηση;

Αυτές οι αβεβαιότητες δημιουργούν ένταση μεταξύ της ρυθμιστικής φιλοδοξίας και της τεχνικής πραγματικότητας.

Βελτιώνουν τα Πρόστιμα την Ασφάλεια;

Παρόλο που τα πρόστιμα είναι ισχυρό κίνητρο, συχνά οδηγούν σε επιφανειακή συμμόρφωση αντί για ουσιαστικές βελτιώσεις ασφάλειας.

Το GDPR υπάρχει από το 2018, αλλά οι παραβιάσεις δεδομένων συνεχίζονται αμείωτες. Μερικές εταιρείες βλέπουν τη συμμόρφωση ως οικονομική εξίσωση:

“Αν το κόστος της συμμόρφωσης είναι μεγαλύτερο από το ρίσκο του προστίμου, γιατί να συμμορφωθούμε;”

Το ίδιο ερώτημα θα προκύψει και με τον EU AI Act. Αν οι οργανισμοί δυσκολευτούν να συμμορφωθούν με τις απαιτήσεις διαφάνειας στην ΤΝ, θα επιβληθούν βαριά πρόστιμα ή θα υιοθετηθεί μια πιο ήπια προσέγγιση μέχρι να καθοριστούν οι βέλτιστες πρακτικές;

Και βεβαίως δεν θα πρέπει να ξεχνάμε την επίδραση της τρέχουσας γεωπολιτικής κατάστασης στο πως τελικά θα επιβληθεί η εκάστοτε νομοθεσία. Η πρόσφατη απόφαση για την απόσυρση του ΑΙ Liability Directive είναι ένα παράδειγμα αυτής της επίδρασης.

Η Πρόκληση της Εφαρμογής: Ποιος Επιβλέπει τους Ρυθμιστές;

Οι κανονισμοί είναι αποτελεσματικοί μόνο αν εφαρμόζονται σωστά. Το EU AI Act εισάγει νέες απαιτήσεις συμμόρφωσης, αλλά έχουν οι ρυθμιστικές αρχές την τεχνογνωσία να επιβλέψουν πολύπλοκα μοντέλα ΤΝ;

Το GDPR αντιμετώπισε σοβαρές προκλήσεις στην επιβολή του:

- Οι ρυθμιστικές αρχές είναι συχνά υποστελεχωμένες, καθυστερώντας τις έρευνες.

- Υπάρχει ασυνέπεια στην επιβολή των κανόνων μεταξύ των κρατών-μελών της ΕΕ.

Ο EU AI Act είναι ακόμη πιο πολύπλοκος. Αν οι ρυθμιστές δεν μπορούν να επιβάλουν αυστηρή συμμόρφωση, οι επιχειρήσεις μπορεί να καθυστερήσουν τις προσαρμογές τους, περιμένοντας να δουν αν οι κανόνες θα εφαρμοστούν πραγματικά.

Η πρόσφατη εξέλιξη με το Smart Policing της ΕΛΑΣ αναδεικνύει αυτό ακριβώς το πρόβλημα:

“Τα 4,5 χρόνια έρευνας της ΑΠΔΠΧ, φανερώνουν επίσης ότι η πολιτεία πρέπει να στηρίξει την Αρχή Προστασίας Δεδομένων, καθώς η υψηλή εξειδίκευση των ελεγκτών της δεν είναι αρκετή, αλλά αντιθέτως απαιτούνται περισσότεροι ανθρώπινοι και οικονομικοί πόροι. Και όλα αυτά χωρίς να υπολογίζουμε τον αυξημένο φόρτο εργασίας που προβλέπεται τα ερχόμενα χρόνια με την AI Act.”

Οι ακούσιες συνέπειες της συμμόρφωσης: Καταπνίγοντας την καινοτομία;

Ενώ τα πλαίσια συμμόρφωσης αποσκοπούν στην προστασία των καταναλωτών και των επιχειρήσεων, μπορούν επίσης να δημιουργήσουν εμπόδια στην καινοτομία. Ο GDPR προοριζόταν να ενισχύσει τα δικαιώματα προστασίας της ιδιωτικής ζωής, αλλά πολλές μικρές επιχειρήσεις αντιμετώπισαν και αντιμετωπίζουν με δυσκολία το βάρος της συμμόρφωσης, οδηγώντας σε:

- Σε φυγή των νεοφυών επιχειρήσεων σε λιγότερο ρυθμιζόμενες αγορές.

- Εμπόδια στην καινοτομία λόγω της νομικής αβεβαιότητας.

Θα μπορούσε να συμβεί το ίδιο με την πράξη της ΕΕ για την τεχνητή νοημοσύνη; Οι νεοσύστατες επιχειρήσεις τεχνητής νοημοσύνης ίσως βρουν ευκολότερο να δραστηριοποιηθούν στις ΗΠΑ ή την Ασία, όπου οι κανονισμοί είναι λιγότερο αυστηροί. Η ακούσια συνέπεια; Η Ευρώπη θα μπορούσε να μείνει πίσω στην ανάπτυξη της τεχνητής νοημοσύνης, παρά το γεγονός ότι ήταν από τους πρώτους που τη ρύθμισαν.

Συμμόρφωση ως ανταγωνιστικό πλεονέκτημα

Οι οργανισμοί που σκέφτονται μπροστά από την εποχή τους αλλάζουν το σενάριο και αντιμετωπίζουν τη συμμόρφωση όχι ως βάρος ή πρόκληση, αλλά ως ανταγωνιστικό διαφοροποιητικό στοιχείο. Για παράδειγμα, σύμφωνα με έρευνα της Thales, το 89% των πελατών θα συμφωνούσαν με την χρήση των δεδομένων τους μόνο εφόσον υπάρχουν βασικές πολιτικές ασφάλειας και ιδιωτικότητας. Οι εταιρείες που αντιμετωπίζουν προληπτικά τη διαφάνεια της ΤΝ, την προστασία των δεδομένων και τους κινδύνους κυβερνοασφάλειας θα κερδίσουν μεγαλύτερη εμπιστοσύνη από πελάτες και συνεργάτες.

Πάρτε για παράδειγμα τις χρηματοπιστωτικές υπηρεσίες που βασίζονται στην ΤΝ. Μια τράπεζα που μπορεί να εξηγήσει με σαφήνεια γιατί απορρίφθηκε ένα δάνειο (σύμφωνα με τον νόμο περί ΤΝ) θα καλλιεργήσει ισχυρότερες σχέσεις με τους πελάτες της από μια τράπεζα που κρύβεται πίσω από την αλγοριθμική αδιαφάνεια. Παρομοίως, ένας πάροχος υγειονομικής περίθαλψης με ισχυρό πλαίσιο ασφαλείας συμβατό με το NIS2 θα ξεχωρίσει ως αξιόπιστος φορέας σε έναν κλάδο που μαστίζεται από παραβιάσεις δεδομένων.

Τελική σκέψη: Η συμμόρφωση δεν είναι επιλογή-αλλά ο τρόπος που την προσεγγίζετε είναι

Ρυθμιστικά πλαίσια όπως ο GDPR, η NIS2 και ο νόμος της ΕΕ για την τεχνητή νοημοσύνη ήρθαν για να μείνουν. Θα διαμορφώσουν τον τρόπο λειτουργίας των επιχειρήσεων στην ψηφιακή οικονομία, επηρεάζοντας τα πάντα, από τη διακυβέρνηση της ΤΝ έως τις επενδύσεις στην κυβερνοασφάλεια. Οι οργανισμοί μπορούν να επιλέξουν να βλέπουν τη συμμόρφωση ως βάρος, αντιδρώντας σε κάθε νέα εντολή με απογοήτευση - ή μπορούν να την αγκαλιάσουν ως θεμέλιο για την οικοδόμηση εμπιστοσύνης, ασφάλειας και μακροπρόθεσμης επιτυχίας.

Ποια θα είναι η δική σας προσέγγιση;

Η Ψηφιοποίηση της Ελληνικής Δικαιοσύνης Υπό το Πρίσμα της Τεχνητής Νοημοσύνης

Γράφει η Καλλιόπη Τερζίδου*

Η ψηφιοποίηση των δικαστηρίων σε επίπεδο διοίκησης και υπηρεσιών δεν ευδοκίμησε νωρίς στην Ελλάδα λόγω έλλειψης συστηματικού σχεδιασμού και καταφυγής σε πρόχειρες και πρόσκαιρες λύσεις για την επίλυση προβλημάτων [1]. Πλέον, οι δικηγόροι μπορούν να πραγματοποιούν μια σειρά διαδικασιών ηλεκτρονικά, όπως της αναζήτησης της πορείας πολιτικών υποθέσεων και των πινακίων της πολιτικής διαδικασίας, μέσω της Πύλης Ψηφιακών Υπηρεσιών Δικαστηρίων και Εισαγγελιών – ΟΣΔΔΥ (solon.gov.gr). Οι πολίτες έχουν πρόσβαση στις ίδιες ηλεκτρονικές υπηρεσίες με τους δικηγόρους (με εξαίρεση την κατάθεση εγγράφων), στην ψηφιακή επίδοση εγγράφων (N. 4937/2022) και στην υπηρεσία τηλεδιασκέψεων για Πολιτικά, Ποινικά και Διοικητικά Δικαστήρια, μεταξύ άλλων.

Οι πρωτοβουλίες αυτές για την ψηφιοποίηση των δικαστικών υπηρεσιών είναι σημαντικές αλλά δεν είναι πάντα αποτελεσματικές. Σύμφωνα με στοιχεία της Ένωσης Δικαστών και Εισαγγελέων [2], τα ποσοστά χρήσης των πλατφορμών του ΟΣΔΔΥ εμφανίστηκαν αρχικά χαμηλά σε σχέση με την προτίμηση των πολιτών στη δια ζώσης εξυπηρέτηση τους. Περαιτέρω, η νομολογία δεν είναι εξίσου προσβάσιμη στο ευρύ κοινό όπως στους δικηγόρους, αφού δε βρίσκεται συγκεντρωμένη σε ένα περιορισμένο αριθμό ιστοσελίδων. Έτσι ο πολίτης αναγκάζεται να επισκέπτεται την ιστοσελίδα του δικαστηρίου για το οποίο ενδιαφέρεται, με κίνδυνο να μην βρει αυτό που ψάχνει. Αυτό συμβαίνει καθώς πολλές φορές τα δικαστήρια δεν δημοσιοποιούν όλες τις αποφάσεις, για παράδειγμα λόγω μη ανωνυμοποίησης των αποφάσεων, εμπλοκής ανηλίκων στην υπόθεση, εφαρμογής συστήματος προτεραιοποίησης αποφάσεων προς δημοσιοποίηση, ή και αναποτελεσματικής διοίκησης των δικαστηρίων.

Για την αντιμετώπιση αυτών των περιορισμών, η Διαρκής Επιστημονική Επιτροπή του Υπουργείου Δικαιοσύνης για την Τεχνητή Νοημοσύνη (ΤΝ) διερευνά τις πιθανές εφαρμογές συστημάτων ΤΝ στα δικαστήρια, καθώς η ΤΝ υπόσχεται την αποτελεσματικότερη αυτοματοποίηση διαδικασιών και την αμεσότερη αλληλεπίδραση των συστημάτων με τους χρήστες. Η Επιτροπή υποβάλει προτάσεις για νομοθετικές μεταρρυθμίσεις σχετικά με την εισαγωγή συστημάτων ΤΝ στα δικαστήρια και με την καθιέρωση δικλείδων ασφαλείας των δικαιωμάτων των πολιτών.

Σύμφωνα με τις διαθέσιμες πληροφορίες της Διαρκούς Επιτροπής, δεν σχεδιάζεται ή εφαρμόζεται κάποιο σύστημα ΤΝ ‘υψηλού κινδύνου’ στα ελληνικά δικαστήρια, δηλαδή κάποιο σύστημα που μπορεί να επηρεάσει τη δημοκρατία, το κράτος δικαίου και τις ατομικές ελευθερίες, όπως το δικαίωμα στη δίκαιη δίκη [3]. Μόνη εξαίρεση μπορεί να θεωρηθεί το σχέδιο υλοποίησης συστήματος ΤΝ για τον εντοπισμό από τους ελεγκτές του Ελεγκτικού Συνεδρίου πιθανών παρατυπιών στην καταβολή δαπανών ή στην είσπραξη εσόδων του ελεγχόμενου φορέα [4]. Το εν λόγω σύστημα ΤΝ θα επιτρέπει στους ελεγκτές να επικεντρώνονται στις υποθέσεις εκείνες που παρουσιάζουν μεγάλη πιθανότητα παρατυπίας στη λειτουργία των συστημάτων οικονομικής διαχείρισης των ελεγχόμενων φορέων. Στο βαθμό που το συγκεκριμένο σύστημα ελέγχει κάποια πραγματικά περιστατικά έναντι μιας νομικής βάσης και διεξάγει συμπεράσματα για πιθανές παρατυπίες, μπορεί να θεωρηθεί ως σύστημα υψηλού κινδύνου σύμφωνα με το Παράρτημα ΙΙΙ, παράγραφος 8 του Κανονισμού για την ΤΝ. Ουσιαστικά, ο υψηλός κίνδυνος συνίσταται στην υποκατάσταση από το σύστημα ΤΝ της κρίσης των ελεγκτών ως προς την πιθανότητα ή μη παρατυπίας, ώστε να περιορίζεται η ανθρώπινη παρέμβαση και εποπτεία της λειτουργίας του συστήματος. Έτσι, πρέπει να εφαρμόζονται οι δικλείδες ασφαλείας για την ορθή εκπαίδευση και λειτουργία των συστημάτων ΤΝ κατά τα Άρθρα 8-15 του Κανονισμού.

Σε κάθε περίπτωση, η Διαρκής Επιτροπή τείνει στην ενσωμάτωση συστημάτων ΤΝ για την υποστήριξη ‘αμιγώς βοηθητικών διοικητικών δραστηριοτήτων,’ όπως τις χαρακτηρίζει ο Κανονισμός στο Προοίμιο 61. Αυτό διαφαίνεται από τα προβλεπόμενα σχέδια ενσωμάτωσης συστημάτων ΤΝ για σκοπούς όπως η ανωνυμοποίηση των δικαστικών αποφάσεων και ο έλεγχος της αναφοράς του δικηγόρου ως «Παραστάς» στη δικαστική απόφαση ώστε να του δίνεται πρόσβαση σε δικαστικά έγγραφα [5]. Το κοινό στοιχείο αυτών των συστημάτων είναι η επεξεργασία δικαστικών εγγράφων και η (περιορισμένη) αυτοματοποίηση διοικητικών δραστηριοτήτων με στόχο την υποστήριξη των δικαστικών υπαλλήλων και την επιτάχυνση της δίκης.

Ωστόσο, ο μεγαλύτερος κίνδυνος για την επιτυχή ενσωμάτωση συστημάτων ΤΝ στη διοίκηση των δικαστηρίων είναι η εφαρμογή διαφορετικών αλγοριθμικών συστημάτων ή και πρακτικών ανά δικαστήριο. Για παράδειγμα, η διαφορετικοί τρόποι σύνταξης των δικαστικών αποφάσεων ανά δικαστήριο ενδέχεται να μπερδεύουν το αλγοριθμικό σύστημα, καθώς έχει εκπαιδευτεί να επεξεργάζεται ένα συγκεκριμένο μοτίβο αποφάσεων ώστε να μη δύναται να λειτουργήσει σε διαφορετικό πλαίσιο. Ένας ακόμη κίνδυνος για την επιτυχή ενσωμάτωση συστημάτων ΤΝ είναι η έλλειψη μηχανογραφημένων εγγράφων τα οποία το αλγοριθμικό σύστημα μπορεί να επεξεργαστεί για να εκπαιδευτεί και να λειτουργήσει αποτελεσματικά. Έτσι, συχνά ένας ή μερικοί δικαστικοί υπάλληλοι αναλαμβάνουν κατά χειρωνακτικό τρόπο (χωρίς την υποστήριξη ψηφιακών μέσων) την επεξεργασία εγγράφων, όπως οι δικαστικές αποφάσεις, για την εκτέλεση διοικητικών δραστηριοτήτων, όπως η ανωνυμοποίηση των αποφάσεων, υποβαθμίζοντας έτσι την αποτελεσματικότητα και την επιτάχυνση των διοικητικών διαδικασιών .

Μελλοντικές πρωτοβουλίες ενσωμάτωσης συστημάτων ΤΝ στη διοίκηση των δικαστηρίων πρέπει να ελέγχονται για την ύπαρξη υψηλού κινδύνου, κυρίως όσον αφορά το δικαίωμα των πολιτών στη δίκαιη δίκη. Γι’ αυτόν το λόγο, οι υπεύθυνοι φορείς στον τομέα της δικαιοσύνης πρέπει να διενεργούν εκτιμήσεις αντικτύπου σε τακτά χρονικά διαστήματα, ώστε να εκτιμώνται οι πιθανοί κίνδυνοι που ενέχουν τα επιμέρους συστήματα ΤΝ για τα δικαιώματα των πολιτών, να αποτιμώνται οι επιπτώσεις της πραγματοποίησης τέτοιων κινδύνων, και να προβλέπονται μέτρα αντιμετώπισης τους. Στις περισσότερες περιπτώσεις, η επέμβαση προγραμματιστών θα είναι αρκετή για την επίλυση λειτουργικών ζητημάτων. Ωστόσο, η λειτουργία συστημάτων ΤΝ πρέπει να αντιμετωπίζεται ολιστικά, ώστε όχι μόνο οι προγραμματιστές αλλά και οι υπεύθυνοι φορείς και οι χρήστες των συστημάτων να συμμετέχουν στον σχεδιασμό, στην υλοποίηση και στην αξιολόγηση της λειτουργίας τους στα δικαστήρια. Μόνο μέσω ενός αποτελεσματικού και ουσιαστικού διαλόγου μεταξύ όλων των εμπλεκόμενων φορέων μπορεί να επιτευχθεί μια ομαλή και ασφαλής ενσωμάτωση συστημάτων ΤΝ στη δικαιοσύνη, με τελικό αποδέκτη των ωφελειών τους τους πολίτες.

Επιπρόσθετα, θα πρέπει να παρέχεται συνδρομή στους χρήστες των συστημάτων ΤΝ, ώστε να εφοδιάζονται με ψηφιακές δεξιότητες για την ανεμπόδιστη χρήση των συστημάτων που αφορούν είτε τη διοίκηση των δικαστηρίων είτε τις δικαστικές υπηρεσίες. Η διαλειτουργικότητα των ψηφιακών πλατφορμών και μητρώων (ως τώρα περιορισμένη μέσω gov.gr και TAXISNET) διευκολύνει περαιτέρω την πρόσβαση των χρηστών με ένα κλικ στις ηλεκτρονικές υπηρεσίες και την ταυτόχρονη ενημέρωση μιας υπόθεσης με κάθε καινούρια ενέργεια, ωθώντας τους χρήστες να προτιμούν την ηλεκτρονική έναντι της φυσικής οδού.

* Η Καλλιόπη Τερζίδου είναι Υποψήφια Διδάκτωρ της Νομικής Σχολής του Πανεπιστημίου του Λουξεμβούργου. Η έρευνα της υποστηρίζεται από το Fonds National de la Recherche (PRIDE 19/14268506).

[1] Θ. Φορτσάκης, Συμβολή για την Αποτελεσματικότητα της Δικαιοσύνης, Νομική Βιβλιοθήκη, Μάιος 2015, 233-234.

[2] Ένωση Δικαστών και Εισαγγελέων, Η Ελληνική Δικαιοσύνη το 2040, Οκτώβριος 2021, 22-25.

[3] Κανονισμός (ΕΕ) 2024/1689 του Ευρωπαϊκού Κοινοβουλίου και του Συμβουλίου, της 13ης Ιουνίου 2024, για τη θέσπιση εναρμονισμένων κανόνων σχετικά με την τεχνητή νοημοσύνη.

[4] Διαρκής Επιστημονική Επιτροπή Του ΥΔ Για Την Τεχνητή Νοημοσύνη, Πρακτικό συνεδρίασης 28 Μαΐου 2024, 21.

[5] Δρ. Ηλίας Λυμπερόπουλος, Εφαρμογές NLP-AI Πρωτοδικείου Αθηνών.

Η Ψηφιοποίηση της Δικαιοσύνης στην Ευρωπαϊκή Ένωση μέσω της Τεχνητής Νοημοσύνης

Γράφει η Καλλιόπη Τερζίδου*

Η Ευρωπαϊκή Ένωση (ΕΕ) είναι ενεργή εδώ και αρκετά χρόνια στην θέσπιση κανόνων και συστάσεων για την ψηφιοποίηση της διοίκησης των δικαστηρίων, μεταξύ άλλων μέσω συστημάτων ΤΝ. Κύρια προτεραιότητά της είναι η διασφάλιση του σεβασμού του δικαιώματος σε μία δίκαιη δίκη, εξασφαλίζοντας την ελεύθερη και πραγματική προσφυγή των πολιτών σε ανεξάρτητα και αμερόληπτα δικαστήρια. Η δράση αυτή της ΕΕ για την ψηφιοποίηση της δικαιοσύνης στα Κράτη Μέλη αντικατοπτρίζεται στον Κανονισμό για την ΤΝ. Το Προοίμιο 61 του Κανονισμού διακρίνει μεταξύ συστημάτων που προορίζονται για «αμιγώς βοηθητικές διοικητικές δραστηριότητες», όπως η ανωνυμοποίηση δικαστικών αποφάσεων, και συστημάτων που προορίζονται ή επηρεάζουν στην πράξη την απονομή δικαιοσύνης, δηλαδή συστημάτων για «την παροχή συνδρομής σε δικαστικές αρχές κατά την έρευνα και την ερμηνεία των πραγματικών περιστατικών και του νόμου και κατά την εφαρμογή του νόμου σε συγκεκριμένο σύνολο πραγματικών περιστατικών» [1].

Στη δεύτερη περίπτωση, τα συστήματα ΤΝ χαρακτηρίζονται ως ‘υψηλού κινδύνου,’ διότι μπορεί να έχουν σημαντικό αντίκτυπο στη δημοκρατία, το κράτος δικαίου και τις ατομικές ελευθερίες, όταν υποκαθιστούν τους δικαστές στην τελική λήψη αποφάσεων. Τα συγκεκριμένα συστήματα επιτρέπεται να χρησιμοποιούνται από τις δικαστικές αρχές, ωστόσο οι πάροχοι τους πρέπει να συμμορφώνονται με τις απαιτήσεις των Άρθρων 8-15 του Κανονισμού. Αυτές οι απαιτήσεις αφορούν θέματα διαχείρισης κινδύνων, όπως οι διακρίσεις, καθ’ όλη τη διάρκεια λειτουργίας των συστημάτων, προστασίας (προσωπικών) δεδομένων, διαφάνειας και ανθρώπινης εποπτείας.

Σε κάθε περίπτωση, η διάκριση αυτή του Προοιμίου περισσότερο μπερδεύει παρά βοηθάει τους εθνικούς νομοθέτες (και κατ’ επέκταση τις δικαστικές αρχές) στην επιτυχή ψηφιοποίηση της διοίκησης των δικαστηρίων μέσω συστημάτων ΤΝ. Συγκεκριμένα, το Προοίμιο 61 του Κανονισμού προβαίνει σε μια εντελώς επιφανειακή κατηγοριοποίηση των συστημάτων ΤΝ για τον τομέα της δικαιοσύνης, με σοβαρές ερμηνευτικές ασάφειες. Αρχικά, δεν είναι ξεκάθαρο εάν τα συστήματα ΤΝ υψηλού κινδύνου πρέπει σωρευτικά να διενεργούν τις λειτουργίες της ‘έρευνας’ και ‘ερμηνείας’ των πραγματικών περιστατικών και του νόμου και της ‘εφαρμογής’ του νόμου στα πραγματικά περιστατικά. Εάν το εν λόγω σύστημα ΤΝ εκτελεί μόνο μία από αυτές τις λειτουργίες, π.χ. την ερμηνεία σχετικής νομοθεσίας ή/και νομολογίας στα πλαίσια διερεύνησης μια υπόθεσης από τον δικαστή χωρίς όμως την εφαρμογή της στα πραγματικά περιστατικά, τότε το συγκεκριμένο σύστημα δεν μπορεί να χαρακτηριστεί υψηλού κινδύνου με βάση το γράμμα του νόμου.

Τελολογικά, όμως, είναι εύλογο να χαρακτηριστεί αυτοτελώς ως ‘υψηλού κινδύνου’ ένα σύστημα ΤΝ που περιορίζεται στην ερμηνεία του νόμου, δεδομένου ότι ο δικαστής μπορεί να επηρεαστεί από τις συστάσεις του συστήματος (πιθανώς εσφαλμένες ή άλλως προβληματικές) κατά τη δικαστική του κρίση και έτσι να πάψει να είναι ανεξάρτητος. Στην τελική, η μη απαγόρευση χρήσης συστημάτων ΤΝ που υποστηρίζουν την εφαρμογή του νόμου σε συγκεκριμένο σύνολο πραγματικών περιστατικών είναι αμφιλεγόμενη επιλογή του νομοθέτη, ειδικά όταν το Προοίμιο 61 αναφέρει ότι «η τελική λήψη αποφάσεων πρέπει να παραμείνει δραστηριότητα κατευθυνόμενη από τον άνθρωπο». Έτσι, τίθενται ερωτήματα ως προς την έκταση της ‘συνδρομής’ που τα συστήματα ΤΝ πρέπει να προσφέρουν στους δικαστές.

Άλλη μια ερμηνευτική ασάφεια αφορά την αναγνώριση συστημάτων ΤΝ που προορίζονται για ‘αμιγώς βοηθητικές’ διοικητικές δραστηριότητες και τα οποία αντιδιαστέλλονται από τα συστήματα ΤΝ ‘υψηλού κινδύνου.’ Αν και το Προοίμιο 61 αναφέρει μια σειρά παραδειγμάτων διοικητικών δραστηριοτήτων, συμπεριλαμβανομένης της ψευδωνυμοποίησης των αποφάσεων, δεν είναι ξεκάθαρο τι εννοείται με τους προσδιορισμούς ‘αμιγώς’ και ‘βοηθητικές.’ Θα μπορούσε, για παράδειγμα, να ειπωθεί ότι η ανάθεση υποθέσεων στους δικαστές είναι μια αμιγώς βοηθητική διοικητική διαδικασία λόγω της επαναλαμβανόμενης και τυποποιημένης φύσης της δραστηριότητας αυτής, ωστόσο ένας τέτοιος χαρακτηρισμός θα αγνοούσε τις αρνητικές επιπτώσεις της αποτυχημένης ανάθεσης μιας υπόθεσης από ένα σύστημα ΤΝ. Κάτι τέτοιο μπορεί να συμβεί όταν το σύστημα αγνοεί μια υπάρχουσα σύγκρουση συμφερόντων, έτσι ώστε να απειλείται η αμεροληψία του δικαστή και κατ’ επέκταση το δικαίωμα στη δίκαιη δίκη, μετατρέποντας έτσι το σύστημα ΤΝ σε ‘υψηλού κινδύνου.’

Περαιτέρω ερωτήματα ανακύπτουν αναφορικά με την χρήση από δικαστές συστημάτων ΤΝ γενικού σκοπού (π.χ. ChatGPT) ή συστημάτων που προορίζονται (από τον πάροχο) για χρήση από δικηγόρους και όχι για «για χρήση από δικαστική αρχή ή για λογαριασμό δικαστικής αρχής,» όπως αναφέρει το Προοίμιο 61. Σε μια τέτοια περίπτωση, είναι πιθανό συστήματα ΤΝ που χρησιμοποιούνται από τους δικαστές για την έρευνα, ερμηνεία και εφαρμογή των πραγματικών περιστατικών και του νόμου να μην χαρακτηριστούν ως ‘υψηλού κινδύνου΄ γιατί προορίζονται από τον πάροχο για χρήση από το ευρύ κοινό ή από δικηγόρους.

Για παράδειγμα, η χρήση του ChatGPT, ως συστήματος ΤΝ γενικού σκοπού, από έναν δικαστή για την έρευνα κάποιας νομοθεσίας δεν επιφέρει άμεσα τον χαρακτηρισμό του ως ‘υψηλού κινδύνου’ γιατί προορίζεται για χρήση από το ευρύ κοινό. Έτσι, ο πάροχος δεν επιβαρύνεται με την τήρηση των απαιτήσεων των Άρθρων 8-15 του Κανονισμού. Παρόλα αυτά, συστημικοί κίνδυνοι, όπως οι λεγόμενες ‘παραισθήσεις’ όταν το ChatGPT παρουσιάζει μια ψευδή πληροφορία ως αληθινή με αποτέλεσμα να παραπλανεί τον χρήστη, απειλούν το δικαίωμα στην δίκαιη δίκη με το να περιορίζουν την ανεξάρτητη και αμερόληπτη κρίση του δικαστή.

Ο Ευρωπαίος νομοθέτης θα πρέπει να αναγνωρίσει τις διαφορετικές ταχύτητες ψηφιοποίησης ανά Κράτος Μέλος που επηρεάζουν τους στόχους της ΕΕ για την εξ ορισμού ψηφιοποίηση και τη διαλειτουργικότητα συστημάτων στο δικαστικό τομέα των Κρατών Μελών [2]. Αν και τα περισσότερα Κράτη Μέλη έχουν ξεκινήσει τις διαδικασίες ψηφιοποίησης βάσει συστημάτων ΤΝ, κυρίως για την ψευδωνυμοποίηση δικαστικών αποφάσεων [3], ωστόσο βρίσκονται σε αρκετά πρώιμο στάδιο καθώς σε πολλές περιπτώσεις δεν υπάρχουν αρκετά μηχανογραφημένα δεδομένα, π.χ. δικαστικές αποφάσεις, που μπορεί να επεξεργαστεί ένα σύστημα ΤΝ κατά την εκπαίδευση του. Επομένως, δεν επαρκεί η σαφής νομοθέτηση της επιτρεπτούς χρήσης συστημάτων ΤΝ για τη διασφάλιση της αποτελεσματικής και επιτυχούς εφαρμογής συστημάτων ΤΝ στα εθνικά δικαστήρια.

Η ΕΕ και οι εθνικοί φορείς, όπως το Υπουργείο Δικαιοσύνης, πρέπει να παρέχουν μεγαλύτερη οικονομική στήριξη αλλά και καθοδήγηση στα εθνικά δικαστήρια, π.χ. μέσω της εκπαίδευση και ενημέρωσης των δικαστών σχετικά με την χρήση συστημάτων ΤΝ. Σε αυτήν την προσπάθεια, είναι πολύ σημαντικό η εφαρμογή των συστημάτων ΤΝ στη διοίκηση των δικαστηρίων να γίνεται κατά εναρμονισμένο τρόπο, τουλάχιστον σε εθνικό επίπεδο, ώστε όλοι οι πολίτες να επωφελούνται ισότιμα και αδιακρίτως από τη θετική συμβολή των συστημάτων στην αποτελεσματικότητα και ποιότητα της δικαιοσύνης.

* Η Καλλιόπη Τερζίδου είναι Υποψήφια Διδάκτωρ της Νομικής Σχολής του Πανεπιστημίου του Λουξεμβούργου. Η έρευνα της υποστηρίζεται από το Fonds National de la Recherche (PRIDE 19/14268506).

[2] Council of the EU, European e-Justice Strategy 2024-2028 – Approval, 15509/23, 17 November 2023,

Παραχωρούμε την αιγίδα μας στο 3RD IN-HOUSE LAWYERS FORUM

Για ακόμη μία χρονιά, η Homo Digitalis έχει τη μεγάλη τιμή και χαρά να παραχωρεί την αιγίδα της στο 3RD IN-HOUSE LAWYERS FORUM, που διοργάνωσε η CLEON Conferences & Communications στις 29/1 στο Divani Caravel Hotel στην Αθήνα!

Μέσα στον κύκλο ομιλητών, είχαμε την υπερηφάνεια να φιλοξενούνται και μέλη μας, υπό την επαγγελματική τους φυσικά ιδιότητα, συμπεριλαμβανομένου του Γραμματέα του Δ.Σ. μας, Στέφανου Βιτωράτου!

Ευχαριστούμε τους διοργανωτές για τη συνεργασία, μεταξύ άλλων τον κ Γρηγόριο Λεωνίδη. Μπορείτε να μάθετε περισσότερα για το συνέδριο εδώ.

Ο οργάνωσή μας παραχωρεί εθελοντικά την αιγίδα της σε επιλεγμένες δράσεις, πρωτοβουλίες και λοιπές εκδηλώσεις, στοχεύοντας στην ενεργή υποστήριξη και την ανάδειξη των πρωτοβουλιών που σχετίζονται με την προάσπιση των ψηφιακών δικαιωμάτων. Εάν έχετε σχετικούς σκοπούς και σας ενδιαφέρει κάποια αφιλοκερδή συνεργασία επικοινωνήστε μαζί μας στο info@homodigitalis.gr

H Homo Digitalis μίλησε στο World Economic Forum στο Νταβός της Γενεύης

Κάνοντας Περισσότερα με Λιγότερα στην Ημέρα της Γενεύης στο Νταβός: Πώς να ανταποκριθούμε στις αυξανόμενες ανάγκες σε περίοδο οικονομικής αβεβαιότητας;

Εξετάσαμε αυτή την κρίσιμη ερώτηση τη Δευτέρα 21/1 κατά τη διάρκεια μιας συζήτησης σε πάνελ που πραγματοποιήθηκε στο πλαίσιο της Ημέρας της Γενεύης στο House of Switzerland στο Νταβός. Ήμασταν περήφανοι που συμμετείχαμε σε αυτή την εκδήλωση που συνδιοργανώθηκε από το Swiss Financial Innovation Desk και την Μόνιμη Αντιπροσωπεία της Ελβετίας στα Ηνωμένα Έθνη στη Γενεύη, κατά τη διάρκεια του Παγκόσμιου Οικονομικού Φόρουμ 2025 (World Economic Forum – 2025).

Αυτή η ενδιαφέρουσα συζήτηση εξερεύνησε αναδυόμενες τεχνολογίες όπως η Τεχνητή Νοημοσύνη (AI), το Blockchain και τα Ψηφιακά Νομίσματα Κεντρικών Τραπεζών (CBDCs), σε συνδυασμό με καινοτόμες δημοσιονομικές πολιτικές, ως εργαλεία για την αντιμετώπιση των κρίσιμων προκλήσεων του αύριο. Η πρόεδρός μας, Ελπίδα Βαμβάκα, εκπροσώπησε την ομάδα μας, μιλώντας για τις σημαντικές δράσεις και νίκες μας στον τομέα της ΤΝ στην Ελλάδα, καθώς και για το έργο NGI – The Next Generation Internet NGI TALER, το οποίο δημιουργεί ένα νέο, προστατευτικό της ιδιωτικότητας, ασφαλές ηλεκτρονικό σύστημα πληρωμών βασισμένο σε ανοικτά πρότυπα, ελεύθερο λογισμικό και προηγμένη κρυπτογραφία.

Ένα εγκάρδιο ευχαριστώ στους διοργανωτές και στους διακεκριμένους συμμετέχοντες στο πάνελ: Christoph König, Αναπληρωτής Γενικός Γραμματέας, Γραμματεία Διεθνούς Χρηματοδότησης SIF, Kelly T. Clements, Ύπατη Αρμοστής στον UNHCR, τον Οργανισμό Ηνωμένων Εθνών για τους Πρόσφυγες, Daniel Eidan, Σύμβουλος & Αρχιτέκτονας Λύσεων στην Τράπεζα Διεθνών Διακανονισμών – BIS Innovation Hub.

Η καταπληκτική Eva Selamlar-Leuthold, Επικεφαλής του Swiss Financial Innovation Desk (FIND), συντόνισε αυτή τη δυναμική και εύστοχη συζήτηση με μοναδικό τρόπο.

Θα θέλαμε επίσης να εκφράσουμε τις θερμότερες ευχαριστίες μας στον Jonas Pasquier, Επικεφαλής Παγκόσμιων Υποθέσεων στην Μόνιμη Αντιπροσωπεία της Ελβετίας στα Ηνωμένα Έθνη στη Γενεύη, σε όλη του την ομάδα, στην Αντιπροσωπεία, καθώς και στην ομάδα της Presence Switzerland στο House of Switzerland, για την επιτυχία αυτής της εκδήλωσης.

Θέλετε να μάθετε περισσότερα από αυτή τη συζήτηση; Μείνετε συντονισμένοι για μια επερχόμενη δημοσίευση από το Swiss Financial Innovation Desk, εδώ:

Η Πρόεδρος της Homo Digitalis, Ελπίδα Βαμβακά, στο WEF του DAVOS: Μια Παγκόσμια Αναγνώριση

Με μεγάλη μας χαρά ανακοινώνουμε ότι η Homo Digitalis προσκλήθηκε να συμμετάσχει σε μια εξέχουσα συζήτηση πάνελ στο DAVOS, που διοργανώνεται από το Swiss Financial Innovation Desk (FIND) της Γραμματείας Διεθνών Οικονομικών Υποθέσεων της Ελβετίας και τη Μόνιμη Αντιπροσωπεία της Ελβετίας στον ΟΗΕ στη Γενεύη στο πλαίσιο του World Economic Forum (WEF).

Λεπτομέρειες Εκδήλωσης:

Θέμα: Κάνουμε Περισσότερα με Λιγότερα: Πώς να Αντιμετωπίσουμε τις Αυξανόμενες Ανάγκες σε Περιόδους Οικονομικής Αβεβαιότητας

Ημερομηνία & Ώρα: Τρίτη, 21 Ιανουαρίου 2025 | 17:00-18:30

Τοποθεσία: Crystal Lounge, Davos

Η Πρόεδρός μας, Ελπίδα Βαμβάκα, θα συμμετάσχει σε μια διακεκριμένη ομάδα διεθνών ηγετών για να συζητήσουν πώς καινοτόμες τεχνολογίες, όπως η Τεχνητή Νοημοσύνη (AI), το Blockchain και τα Ψηφιακά Νομίσματα Κεντρικών Τραπεζών (CBDCs), μπορούν να ενδυναμώσουν κυβερνήσεις και οργανισμούς να αντιμετωπίσουν τις παγκόσμιες προκλήσεις σε περιόδους οικονομικής αβεβαιότητας. Συγκεκριμένα, στο πάνελ ομιλητών μαζί με την Πρόεδρό μας, Ελπίδα Βαμβακά, περιλαμβάνονται οι:

– Christoph König, Deputy State Secretary, State Secretariat for International Finance

– Kelly Clements, United Nations Deputy High Commissioner for Refugees

– Morten Bech, Centre Head Switzerland, Bank for International Settlements (BIS) Innovation Hub

Τη διαχείριση του πάνελ έχει αναλάβει η Eva Selamlar, Head of Swiss Financial Innovation Desk (FIND).

Καθώς γιορτάζουμε αυτή την παγκόσμια αναγνώριση, τονίζουμε την ανάγκη για ανάλογη εμπιστοσύνη και αναγνώριση και σε εθνικό επίπεδο στην Ελλάδα. Η ενίσχυση της δέσμευσης της Ελλάδας για τεχνολογική καινοτομία και διορατική πολιτική μπορεί να ανοίξει το δρόμο για ουσιαστική αλλαγή.

Μπορείτε να μάθετε περισσότερα για την εκδήλωση εδώ.

Ας κάνουμε τον προσανατολισμό της καινοτομία προς την προστασία και προάσπιση των Δικαιωμάτων του Ανθρώπου το θεμέλιο για ένα φωτεινότερο και ανθεκτικό μέλλον – για την Ελλάδα και τον κόσμο.

Δημοσιεύουμε κοινή δήλωση για τις αναμενόμενες Κατευθυντήριες Γραμμές της Ευρωπαϊκής Επιτροπής για τις Απαγορευμένες Πρακτικές του AI Act

Στις 11 Δεκεμβρίου 2024, η Ευρωπαϊκή Επιτροπή ολοκλήρωσε τη δημόσια διαβούλευσή της για την ερμηνεία του ορισμού ενός συστήματος Τεχνητής Νοημοσύνης και για τις απαγορευμένες πρακτικές τεχνητής νοημοσύνης, σύμφωνα με τις διατάξεις του Κανονισμού 2024/1689 (AI Act). H Homo Digitalis είχε συμμετάσχει στη σχετική διαδικασία.

Στο πλαίσιο της έκδοσης των αναμενόμενων κατευθυντηρίων γραμμών της Επιτροπής, παραμένουν ανησυχίες για ενδεχόμενα κενά που θα μπορούσαν να θέσουν σε κίνδυνο τα θεμελιώδη δικαιώματα. Γι’ αυτόν τον λόγο και από κοινού με περισσότερες από 25 οργανώσεις της Κοινωνίας των Πολιτών, ακαδημαϊκούς και άλλους ειδικούς, εκδίδουμε σήμερα μία δήλωση ζητώντας από την Υπηρεσία Τεχνητής Νοημοσύνης (AI Office) και την Ευρωπαϊκή Επιτροπή να εξασφαλίσουν συγκεκριμένα αιτήματα.

Μπορείτε να διαβάσετε τη κοινή μας δήλωση εδώ.

!

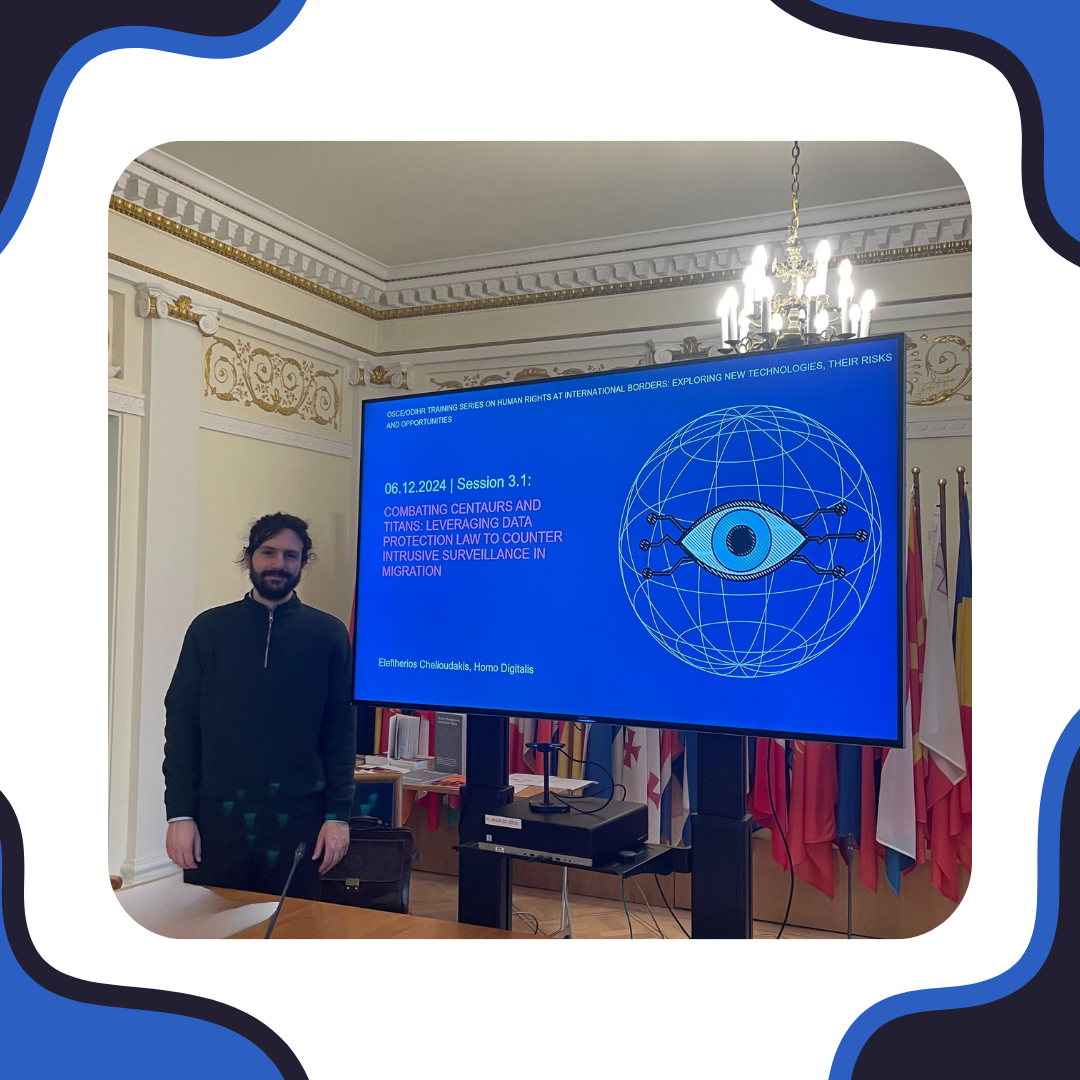

O Λευτέρης Χελιουδάκης της Homo Digitalis Εκπαιδευτής σε 3η Εκπαίδευση του OSCE ODIHR για προσωπικά δεδομένα & προστασία συνόρων

Από τις 4 έως τις 6 Δεκεμβρίου, ο Λευτέρης Χελιουδάκης, συνιδρυτής και Εκτελεστικός μας Διευθυντής συμμετείχε ως εκπαιδευτής στην τρίτη Εκπαίδευση που διοργάνωσε ο διεθνής οργανισμός OSCE και συγκεκριμένα το Γραφείο του για τους Δημοκρατικούς Θεσμούς και τα Ανθρώπινα Δικαιώματα (OSCE Office for Democratic Institutions and Human Rights (ODIHR)) στη Βαρσοβία διερευνώντας τη χρήση νέων τεχνολογιών στα διεθνή σύνορα, καθώς και τους κινδύνους αλλά και τις ευκαιρίες που απορρέουν σχετικά με τα Δικαιώματα του Ανθρώπου.

Στις 4 παρουσιάσεις μας, εστιάσαμε στις τεχνολογίες που χρησιμοποιούνται στα σύνορα, τα Δικαιώματα του Ανθρώπου που επηρεάζονται από τις εν λόγω χρήσεις, τις διατάξεις του GDPR αλλά και της Οδηγίας 2016/680 LED, καθώς και τη σημαντική απόφαση της ΑΠΔΠΧ για τα συστήματα “ΚΕΝΤΑΥΡΟΣ” και “ΥΠΕΡΙΩΝ”.

Ευχαριστούμε θερμά τα άτομα που συμμετείχαν στην εκπαίδευση για τη δυναμική τους παρουσία, την ομάδα των εξαιρετικών υπολοίπων εκπαιδευτών Nikola Kovačević, Djordje Alempijevic και Arancha Garcia del Soto για τις γνώσεις και την εμπειρία τους και την ομάδα των διοργανωτών για την άψογη διοργάνωση και τη συμβολή τους, Lola Girard, Veronica Grazzi! Eίναι μεγάλη μας τιμή να συμμετέχουμε!

Μπορείτε να μάθετε περισσότερα εδώ.

Ο Στέφανος Βιτωράτος της Homo Digitalis, παίρνει συνέντευξη από τον Μιχάλη Κρητικό στο podcast των Digital Dialogues για το DGSG!

Υπάρχει φόβος ή αισιοδοξία για την επιρροή της Τεχνητής Νοημοσύνης στην ζωή μας;

Στο 7ο επεισόδιο του podcast των Digital Dialogues, ο Μιχάλης Κρητικός, Eιδικός Δικαίου Τεχνητής Νοημοσύνης στην Ευρωπαϊκή Επιτροπή και στο Hellenic Foundation for European & Foreign Policy, μιλάει στον συντονιστή του Digital World Summit Greece και Συνιδρυτή της Homo Digitalis Stefanos Vitoratos, για την διακυβέρνηση της Τεχνητής Νοημοσύνης, την σχέση της με τα ανθρώπινα δικαιώματα και τις ευκαιρίες που φέρνει στην Ελλάδα και την Ευρώπη.

Παράλληλα, αναλύει τους παράγοντες που διαμόρφωσαν το «καλοκαίρι της Τεχνητής Νοημοσύνης», την εναρμόνιση της Πράσινης Μετάβασης με την ανάπτυξη της Τεχνητής Νοημοσύνης, καθώς και την εφαρμογή της Πράξης για την Τεχνητή Νοημοσύνη στην Ελλάδα.

Είναι εξαιρετικά μεγάλη τιμή για τη Homo Digitalis να αποτελούμε για ακόμη μία χρονιά συνεργάτες του Digital World Summit Greece!

Άκουσε ολόκληρη τη συζήτηση στο Spotify του Digital World Summit Greece εδώ.