Σε διαρκή ετοιμότητα. Φωνή, ιδιωτικότητα και ελευθερία επιλογής

Γράφει η Αλεξάνδρα Μελισσηνού*

Μια υπόθεση εργασίας

Ας φανταστούμε το εξής: βρισκόμαστε στον καναπέ, έτοιμοι να ξεκινήσουμε την αγαπημένη μας σειρά. Τα φώτα είναι λίγο πιο έντονα απ’ όσο θα θέλαμε, αλλά κανείς δεν σηκώνεται. Αντί γι’ αυτό, απευθυνόμαστε σε μια συσκευή στο σαλόνι και μέσα σε λίγα δευτερόλεπτα ο φωτισμός προσαρμόζεται. Η τεχνολογία λειτουργεί αθόρυβα, αποτελεσματικά, σχεδόν μαγικά. Για την Αλεξάνδρα που μιλά, η εμπειρία μοιάζει απλή. Για τη «Alexa» που ακούει, ξεκινά μια πιο σύνθετη διαδικασία στο παρασκήνιο.

Αυτή είναι η γοητεία των φωνητικών ψηφιακών βοηθών: υπόσχονται ευκολία, ταχύτητα και λιγότερη προσπάθεια. Μαζί με την άνεση, όμως, αναδύεται ένα ερώτημα που σπάνια τίθεται με την ίδια ευκολία. Τι σημαίνει αυτή η διευκόλυνση για την ιδιωτικότητα και τον έλεγχο των προσωπικών μας δεδομένων;

Σε αντίθεση με άλλες ψηφιακές υπηρεσίες, οι φωνητικοί βοηθοί δεν περιορίζονται σε μια οθόνη που ανοίγουμε και κλείνουμε. Βρίσκονται μόνιμα μέσα στο σπίτι, στον πιο προσωπικό μας χώρο και βασίζονται στη φωνή μας για να λειτουργήσουν. Δεν αλληλοεπιδρούμε απλώς μαζί τους, τους επιτρέπουμε να βρίσκονται διαρκώς «σε ετοιμότητα», σε ένα περιβάλλον όπου μιλάμε πιο χαλαρά και αυθόρμητα, συχνά χωρίς να συνειδητοποιούμε ότι η ομιλία μας μπορεί να μετατραπεί σε δεδομένο.

Η συζήτηση για την ιδιωτικότητα συχνά απλοποιείται υπερβολικά και καταλήγει στο επιχείρημα ότι «όποιος δεν έχει κάτι να κρύψει, δεν έχει λόγο να ανησυχεί». Στην πραγματικότητα, όμως, η ιδιωτικότητα δεν αφορά μόνο το αν μας βλέπουν ή μας ακούν. Αφορά τον χώρο μέσα στον οποίο μπορούμε να υπάρχουμε χωρίς αδικαιολόγητη παρέμβαση, να επικοινωνούμε, να κάνουμε επιλογές και, εξίσου σημαντικό, να αλλάζουμε γνώμη.

Γι’ αυτό και η ιδιωτικότητα συνδέεται στενά με την αυτονομία και την ελευθερία επιλογής. Σε ακρόαση στο Κογκρέσο, ο Mark Zuckerberg απέφυγε να απαντήσει στο ερώτημα σε ποιο ξενοδοχείο είχε διανυκτερεύσει το προηγούμενο βράδυ. Η αμηχανία αυτή δεν υποδηλώνει κάτι ύποπτο, αλλά την αναγνώριση ότι ορισμένες πληροφορίες ανήκουν στη σφαίρα του ιδιωτικού.

Το παρόν άρθρο εστιάζει στους φωνητικούς βοηθούς, όπου η συλλογή και επεξεργασία δεδομένων πραγματοποιείται με τη συγκατάθεση του χρήστη, αναδεικνύοντας ωστόσο ότι ο τρόπος σχεδιασμού των συστημάτων και η περαιτέρω αξιοποίηση των δεδομένων μπορούν να επηρεάσουν την ιδιωτικότητα, ακόμη, και χωρίς ευθεία παραβίαση του νόμου. Στο πλαίσιο αυτό, οι φωνητικοί βοηθοί αποτελούν χαρακτηριστικό παράδειγμα της σύγχρονης «ανταλλαγής» μεταξύ ευκολίας και ελέγχου, καθώς η χρήση τους εγείρει συναφή ζητήματα στην Ευρωπαϊκή Ένωση, όχι ως έκφραση τεχνοφοβίας ή αντίθεσης στην καινοτομία, αλλά ως αφορμή για κριτική σκέψη γύρω από τον τρόπο με τον οποίο η τεχνολογία σχεδιάζεται, ενσωματώνεται και ρυθμίζεται.

Τι είναι οι φωνητικοί βοηθοί και γιατί μας αφορούν

Οι φωνητικοί βοηθοί είναι ψηφιακές υπηρεσίες που μας επιτρέπουν να αλληλεπιδρούμε με την τεχνολογία χρησιμοποιώντας μόνο τη φωνή μας. Με μια απλή εντολή μπορούμε να χαμηλώσουμε τα φώτα, να ακούσουμε ειδήσεις ή να ρυθμίσουμε τη θερμοκρασία, χωρίς να αγγίξουμε καμία συσκευή. Στην καθημερινότητα συχνά ταυτίζονται με το αντικείμενο στο οποίο «ζουν», όπως ένα έξυπνο ηχείο ή ένα κινητό τηλέφωνο. Στην πραγματικότητα, όμως, πρόκειται για λογισμικό που λειτουργεί στο παρασκήνιο και συνδέει τη φωνή του χρήστη με ένα ευρύτερο ψηφιακό οικοσύστημα υπηρεσιών. Στην Ευρώπη, οι πιο διαδεδομένοι είναι η Alexa της Amazon, το Google Assistant και η Siri της Apple.

Παρότι ενσωματώνονται σε προσωπικές συσκευές, οι φωνητικοί βοηθοί δεν λειτουργούν ως απομονωμένα συστήματα. Στην πράξη, δεν υπάρχει «η Alexa του σπιτιού μου». Πίσω από κάθε συσκευή βρίσκεται ένα ενιαίο σύστημα στο cloud, ένα κοινό «μυαλό», που τροφοδοτείται από τις αλληλεπιδράσεις εκατομμυρίων χρηστών. Κάθε φωνητική εντολή δεν εξυπηρετεί μόνο τη συγκεκριμένη στιγμή, αλλά συμβάλλει στη συνολική εκμάθηση και εξέλιξη του βοηθού.

Για να ανταποκριθεί σε μια εντολή, ο φωνητικός βοηθός βρίσκεται σε διαρκή ετοιμότητα για τον εντοπισμό της λέξης ενεργοποίησης (wake word). Κατ’ αρχήν, η αποστολή και επεξεργασία φωνητικών δεδομένων ξεκινά μετά την ενεργοποίηση αυτή. Ωστόσο, δεν αποκλείονται ακούσιες ενεργοποιήσεις, ιδίως σε περιβάλλοντα με θόρυβο ή πολλούς ομιλητές, με αποτέλεσμα την καταγραφή ομιλιών που δεν προορίζονταν για τη συσκευή.

Για να προσφέρουν φυσική και εξατομικευμένη εμπειρία, οι φωνητικοί βοηθοί δεν επεξεργάζονται μόνο μεμονωμένες εντολές. Διατηρούν και αναλύουν προηγούμενες αλληλεπιδράσεις, ώστε να προσαρμόζουν τη συμπεριφορά τους στον χρήστη. Εδώ αναδεικνύεται μια κρίσιμη διάκριση. Άλλο η απολύτως αναγκαία επεξεργασία για την εκτέλεση μιας εντολής και άλλο η περαιτέρω αξιοποίηση των δεδομένων για σκοπούς όπως η εκπαίδευση αλγορίθμων, η ανάλυση χρήσης ή η κατάρτιση προφίλ.

Το ζήτημα γίνεται ακόμη πιο σύνθετο επειδή οι φωνητικοί βοηθοί τοποθετούνται σε χώρους της οικίας που χρησιμοποιούνται από περισσότερα άτομα. Εκεί ενδέχεται να βρίσκονται σύντροφοι, παιδιά ή επισκέπτες, οι οποίοι δεν απευθύνονται στη συσκευή, αλλά, απλώς μιλούν μεταξύ τους ή κινούνται στον χώρο, χωρίς να έχουν επιλέξει οι ίδιοι τη χρήση της, ούτε να είναι ενημερωμένοι για τον τρόπο λειτουργίας της. Έτσι, η τεχνολογία δεν αφορά μόνο τον κύριο χρήστη, αλλά, εκτείνεται σε ένα ευρύτερο κοινωνικό περιβάλλον γύρω από τη συσκευή.

Οι διακρίσεις αυτές δεν είναι θεωρητικές. Το 2019 αποκαλύφθηκε ότι αποσπάσματα ηχογραφήσεων από φωνητικούς βοηθούς μεγάλων τεχνολογικών εταιρειών, όπως η Amazon και η Google, αξιολογούνταν από ανθρώπους για την εκπαίδευση των συστημάτων αναγνώρισης ομιλίας. Οι ηχογραφήσεις δεν περιορίζονταν σε συνειδητές φωνητικές εντολές, αλλά περιλάμβαναν και ακούσιες ενεργοποιήσεις, καταγράφοντας στιγμές της καθημερινής ζωής στο σπίτι, όπως μια συζήτηση, ένα γέλιο ή έναν διαπληκτισμό. Πολλοί χρήστες αγνοούσαν ότι τα δεδομένα αυτά δεν υφίσταντο αποκλειστικά αυτοματοποιημένη επεξεργασία.

Το ευρωπαϊκό νομικό πλαίσιο

Στο ευρωπαϊκό δίκαιο, η λειτουργία των φωνητικών βοηθών διέπεται από τον Γενικό Κανονισμό Προστασίας Δεδομένων (ΓΚΠΔ), ο οποίος επιτρέπει υπό προϋποθέσεις τη συλλογή και επεξεργασία προσωπικών δεδομένων, όπως η φωνή. Παράλληλα, εφαρμόζεται η Οδηγία e-Privacy, η οποία ρυθμίζει την πρόσβαση στον τερματικό εξοπλισμό του χρήστη, δηλαδή, στο μικρόφωνο της συσκευής.

Σύμφωνα με την Οδηγία e-Privacy, η πρόσβαση στο μικρόφωνο επιτρέπεται, κατά κανόνα, μόνο εφόσον ο χρήστης έχει δώσει εκ των προτέρων τη συγκατάθεσή του. Εξαίρεση προβλέπεται μόνο όταν η πρόσβαση είναι απολύτως αναγκαία για την παροχή μιας υπηρεσίας που ο ίδιος ζήτησε ρητά. Έτσι, η καταγραφή φωνής που απαιτείται για την εκτέλεση μιας συγκεκριμένης εντολής μπορεί να θεωρηθεί θεμιτή. Δεν ισχύει όμως το ίδιο για ακούσιες ενεργοποιήσεις ή για την καταγραφή φωνών τρίτων που δεν έχουν συναινέσει.

Ακόμη κι όταν υπάρχει συγκατάθεση ή άλλη νόμιμη βάση, η επεξεργασία δεν είναι άνευ όρων. Ο ΓΚΠΔ θέτει ποιοτικά όρια στη συλλογή και επεξεργασία προσωπικών δεδομένων μέσω των θεμελιωδών αρχών του άρθρου 5, ιδίως του περιορισμού του σκοπού συλλογής των προσωπικών δεδομένων, της απαγόρευσης περαιτέρω επεξεργασίας αυτών και της ελαχιστοποίησης των δεδομένων. Συγκεκριμένα, τα δεδομένα πρέπει να συλλέγονται για σαφείς σκοπούς, γνωστούς στον χρήστη εκ των προτέρων και να περιορίζονται σε όσα είναι πράγματι κατάλληλα, συναφή και αναγκαία για τους σκοπούς αυτούς. Η συλλογή πληροφοριών για μελλοντική χρήση ή επειδή η τεχνολογία το επιτρέπει δεν συμβαδίζει με το πνεύμα του ΓΚΠΔ.

Στην περίπτωση των φωνητικών βοηθών, η εφαρμογή των αρχών αυτών είναι ιδιαίτερα απαιτητική. Η συνεχής εκμάθηση των συστημάτων μπορεί να οδηγήσει στη δημιουργία νέων χρήσεων των δεδομένων, όπως η εξαγωγή συμπερασμάτων για συνήθειες ή συναισθηματικές καταστάσεις. Έτσι, το όριο ανάμεσα στην παροχή της υπηρεσίας και τη διευρυμένη αξιοποίηση των δεδομένων γίνεται ολοένα και πιο δυσδιάκριτο.

Στο ίδιο πλαίσιο εντάσσεται και το άρθρο 22 του ΓΚΠΔ, το οποίο ρυθμίζει την αυτοματοποιημένη λήψη αποφάσεων και την κατάρτιση προφίλ. Αν και η διάταξη επιτρέπει τέτοιες πρακτικές, μεταξύ άλλων όταν στηρίζονται σε ρητή συγκατάθεση, η συγκατάθεση αυτή δεν αναιρεί την υποχρέωση τήρησης των θεμελιωδών αρχών, ούτε απαλλάσσει τον υπεύθυνο επεξεργασίας από την ανάγκη ουσιαστικών εγγυήσεων και διαφάνειας.

Τέλος, αξίζει να σημειώσουμε ότι η προστασία της ιδιωτικότητας δεν αρχίζει τη στιγμή που ο χρήστης μιλά στη συσκευή, αλλά πολύ νωρίτερα, στον τρόπο με τον οποίο η τεχνολογία έχει σχεδιαστεί. Ο ΓΚΠΔ απαιτεί η προστασία των δεδομένων να ενσωματώνεται εξαρχής στη λειτουργία της υπηρεσίας και όχι να ενεργοποιείται εκ των υστέρων μέσω ρυθμίσεων. Στην πράξη, αυτό σημαίνει ότι δεν αρκεί ο χρήστης να μπορεί κάποτε να διαγράψει ηχογραφήσεις. Σημασία έχει αν η ίδια η συσκευή έχει σχεδιαστεί ώστε να συλλέγει όσο το δυνατόν λιγότερα δεδομένα, για όσο το δυνατόν μικρότερο χρονικό διάστημα και μόνο για πολύ συγκεκριμένους σκοπούς. Όταν η συνεχής συλλογή αποτελεί τον κανόνα, η ιδιωτικότητα παύει να είναι προεπιλογή και γίνεται εξαίρεση.

Λίγες σκέψεις ακόμα

Το ερώτημα, τελικά, δεν είναι αν οι φωνητικοί βοηθοί είναι «καλοί» ή «κακοί». Είναι τεχνολογίες που εγκαθίστανται στον πιο προσωπικό μας χώρο και, ακριβώς γι’ αυτό, επηρεάζουν τον τρόπο με τον οποίο κινούμαστε, μιλάμε και επιλέγουμε, συχνά χωρίς να το αντιλαμβανόμαστε.

Συχνά ακούγεται το επιχείρημα: και τι πειράζει; Αν η συσκευή καταλαβαίνει καλύτερα πώς νιώθουμε, αν μας μιλά πιο «ανθρώπινα» ή μας προτείνει πράγματα που μας ταιριάζουν, δεν πρόκειται απλώς για μια πιο άνετη εμπειρία;

Το ζήτημα δεν είναι η άνεση αυτή καθαυτή. Το ζήτημα είναι πότε η προσαρμογή μετατρέπεται σε καθοδήγηση. Πότε η τεχνολογία παύει να απαντά σε ό,τι ζητάμε και αρχίζει, διακριτικά, να διαμορφώνει τι θα ζητήσουμε στη συνέχεια. Όχι με επιβολή, αλλά με μικρές, συνεχείς παρεμβάσεις που δύσκολα γίνονται αντιληπτές.

Σε αυτό το σημείο, η ιδιωτικότητα δεν αφορά απλώς το αν καταγράφεται η φωνή μας. Αφορά το αν διατηρούμε τον έλεγχο των επιλογών μας. Το αν μπορούμε να σκεφτούμε, να μιλήσουμε και να αλλάξουμε γνώμη χωρίς να εντασσόμαστε σιωπηλά σε προφίλ που λειτουργούν στο παρασκήνιο.

Το ευρωπαϊκό νομικό πλαίσιο προσφέρει σημαντικές εγγυήσεις. Η ουσιαστική του αξία, όμως, δεν εξαντλείται στη συγκατάθεση. Κρίνεται στο αν η προστασία της ιδιωτικότητας έχει προβλεφθεί εξαρχής στον σχεδιασμό της τεχνολογίας ή αν μεταφέρεται, εκ των υστέρων, στον χρήστη ως βάρος διαχείρισης.

Σε μια εποχή όπου η τεχνολογία υπόσχεται να μας κάνει τη ζωή πιο εύκολη, το πραγματικό διακύβευμα δεν είναι αν μας ακούει μια συσκευή. Είναι αν παραμένουμε ελεύθεροι να επιλέγουμε τον τρόπο με τον οποίο ζούμε, μιλάμε και υπάρχουμε ακόμη και όταν απλώς καθόμαστε στον καναπέ και ζητάμε να χαμηλώσουν τα φώτα.

*Η Αλεξάνδρα Μελισσηνού είναι νομικός με ειδίκευση στο Δίκαιο Διανοητικής Ιδιοκτησίας. Είναι κάτοχος μεταπτυχιακού τίτλου (LLM in Intellectual Property) από το Queen Mary University of London και τα επαγγελματικά της ενδιαφέροντα εστιάζουν στα άυλα αγαθά και τα ψηφιακά δικαιώματα.

Αόρατες προκαταλήψεις: Η περίπτωση της τεχνητής νοημοσύνης και της έμφυλης διάστασης

Γράφει η Θεοδώρα Τσούτσα*

Η χρήση της τεχνητής νοημοσύνης όπως γίνεται καθημερινά ολοένα και πιο αντιληπτό γίνεται αναπόσπαστο κομμάτι σε πάρα πολλούς τομείς, όπως οι επιχειρήσεις, η εκπαίδευση, η υγεία κτλ. Παρόλα αυτά δεν πρέπει να ξεχνάει κανείς ότι και η τεχνητή νοημοσύνη (ΤΝ) είναι κατασκευασμένη και εκπαιδευμένη από ανθρώπους, που μπορεί και οι ίδιοι να κουβαλάνε προκαταλήψεις, οι οποίες πολλές φορές με ακούσιο τρόπο και αφιλτράριστα περνάνε στους αλγόριθμους.

Αυτή η συνειδητοποίηση ανοίγει χώρο για περισσότερες σκέψεις από ποτέ, σχετικά με το τι αντίκτυπο μπορεί να έχει η ανθρώπινη αντίληψη πάνω στον αλγόριθμο και υπογραμμίζει την σημασία μιας ολιστικής και με διαφάνεια προσέγγισης όταν εκπαιδεύουμε εργαλεία. Πιο συγκεκριμένα εάν δεν υπάρχει μια ολοκληρωμένη εποπτεία μπορεί να επηρεάσει μεροληπτικά και να διαιωνίσει προκαταλήψεις σε βάρος κάποιων συγκεκριμένων, συνήθως πιο ευάλωτων ή/και περιθωριοποιημένων κοινοτήτων. Το συγκεκριμένο άρθρο θα εστιάσει στην διάσταση του φύλου, η οποία πολλές φορές δεν λαμβάνεται υπόψιν σε βάθος, όταν πρόκειται για την δημιουργία ενός αλγόριθμου.

Μελέτες περίπτωσης

1.Ένα χαρακτηριστικό πρώτο παράδειγμα αποτελεί η προσπάθεια της Amazon να αναπτύξει έναν αυτοματοποιημένο αλγόριθμο πρόσληψης. Αυτή ήταν μια αποτυχημένη απόπειρα η οποία δεν διήρκησε αρκετό καιρό καθώς τα δεδομένα εκπαίδευσης αποδείχθηκαν άκρως προκατειλημμένα και σεξιστικά. Πιο συγκεκριμένα ο αλγόριθμος επειδή είχε εκπαιδευτεί με βάση προηγούμενα βιογραφικά υψηλής αξιολόγησης, τα οποία προέρχονταν κυρίως από άντρες, «έμαθε» να ευνοεί άντρες υποψηφίους, αναπαράγοντας ήδη υπάρχουσες ανισορροπίες στον χώρο της εργασίας, κάτι που οδήγησε στην εγκατάλειψη του έργου. Εδώ παρατηρούμε πως η προκατάληψη απέναντι στο φύλο μέσω συστημάτων ΤΝ μπορεί να είναι δύσκολο να γίνει ευδιάκριτη με αποτέλεσμα τα άτομα να αδικούνται, και να επηρεάζονται οι ευκαιρίες και οι δυνατότητες που έχουν, μέσω αυτής της αναπαραγωγής των στερεοτύπων.

Ακόμα μια τέτοια περίπτωση όπως αυτή της Amazon αντικατοπτρίζει μια διαχρονική προβληματική, αυτή της ιστορικής ανδροκρατίας στη βιομηχανία και τις επιχειρήσεις και αναδεικνύει πόσο εύκολα κάτι τέτοιο μπορεί να ενσωματωθεί στους αλγόριθμους. Αποτελεί χαρακτηριστικό παράδειγμα της διαιώνισης του κοινωνικού φαινομένου της «γυάλινης οροφής» , των αόρατων δηλαδή εμποδίων που περιορίζουν τις επαγγελματικές προοπτικές των γυναικών.

2.Μία ακόμα περίπτωση στον τομέα του ελέγχου της μετανάστευσης είναι το πιλοτικό σύστημα, αποκλειστικά ερευνητικού χαρακτήρα, iBorderCtrl , ένα εργαλείο ανίχνευσης ψεύδους και αναγνώρισης προσώπου για την είσοδο ταξιδιωτών στην ΕΕ. Ένα ακόμα σύστημα που διακόπηκε, προκαλώντας έντονη ανησυχία σχετικά με την προστασία των ανθρωπίνων δικαιωμάτων. Ιδιαίτερα, έγειρε ανησυχίες σχετικά με προκαταλήψεις απέναντι στο φύλο αλλά και στην φυλή μέσω της ΤΝ , οι οποίες θα μπορούσαν να οδηγήσουν σε διακριτική μεταχείριση των ταξιδιωτών. Συγκεκριμένα, οι αλγόριθμοι θα μπορούσαν να παρερμηνεύσουν τις εκφράσεις του προσώπου των γυναικών, αντανακλώντας κοινωνικές προκαταλήψεις που αντιλαμβάνονται τις γυναίκες ως πιο συναισθηματικές ή λιγότερο αξιόπιστες, αυξάνοντας έτσι την πιθανότητα ψευδώς θετικών ανιχνεύσεων μεταξύ των γυναικών ταξιδιωτών. Ουσιαστικά εδώ η έλλειψη ποικιλομορφίας στα δεδομένα εκπαίδευσης έκανε το iΒorderctrl να ενσωματώνει έμφυλες και φυλετικές προκαταλήψεις, οδηγώντας σε ανακριβείς ή μεροληπτικές αξιολογήσεις απέναντι σε μη Ευρωπαίους, γυναίκες και μη δυαδικά άτομα. Η αδιαφάνεια του συστήματος και οι λανθασμένες υποθέσεις περί καθολικών εκφράσεων συμπεριφοράς ενίσχυσαν τον κίνδυνο διακρίσεων στα σύνορα της ΕΕ. Αυτό αναδεικνύει την ανάγκη της λογοδοσίας και της διαφάνειας στην ανάπτυξη συστημάτων ΤΝ, έτσι ώστε να μην απειλείτε η ισότητα και η προστασία των ανθρωπίνων δικαιωμάτων τόσο στα σύνορα, όσο και γενικότερα.

3.Ένα τελευταίο και μόνιμα πλέον επίκαιρο εργαλείο που αντανακλά το φαινόμενο των προκαταλήψεών, είναι η κατασκευή των chatbots (πχ ChatGpt).Παρότι κατασκευάστηκαν για να είναι άμεσα, αντικειμενικά και αμερόληπτα , δεν πρέπει να ξεχνάμε πως και αυτά χτίζονται πάνω σε ανθρώπινες μεροληψίες με αποτέλεσμα όχι μόνο να αντικατοπτρίζουν υπάρχουσες προκαταλήψεις, αλλά και να τις ενισχύουν.Πιο συγκεκριμένα όσο ένα σύστημα τροφοδοτείτε με προκατειλημμένα στοιχεία από τον εκπαιδευτή, τα δίνει στον χρήστη και ο χρήστης συνεχίζοντας μια συνομιλία πάνω στα δεδομένα αυτά δημιουργεί ένα φαύλο κύκλο όπου η μεροληψία συνεχίζεται και αναπαράγεται. (bias in – bias out). Έτσι το εργαλείο αυτό, όχι απλά γίνεται εργαλείο μη προόδου, αλλά και μηχανισμός συντήρησης στερεοτύπων σε μεγαλύτερη και ταχύτερη εμβέλεια.

Φυσικά το πρόβλημά αυτό επιτείνεται και από την άνιση εκπροσώπηση των φύλων στον τεχνολογικό τομέα. Το 2019 μόλις το 26% των θέσεων εργασίας στους τομείς των δεδομένων και της τεχνητής νοημοσύνης καταλαμβάνονται από γυναίκες (World Economic Forum 2019), ενώ το 2025 το ποσοστό αυτό καταφέρνει να φτάσει περίπου στο 35% (World Economic Forum 2025). Η αύξηση αυτή θα μπορούσε να χαρακτηριστεί αργή αλλά και μη αντιπροσωπευτική. Μια τέτοια ανισορροπία στην διαδικασία εκπαίδευσης αλγορίθμων σημαίνει ότι απουσιάζει η απαραίτητη ποικιλομορφία που θα εξασφάλιζε πιο ισορροπημένα και συμπεριληπτικά συστήματα.

Περνώντας στην νομική διάσταση

Τώρα περνώντας στην νομική διάσταση επισημαίνεται και η ανάγκη για μια πιο διαθεματική προσέγγιση, καθώς δεν πρέπει να ξεχνάμε πως οι γυναίκες δεν υφίστανται προκατάληψη μόνο λόγω φύλου, αλλά συχνά επιβαρύνονται με επιπλέον εμπόδια αν ανήκουν σε φυλετικές, εθνοτικές ή άλλες μειονεκτούσες ομάδες, αυξάνοντας τον κίνδυνο αποκλεισμού.

Τον Ιούλιο του 2024, περνάει σε ισχύ ο πρώτος ολοκληρωμένος Κανονισμός (2024/1689) στην Ευρωπαϊκή Ένωση σχετικά με την Τεχνητή νοημοσύνη, με σκοπό να ρυθμίσει την λειτουργία των συστημάτων ΤΝ μέσα σε διάφορα πλαίσια. Μέσα στην προσπάθεια αυτή ορίζει κάποια συστήματα και πρακτικές ως απαγορευμένες, και κάποιες ως υψηλού, μετρίου και χαμηλού κινδύνου. Παρατηρώντας κανείς τον κανονισμό αυτό σε βάθος θα εντοπίσει κάποιες ελλείψεις μη συμπερίληψης σχετικά με το φύλο , οι οποίες σχετίζονται κυρίως με την διάσταση της διαθεματικότητας, η οποία αναφέρθηκε και νωρίτερα.

Τα 3 βασικά σημεία που εντοπίζεται αυτό είναι τα άρθρα 5, 6 και 27. Αρχίζοντας με το άρθρο 5 του Νόμου, το οποίο ορίζει τις απαγορευμένες πρακτικές που μπορεί να θέσουν σε κίνδυνο τα θεμελιώδη ανθρώπινα δικαιώματα αλλά και την ασφάλεια των ατόμων παρατηρούμε ότι απαγορεύονται πρακτικές όπως η κοινωνική βαθμολόγηση και η χειραγώγηση ευάλωτων ατόμων. Παρότι κάνει σημαντικά βήματα και ρυθμίζει τη χρήση βιομετρικών συστημάτων που βασίζονται σε ευαίσθητα χαρακτηριστικά (π.χ. φυλή, σεξουαλικός προσανατολισμός), παραλείπει την ρητή αναφορά στο φύλο ως τέτοιο χαρακτηριστικό παρά τις σχετικές συστάσεις του Ευρωπαϊκού Συμβουλίου Προστασίας Δεδομένων. Αυτή η παράλειψη υπογραμμίζει ένα σημαντικό κενό στην προστασία της ισότητας των φύλων, αναδεικνύοντας έντονα την ανάγκη για διατομεακή προσέγγιση που να αντιμετωπίζει τις πολλαπλές μορφές διάκρισης στα συστήματα Τεχνητής Νοημοσύνης.

Το άρθρο 6 τώρα, καθώς ταξινομεί τα συστήματα τεχνητής νοημοσύνης υψηλού κινδύνου, εντοπίζεται να μην απαιτεί κανένα έλεγχο για διακρίσεις λόγω φύλου ή διαθεματικές διακρίσεις. Αντιθέτως, αναφέρεται πολύ γενικά στις αρχές μη διακριτικής μεταχείρισης που δεν εξασφαλίζουν την ουσιαστική ανίχνευση και τον μετριασμό των διακρίσεων λόγω φύλου και των διαρθρωτικών διακρίσεων στην τεχνητή νοημοσύνη υψηλού κινδύνου. Έτσι, η «ουδέτερη ως προς το φύλο» προσέγγιση δεν μπορεί να αποτυπώσει τις πραγματικές ανισότητες που βιώνουν οι περιθωριοποιημένες ομάδες φύλου.

Ολοκληρώνοντας στο άρθρο 27, ο νόμος τονίζει την ανάγκη για εκτίμηση επιπτώσεων των συστημάτων ΤΝ υψηλού κινδύνου, βασισμένη στο ήδη υπάρχων εργαλείο εκτίμησης επιπτώσεων για τα θεμελιώδη δικαιώματα (FRIA) προκειμένου να αξιολογηθούν και να μετριαστούν οι κίνδυνοι διακρίσεων. Ωστόσο, αυτές οι εκτιμήσεις δεν είναι ρητά προσαρμοσμένες για την αντιμετώπιση των διαθεματικών ευπαθειών ή των συστημικών προκαταλήψεων λόγω φύλου που ενσωματώνονται στα δεδομένα και στα συστήματα τεχνητής νοημοσύνης.

Επομένως, αν κάτι γίνεται αντιληπτό από την ανάλυση αυτή είναι, ότι ο Κανονισμός (2024/1689) σχετικά με τη Τεχνητή Νοημοσύνη οφείλει να ενσωματώσει ρητές διατάξεις που να ανταποκρίνονται στις ανάγκες των δύο φύλων. Χωρίς την ενσωμάτωση αυτή αλλά και της διαθεματικότητας, ο νόμος κινδυνεύει να μην προστατεύσει επαρκώς περιθωριοποιημένες ομάδες φύλου, οι οποίες επηρεάζονται δυσανάλογα από τις προκατειλημμένες εφαρμογές της ΤΝ. Ενώ ο νόμος διαθέτει μηχανισμούς για την αναγνώριση και τον μετριασμό ορισμένων ευπαθειών που σχετίζονται με το φύλο, δεν καταφέρνει να προστατέψει επαρκώς την δημιουργία συστημάτων σαν αυτά που αναφέρθηκαν νωρίτερα, πράγμα απαραίτητο για την ολοκληρωμένη αντιμετώπιση των συστημικών και δομικών προκαταλήψεων λόγω φύλου στην ΤΝ.

*Ονομάζομαι Θεοδώρα Τσούτσα, και έχω κάνει το μεταπτυχιακό μου πάνω στα ανθρώπινα δικαιώματα, στο οποίο μεταξύ των άλλων έγραψα την διπλωματική μου σχετικά με τα σύνορα και την τεχνητή νοημοσύνη. Πιο συγκεκριμένα το θέμα ήταν: «Convince the algorithm: How the digitalisation of European Union Borders could be a harmful tool for people on the move and their human rights.» Η έρευνα αυτή με έκανε να ανακαλύψω το ενδιαφέρον που έχω γενικότερα για την συσχέτιση των ανθρωπίνων δικαιωμάτων με την τεχνητή νοημοσύνη και τι κινδύνους μπορεί να εγκυμονεί στο μέλλον.

Η Homo Digitalis μιλάει στο ERTnews

Την Πέμπτη 11.12 η Homo Digitalis είχε τη μεγάλη χαρά να βρίσκεται καλεσμένη στην εκπομπή “LIVE NOW” του ΕΡΤnews με τον Γιώργο Κακούση και τη Νικολέττα Κριτικού για να μιλήσουμε για τις επικείμενες αναθεωρήσεις του προγράμματος απαλλαγής VISA των ΗΠΑ, “ESTA”.

Οι προτεινόμενες αλλαγές προβλέπουν τη συλλογή περισσότερων & ιδιαίτερα ευαίσθητων προσωπικών δεδομένων, όπως βιομετρικά στοιχεία, λογαριασμούς email για τα τελευταία 10 έτη, και λογαριασμούς social media για τα τελευταία 5 έτη, μεταξύ άλλων.

Το πλάνο της κυβέρνησης των ΗΠΑ είναι να έχουν ολοκληρώσει τις διαδικασίες συμφωνιών με τις διάφορες χώρες που συμμετέχουν στο πρόγραμμα απαλλαγής visa ΕSΤΑ εως τον Δεκέμβρη του 2026, προκειμένου οι νέοι κανόνες να ξεκινήσουν να ισχύουν από το επόμενο έτος.

Η Ευρωπαϊκή Ένωση έχει ήδη, από το καλοκαίρι, κινήσει τις προβλεπόμενες θεσμικές διαδικασίες, προκειμένου να διαπραγματευθεί σε ενωσιακό επίπεδο με τις ΗΠΑ το πλαίσιο ανταλλαγής και επεξεργασίας των σχετικών δεδομένων. Το πλαίσιο αυτό αναμένεται να αποτελέσει τη βάση μιας συνολικής συμφωνίας μεταξύ ΕΕ & ΗΠΑ, επί της οποίας θα κληθούν εν συνεχεία τα κράτη μέλη, όπως η Ελλάδα, να συνάψουν τις αναγκαίες διμερείς συμφωνίες για την εφαρμογή του νέου καθεστώτος του προγράμματος ESTA.

Στον τομέα της προστασίας προσωπικών δεδομένων, ο Ευρωπαίος Επόπτης Προστασίας Δεδομένων, έχει ήδη από τον Σεπτέμβριο εκδώσει σχετική γνωμοδότηση επί του ζητήματος. Η εν λόγω γνωμοδότηση εστιάζει πρωτίστως στην ανταλλαγή βιομετρικών δεδομένων, καθώς και στις αναγκαίες εγγυήσεις ασφάλειας, ελέγχου και λογοδοσίας που οφείλουν να συνοδεύουν την επεξεργασία τους.

Στην εκπομπή μας εκπροσώπησε ο Εκτελεστικός μας Διευθυντής, Λευτέρης Χελιουδάκης. Ευχαριστούμε θερμά για την πρόσκληση! Μπορείτε να παρακολουθήσετε το σχετικό απόσπασμα εδώ (47:00 επόμενα) εδώ.

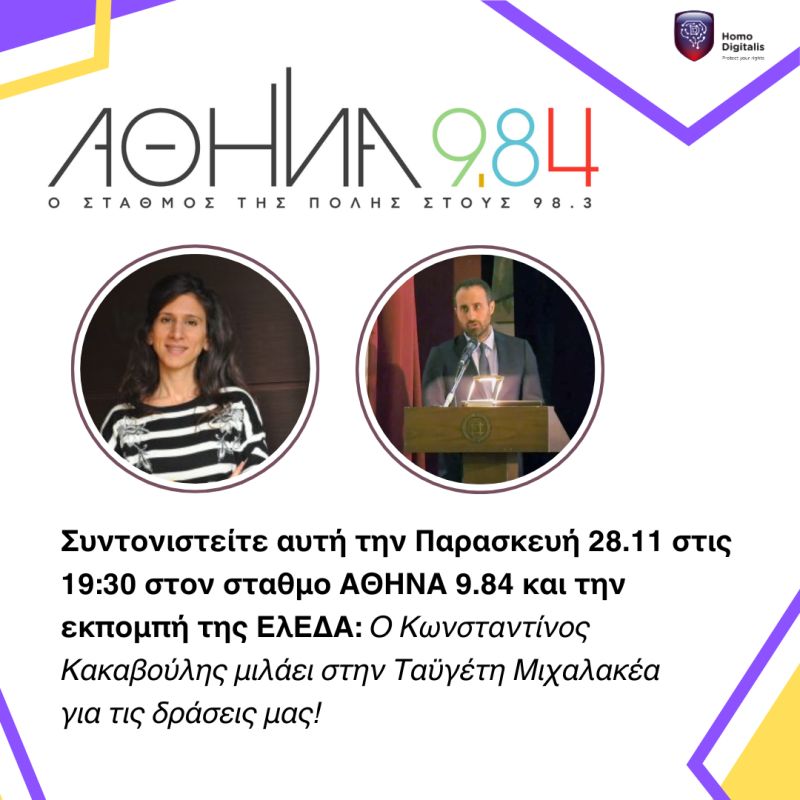

Η Homo Digitalis δίνει συνέντευξη στον ΑΘΗΝΑ 9.84

Αυτή την Παρασκευή 28/11 στις 19:30 συντονιζόμαστε στον AΘΗΝΑ 9.84!

H Homo Digitalis έχει τη μεγάλη χαρά να βρίσκεται καλεσμένη στη ραδιοφωνική εκπομπή της Ελληνικής Ένωσης για τα Δικαιώματα του Ανθρώπου (ΕλΕΔΑ) για να μιλήσουμε για τις δράσεις μας στον τομέα των ψηφιακών δικαιωμάτων!

Ο Συνιδρυτής και Ταμίας του ΔΣ μας, Κωνσταντίνος Κακαβούλης θα μας εκπροσωπήσει εκεί, ενώ την εκπομπή συντονίζει το Μέλος ΔΣ της ΕλΕΔΑ, Ταϋγέτη Μιχαλακέα! Ευχαριστούμε θερμά για την ευγενική πρόσκληση και το τιμητικό ενδιαφέρον για τις δράσεις μας!

Η Homo Digitalis σε εργαστήριο εμπειρογνωμόνων για την αξιολόγηση μοντέλων ΤΝ

Στα μέσα Οκτωβρίου, η Homo Digitalis είχε τη μεγάλη τιμή να συμμετάσχει σε ένα εργαστήριο εμπειρογνωμόνων που πραγματοποιήθηκε στο Weizenbaum Institute, συμβάλλοντας σε μια ιδιαίτερα ενδιαφέρουσα πρωτοβουλία για τη συμμετοχική αξιολόγηση της ΤΝ (AI auditing).

Οι ερευνητές Goda Klumbytė (University of Kassel) και David Hartmann (Technische Universität Berlin) πραγματοποίησαν συνεντεύξεις με φορείς και ένα εργαστήριο συν-σχεδιασμού, με στόχο τη συλλογική ανάπτυξη ενός εργαλείου που θα υποστηρίζει οργανώσεις της κοινωνίας των πολιτών στην καλύτερη κατανόηση και αξιολόγηση συστημάτων ΤΝ και GenAI.

Η ομάδα μας παρουσίασε τη μεθοδολογία που εφαρμόζουμε για τη διερεύνηση της έλλειψης νομικής συμμόρφωσης σε συστήματα ΤΝ και GenAI, αναδεικνύοντας βασικές επιτυχίες από τις νομικές μας παρεμβάσεις σε εθνικό επίπεδο.

Παράλληλα, συζητήσαμε τη συνεχιζόμενη πρωτοβουλία μας για τη συνδημιουργία ενός δικτύου οργανώσεων της κοινωνίας των πολιτών στην Ελλάδα, με στόχο την ένωση τεχνογνωσίας και πόρων, την οικοδόμηση εμπιστοσύνης και τη συνεργασία για την αντιμετώπιση παρεμβατικών εργαλείων GenAI. Τη Homo Digitalis εκπροσώπησαν στην εκδήλωση η Μαρία Μουχίκα και ο Λευτέρης Χελιουδάκης.

Ευχαριστούμε θερμά τους διοργανωτές για την ευγενική πρόσκληση και για τη δημιουργία ενός συνεργατικού ακαδημαϊκού περιβάλλοντος, όπου οι φωνές της κοινωνίας των πολιτών συμβάλλουν ουσιαστικά στη διαμόρφωση πρακτικών λογοδοσίας και υπευθυνότητας στην Τεχνητή Νοημοσύνη.

ΔΤ μας για την σημερινή ανακοίνωση των πακέτων Digital Omnibus

Οι προτεινόμενες διατάξεις του DigitalOmnibus δόθηκαν σήμερα στη δημοσιότητα και τα δικαιώματα καθώς και οι εγγυήσεις προστασίας μας στο ψηφιακό περιβάλλον τίθενται πλέον σε σοβαρό κίνδυνο.

Οι νέες αυτές προτεινόμενες ρυθμίσεις απειλούν τον πυρήνα του ευρωπαϊκού πλαισίου προστασίας δεδομένων και μίας σειράς άλλων δικαιωμάτων στον ψηφιακό χώρο, επηρεάζοντας άμεσα διατάξεις όπως ο GDPR, η Οδηγία ePrivacy και η AIAct.

Η υπάρχουσα, ευρύτερη ατζέντα απορρύθμισης της Ευρωπαϊκής Επιτροπής υπηρετεί κατά κύριο λόγο τα συμφέροντα των μεγάλων εταιριών τεχνολογίας παραμερίζοντας τα θεμελιώδη δικαιώματα. Με αυτές τις επιλογές, η Ευρωπαϊκή Επιτροπή ουσιαστικά παρεκκλίνει από την αποστολή της και αδυνατεί να εκπληρώσει την θεσμική της υποχρέωση!

Καλούμε το Συμβούλιο της Ευρωπαϊκής Ένωσης και το Ευρωπαϊκό Κοινοβούλιο να απορρίψουν αυτή την απόπειρα αποδόμησης του ευρωπαϊκού πλαισίου Ψηφιακών Δικαιωμάτων, και να επικεντρωθούν αντίθετα στη σταθερή και αποτελεσματική εφαρμογή των ήδη υφιστάμενων κανόνων.

Διαβάστε το αναλυτικό δελτίο Τύπου μας εδώ.

Κοινή Ανοιχτή Επιστολή για τα Πακέτα Digital Omnibus στην Ευρωπαϊκή Επιτροπή

Την Τετάρτη 19/11, η Ευρωπαϊκή Επιτροπή παρουσιάζει το νέο “Digital Omnibus”, μια μεταρρύθμιση που απειλεί να ξηλώσει θεμελιώδεις προστασίες δικαιωμάτων και ελευθεριών μας στον ψηφιακό χώρο.

Τον Μάιο και τον Οκτώβριο του 2025 προειδοποιήσαμε με ανοιχτές επιστολές ότι η πρωτοβουλία αυτή αποτελεί μέρος ενός ευρύτερου κύματος απορρύθμισης που θα αποδυναμώσει βασικούς ευρωπαϊκούς κανόνες, παρουσιάζοντας τα δικαιώματα ως εμπόδιο στην καινοτομία & εξυπηρετώντας τα συμφέροντα των μεγάλων τεχνολογικών εταιριών.

Πριν λίγες ημέρες, διαρροές draft εγγράφων επιβεβαίωσαν τους φόβους μας: η ΕΕ βρίσκεται ένα βήμα πριν από τη μεγαλύτερη οπισθοχώρηση στην προστασία των ανθρωπίνων δικαιωμάτων στον ψηφιακό χώρο. Ο GDPR, το ePrivacy και ακόμη και οι ήδη αδύναμες διατάξεις του AI Act φαίνεται να μπαίνουν στο στόχαστρο αποδυνάμωσης, ενώ στο στόχαστρο βρίσκονται και άλλες σχετικές νομοθεσίες.

Μαζί με την European Digital Rights 127 οργανώσεις, συνδικάτα, ακαδημαϊκοί και εταιρίες ενώνουν τις φωνές τους και ζητούν από την Ευρωπαϊκή Επιτροπή να σταματήσει άμεσα κάθε προσπάθεια υποβάθμισης των βασικών ψηφιακών δικαιωμάτων όλων μας που ευνοούν μόνο τα επιχειρηματικά μοντέλα μεγάλων εταιρικών κολοσσών.

Διάβασε εδώ την επιστολή μας.

Συμμετοχή της Homo Digitalis σε Ομάδα Εργασίας του AI Office της Ευρωπαϊκής Επιτροπής

Είμαστε ενθουσιασμένοι να μοιραστούμε ότι την περασμένη εβδομάδα η Homo Digitalis, εκπροσωπούμενη από το μέλος μας Τάνια Σκραπαλιώρη, συμμετείχε στην εναρκτήρια ολομέλεια (Kick-off Plenary) του Γραφείου Τεχνητής Νοημοσύνης της Ευρωπαϊκής Επιτροπής για τη σύνταξη του Κώδικα Πρακτικής σχετικά με Υποχρεώσεις διαφάνειας για παρόχους και φορείς εφαρμογής ορισμένων συστημάτων ΤΝ.

Ανυπομονούμε να συμμετάσχουμε στις αντίστοιχες ομάδες εργασίας και να συμβάλουμε ενεργά σε αυτή τη διαδικασία.

Κατά τη διάρκεια της συνεδρίασης, οι συμμετέχοντες ενημερώθηκαν από το Γραφείο ΤΝ, γνώρισαν τους Προέδρους και Αντιπροέδρους που είναι υπεύθυνοι για τη σύνταξη του Κώδικα και έλαβαν γνώση των συμπερασμάτων που προέκυψαν από την πρόσφατη πολυσυμμετοχική διαβούλευση σχετικά με τις απαιτήσεις διαφάνειας.

Συνδιοργανώνουμε και συμμετέχουμε στο Tech & Society Summit στις Βρυξέλλες

Το Tech and Society Summit πλησιάζει, και θα πραγματοποιηθεί την Τρίτη, 1 Οκτωβρίου στις Βρυξέλλες! Αυτό το συναρπαστικό συνέδριο, που συνδιοργανώνεται από την EDRi σε συνεργασία με τη Homo Digitalis και περισσότερους από άλλους 40 οργανισμούς, θα συγκεντρώσει κορυφαίους ειδικούς, πολιτικούς και υπερασπιστές των Δικαιωμάτων του Ανθρώπου για να συζητήσουν τη σύνδεση μεταξύ τεχνολογίας και κοινωνικών επιπτώσεων στην Ευρώπη. Το συνέδριο θα καλύψει κρίσιμα θέματα, από τα ψηφιακά δικαιώματα και τη κλιματική αλλαγή έως τις ρυθμίσεις για την τεχνητή νοημοσύνη, συμβάλλοντας στη διαμόρφωση ενός δίκαιου και ισότιμου ψηφιακού μέλλοντος για όλους.

Είμαστε ενθουσιασμένοι που ο Λευτέρης Χελιουδάκης θα εκπροσωπήσει τη Homo Digitalis ως ομιλητής στη συνεδρία Visionary Roundtable: Building an EU Digital Enforcement Strategy. Με σημαντικούς νόμους όπως το Digital Markets Act (DMA), το Digital Services Act (DSA) και το AI Act, ο Λευτέρης θα αναδείξει τις δράσεις της Homo Digitalis συζητώντας για το πώς αυτές οι ρυθμίσεις μπορούν να προστατεύσουν αποτελεσματικά τα δικαιώματα και να ενισχύσουν την ανταγωνιστικότητα της Ευρώπης στον ψηφιακό χώρο.

Επιπλέον, η Homo Digitalis είναι προσκεκλημένη να συμμετάσχει στη συνεδρία Fundamental Rights in Focus: Joint Efforts for Spyware Regulation in the EU, που συνδιοργανώνεται από το Centre for Democracy & Technology Europe (CDT Europe) και τη Διεθνή Αμνηστία. Στη συνεδρία αυτή, θα συναντηθούν βασικοί πολιτικοί και εκπρόσωποι της κοινωνίας των πολιτών για να εξερευνήσουν τους τρόπους ρύθμισης των spyware στην ΕΕ, και θα συζητήσουμε τις εμπειρίες μας από τις σχετικές τελευταίες εξελίξεις στην Ελλάδα.

Μπορείτε να διαβάσετε περισσότερα για το Tech and Society Summit και να δείτε το πρόγραμμά του εδώ.